Современные распределенные объектные/файловые/блочные и key-value хранилища – кластер Lightbits (часть 5)

Введение

Компания Lightbits Labs (Lightbits, https://www.lightbitslabs.com/) была образована в 2016 г. и свои первые продукты представила в 2019 г. Lightbits была инициатором и основным разработчиком стандарта NVMe® over TCP (NVMe/TCP), а также первым вендором, реализовавшим кластерную блочную СХД на базе протокола NVMe/TCP.

Решение Lightbits позиционируется как программно-определяемая дезагрегированная кластерная СХД, которая может быть развернута на стандартных серверах (расширенных энергонезависимой памятью и сетевыми ускорителями) с использованием NVMe/TCP-протокола и без какой-либо модификации приложений. Кластер может масштабироваться от 3 до 16 узлов.

Отличительной особенностью решения Lightbits является использование энергонезависимой памяти SCM (Storage Class Memory) для хранения метаданных, сетевых ускорителей и встроенной функции Intelligent Flash Management™, которая увеличивает срок службы флэш-памяти (оптимизация QLC NAND SSD) в 20 раз (https://www.lightbitslabs.com/product/).

В первых реализациях Lightbits использовались ускорители LightField – PCIe AIC (add-in-card), которые были разработаны на базе Intel® Agilex™ FPGA и устанавливались непосредственно в узлы хранения Lightbits.

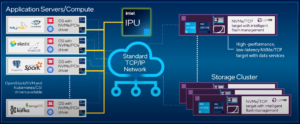

В сентябре 2022 г. Lightbits было анонсировано [1] использование интерфейсных карт Intel IPU E2000 (новый брэнд для Mount Evans DPU IPU, Infrastructure Processing Unit; уже с ASIC). Доступность ускорителей Intel IPU E2000 в составе серверов основных мировых интеграторов – 2023 г. (первые партии Intel IPU E2000 были поставлены Google, т.к. Intel IPU E2000 – это совместная разработка Intel и Google). Карты Intel IPU E2000, в отличие от ускорителей LightField, уже устанавливались (рис. 1) в серверы приложений (не в составе кластера Lightbits). Это позволило повысить эффективность сервисных операций Lightbits. В составе комплектации узлов Lightbits осталось использование сетевых адаптеров Ethernet на базе контроллеров Intel E810 с улучшенной поддержкой виртуализации, включая VMDq и SR-IOV, а также с функцией очереди устройств (ADQ, application device queue) для создания выделенной очереди для высокоприоритетного трафика приложений, обеспечивая стабильную низкую задержку и повышая пропускную способность.

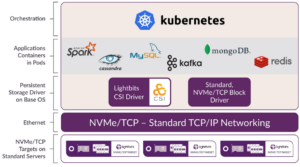

Рис. 1. Структурная схема развертывания кластера Lightbits [2].

В апреле 2023 г. Lightbits® была выбрана (https://www.lightbitslabs.com/press-releases/lightbits-cloud-data-platform-wins-overall-data-storage-solution-of-the-year-award-for-two-years-running) победителем в номинации «Общее решение для хранения данных года» в рамках четвертой ежегодной программы Data Breakthrough Awards (https://databreakthroughawards.com/2023-winners/), получив эту престижную награду второй год подряд. Ежегодная премия Data Breakthrough Awards — это главная программа награждения, созданная для признания новаторов, лидеров и провидцев в области технологий данных со всего мира в различных категориях, включая аналитику данных, большие данные, бизнес-аналитику, хранение данных и многие другие. В этом году программа получила более 2000 номинаций со всего мира.

Платформа Lightbits Cloud Data Platform была отмечена в качестве лидера, поскольку она обеспечивает маневренность, гибкость, высокую производительность, а также предсказуемость и низкие затраты, что позволяет выполнять миграцию в общедоступное облако для аналитических, транзакционных и ресурсоемких рабочих нагрузок баз данных. Программно-определяемая, дезагрегированная и масштабируемая архитектура обеспечивает динамическое масштабирование производительности и емкости хранилища с неизменно низкой задержкой и работает в большинстве сред оркестровки, таких как Kubernetes, VMware или OpenStack. Она предлагает возможность предоставлять высокопроизводительные постоянные тома для приложений, защищая данные от сбоев, и в то же время предлагает широкий спектр услуг по работе с данными, которые необходимы корпоративным ИТ-организациям. Lightbits прост в использовании, подключается непосредственно к виртуальным машинам (VM) и поддерживает гибридные развертывания, предлагая гибкость переноса лицензии на программное обеспечение между локальными серверами хранения и оптимизированными для хранения Amazon Web Services (AWS) или виртуальными машинами Microsoft Azure, что позволяет клиентам переходить в облако в своем темпе и на своих условиях.

Также в апреле 2023 г. Lightbits® была включена в ежегодный список CRN 2023 Storage 100 (http://www.crn.com/storage100) в категории “50 самых крутых поставщиков программно-определяемых хранилищ”. “Список CRN 2023 Storage 100 отмечает ведущих поставщиков, которые внедряют революционные достижения в технологии хранения и предлагают клиентам и поставщикам современные решения, рассчитанные на будущее, — сказал Блейн Рэддон (Blaine Raddon), генеральный директор The Channel Company. – Для нас большая честь признать их вклад в качестве ведущих игроков в области технологий хранения на 2023 год”.

9 мая 2023 г. стала доступна (https://www.lightbitslabs.com/blog/lightbits-v3-2-1-release-announcement/) версия Lightbits v3.2.1, в которую были добавлены следующие функции и возможности для Lightbits, работающие в общедоступном облаке (AWS, Azure) и локально:

- инкрементное резервное копирование и восстановление для AWS

– возможность резервного копирования и восстановления целых томов Lightbit в AWS S3 и обратно, а также возможность добавочных резервных копий и их восстановление. При резервном копировании тома, резервная копия которого уже выполнялась ранее, в S3 отправляются только те данные, которые были изменены (т.е. только добавочные изменения), что делает резервное копирование и восстановление более эффективным и экономичным;

- предварительная версия поддержки CrossAvailability Zone (AZ)

– возможность растянуть кластер Lightbits на несколько зон доступности AWS. Кластер в разных зонах доступности остается функциональным и доступным, а его данные остаются защищенными даже в случае сбоя всей зоны доступности. Хотя перебои в работе зон доступности случаются относительно редко, всем, кому нужны более надежные гарантии доступности и надежности, стала доступна эта опция;

- шифрование на стороне клиента и MultiAttach с помощью плагина Lightbits K8s CSI. Многие поставщики облачных услуг и пользователи хотели бы защитить конфиденциальность своих данных, сохраняя только зашифрованные данные на своих платформах облачных данных. Хотя всегда можно было хранить зашифрованные данные в Lightbits, в выпуске v2.1 плагин Lightbits CSI может шифровать клиентские данные перед их отправкой по сети в кластер хранения Lightbits, чтобы клиентские данные никогда не передавались по сети или хранились незащищенным. Кроме того, поскольку шифрование/дешифрование автоматически организуется подключаемым модулем CSI Lightbits — при соответствующей настройке — никаких дополнительных усилий со стороны клиента не требуется.

При использовании плагина Lightbits k8s CSI в блочном режиме, в отличие от режима файловой системы, удобно иметь возможность подключать несколько узлов k8s к одному блочному устройству Lightbits. Эта возможность, известная как multi-attach или MULTI_NODE_MULTI_WRITER на языке k8s CSI, теперь поддерживается подключаемым модулем CSI;

- полная поддержка нескольких арендаторов с помощью подключаемого модуля Lightbits vCenter, начиная с версии подключаемого модуля v3. Ранее для плагина требовались полные привилегии администратора кластера Lightbits, теперь можно воспользоваться встроенной поддержкой Lightbits для мультиарендности с плагином vCenter, предоставляя полный доступ к хранилищу для кластеров VMware, используемых несколькими арендаторами;

- FrontEnd компрессия. До выпуска v2.1 программное сжатие выполнялось на уровне Lightbits IFM (Intelligent Flash Management), на бэкенде. Это означало, что для любого реплицированного тома одни и те же данные были независимо сжаты каждым узлом кластера Lightbits, содержащим реплику данных.

В выпуске v3.2.1 были внесены некоторые архитектурные улучшения. Сжатие и другие службы обработки данных были перенесены в сетевые компоненты программного стека Lightbits (интерфейс), сохранив при этом те же алгоритмы сжатия и форматы данных. Сжатие данных на внешнем интерфейсе означает, что данные нужно сжать только один раз, независимо от количества копий данных, которые впоследствии реплицируются и распределяются в кластере. Таким образом, внешнее сжатие дает более эффективные кластеры и более низкие затраты на передачу данных, особенно для кластеров, растянутых по нескольким зонам доступности.

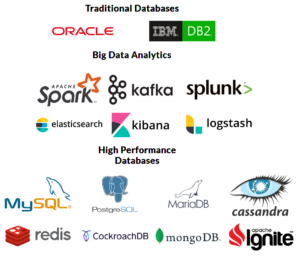

Среди поддерживаемых нагрузок кластером Lightbitslabs: высокопроизводительные базы данных, традиционные базы данных, аналитика больших данных (рис. 2).

Рис. 2. Поддерживаемые нагрузки кластером Lightbitslabs.

Lightbits предлагает богатые услуги по работе с данными: тонкое выделение ресурсов, сжатие, эластичный RAID для защиты дисков от сбоев, репликация тома (1x, 2x или 3x) на том, QoS.

Один узел в кластере Lightbits с включенной избыточностью может обслуживать до 4,7 млн IOPs при чтении по 4 КБ, до 760 000 IOPs при записи по 4 КБ, до 21 ГБ/с при чтении и до 4,3 ГБ/с при записи.

Производительность кластера Lightbits:

- 75 млн IOPs при произвольном чтении 4K;

- 12 млн IOPs при произвольной записи 4K;

- пропускная способность чтения 336 ГБ/с;

- пропускная способность записи 68 ГБ/с.

Преимущества дезагрегированного хранилища для облачных приложений:

- возможность масштабирования вычислительных ресурсов и хранилища независимо друг от друга;

- возможность использования существующей сети TCP/IP при работе на любом стандартном оборудовании;

- один кластер хранения может обслуживать несколько арендаторов и разнородные среды приложений;

- высокие IOPs, стабильно низкая задержка;

- высокая степень использования хранилища как емкости, так и производительности;

- репликация и восстановление на основе хранилища;

- интеллектуальное управление флэш-памятью и расширенные службы данных, повышенная надежность флэш-памяти, более низкая совокупная стоимость владения.

Архитектура кластера Lightbits

Кластер Lightbits строится на базе Lightbits Labs LightOS™ и представляет собой программно-определяемое блочное высокопроизводительное, масштабируемое NVMe/TCP хранилище с резервированием, которое работает как локальная флэш-СХД, упрощая управление инфраструктурой и снижая затраты [3]. Масштабируемость кластера – от 3 до 16 узлов.

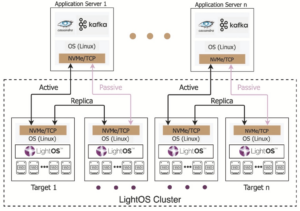

Селективная высокая доступность на стандартных серверах

LightOS – это первое в мире программно-определяемое NVMe/ TCP хранилище, обеспечивающее полное резервирование как от сбоев дисков, так и от сбоев целевого сервера хранилища (рис. 3). Это достигается с помощью асимметричного доступа к пространству имен (ANA, Asymmetric Namespace Access), чаще всего многопутевого ввода-вывода. ANA является частью спецификации NVMe (1.4) для локального NVMe на основе PCIe, а также для межкомпонентных сетей со спецификацией 1.1 NVMeoF. Если для томов LightOS установлено значение 2x или 3x репликации, сервер приложений, использующий драйвер NVMe/TCP, знает о нескольких сетевых путях к идентификатору логического тома (пространства имен). Один путь будет активным (оптимизированным), а дополнительные 1 или 2 других пути будут пассивными (неоптимизированными).

Переключение сетевого канала/пути при отказе также может быть упрощено (при желании) с помощью методов связывания портов (таких как LACP) с LightOS.

Для дисков LightOS использует эластичный RAID на каждом целевом сервере для защиты от сбоев дисков. Этот адаптируемый алгоритм кодирования стирания (erasure coding) регулирует и повторно балансирует в ответ на сбой (или удаление) дисков и добавление дисков. Эти функции, работающие в унисон, приводят к созданию полностью избыточного решения для хранения данных с чрезвычайно высоким уровнем доступности, основанного на стандартных компонентах и серверах. Для создания высокодоступного, высокопроизводительного и масштабируемого решения для блочного хранения с помощью LightOS не требуются специальные диски с двойным доступом (“dual path”) или специальное шасси.

Рис. 3. Схема обеспечения доступности в кластере LightOS.

Большой набор сервисов данных

Снижение совокупной стоимости владения достигается не только за счет улучшения использования емкости и производительности. LightOS предлагает обширные сервисы обработки данных, которые обычно не связаны с хранилищем NVMe, с задержками производительности NVMe. Все логические тома LightOS имеют тонкое выделение ресурсов (thin provisioned), и в сочетании с поддержкой сжатия (которая может быть включена/отключена для каждого тома) LightOS может достичь общего уровня сокращения данных до 10:1 как в средах сервис провайдеров, так в частных облаках.

LightOS 2.2 позволяет пользователям создавать снимки и клоны, занимающие меньше места. Она поддерживает до 1024 снимков и/или клонов на одном томе и до 128000 снимков и клонов на кластер. Для создания моментального снимка только для чтения требуется несколько секунд, при этом сохраняются только метаданные трассировки. Изменения, примененные к родительскому тому, отражаются в снимке в блоках по 4 КБ с соответствующим использованием емкости хранилища снимков.

Для приложений резервного копирования моментальные снимки можно планировать, изолировать от производственных рабочих процессов и надежно выполнять резервное копирование в фоновом режиме. Также можно быстро и легко вернуться к более ранним моментальным снимкам/восстановить их по мере необходимости, помогая поддерживать время безотказной работы и пороговые значения качества обслуживания (QoS), которые в противном случае могли бы быть скомпрометированы в результате событий потери или повреждения данных.

Тонкие клоны – это записываемые снимки. Они потребляют емкость флэш-памяти, при этом изменения применяются к родительскому элементу или самому клону. Принимая во внимание, что 100 клонов образа 10 ГБ потребляли бы 1 ТБ, LightOS позволяет поддерживать общий объем хранилища 10 ГБ для всех 101 изображений, выделяя дополнительную емкость хранилища для 100 клонов только по мере применения изменений.

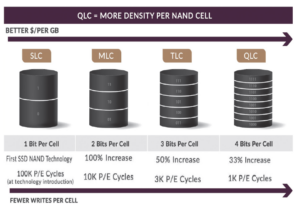

Доступность QLC флэш

Флэш-память QLC недорога, но часто не подходит для использования локально на серверах приложений, где шаблон записи невелик или непредсказуем. Производительность записи флэш-памяти QLC оставляет желать лучшего по сравнению с более дорогими устройствами TLC и MLC. Наконец, если шаблоны записи не являются последовательными и большими порциями, носитель QLC может быстро изнашиваться. Таким образом, трудно воспользоваться преимуществами более низкой стоимости флэш-памяти QLC непосредственно на серверах приложений, особенно в сервисных средах (рис. 4).

LightOS снижает стоимость, позволяя использовать флэш QLC в узлах LightOS. LightOS гарантирует, что все записи выполняются на носитель QLC последовательно и большими порциями, увеличивая срок службы QLC до 5 раз. За счет объединения операций записи на несколько устройств LightOS обеспечивает высокую производительность записи с постоянным временем отклика. Таким образом, LightOS позволяет использовать недорогие носители QLC без ущерба для производительности или долговечности.

Рис. 4. Сравнение различных флэш-технологий.

Снижение ТСО

LightOS снижает общую стоимость владения как при первоначальной покупке, так и со временем за счет большей операционной эффективности. Среды серверов приложений с локальным NVMe часто используются только на 15-25%. При переходе на кластерное централизованное хранилище LightOS значительно улучшается использование емкости и производительности.

Это означает, что на флэш-память NVMe тратится меньше денег, но при этом обеспечивается более эффективная операционная среда. Функции высокой доступности означают, что серверы и приложения остаются доступными даже в случае сбоев дисков, а приложения не привязаны к определенному серверному оборудованию.

LightOS предоставляет свободу адаптации конфигурации узлов хранения к уникальным потребностям любой среды. Узлы хранения могут быть сконфигурированы со стандартными накопителями NVMe, сетевыми интерфейсными картами (NIC) и в различных форм-факторах. Различные серверы LightOS в одном кластере могут иметь разное количество и размер дисков, и диски могут быть добавлены на лету, когда это необходимо (рис. 5).

Рис.5. Варианты комплектации узлов хранения при использовании серверов Supermicro [4].

LightOS – решение, основанное на стандартах для клиентских серверов и коммутаторов

LightOS реализует NVMe over Fabrics (NVMe-oF) с использованием протокола TCP в сети Ethernet (NVMe/TCP). Другие решения NVMe-oF, для которых требуются протоколы RDMA (RoCE или iWarp), требуют специальных сетевых адаптеров Ethernet от ограниченного набора поставщиков и являются более дорогими, чем их аналоги без RDMA. Протокол RoCE также требует специальных настроек сетевого коммутатора.

LightOS NVMe/TCP не только использует те же сетевые карты и инфраструктуру, которые могут использоваться протоколами, такими как iSCSI, но и драйвер блока сервера приложений также является 100% стандартным и включен во все основные последние дистрибутивы Linux. Таким образом, на серверах приложений нет специального программного обеспечения. Обновления просты, поскольку необходимые драйверы входят в состав дистрибутивов Linux и в исходном ядре. Сетевые коммутаторы не требуют каких-либо специальных настроек для протокола хранения NVMe/ TCP.

Поддержка сред для “голого железа”, контейнеров и виртуальных сред

LightOS удовлетворяет потребности службы приложений Linux независимо от типа развертывания. LightOS – это набор пакетов, который применяется к популярным дистрибутивам Linux, включая Red Hat Enterprise Linux, CentOS, Ubuntu, SUSE SLES, OpenSuse, Debian и Fedora. LightOS поставляется с плейбуками Ansible для работы с «голым железом» и образами.

Среды виртуализации, такие как Openstack и KVM/QEMU, поддерживаются через драйвер Cinder. Kubernetes и другие среды оркестровки контейнеров изначально поддерживаются постоянным хранилищем LightOS через CSI.

Для облака (общедоступного или частного) масштабируемость сред Openstack и Kubernetes является ключевым фактором, и LightOS решает эти проблемы масштабируемости, поддерживая до 32K клиентских подключений на целевой сервер и до 64K логических томов на кластер. Клиенты могут свободно подключаться к не скольким кластерам одновременно, поэтому масштабируемость емкости и производительности практически безграничны.

Поддерживаются среды Microsoft Windows.

Развертывание NVMe/TCP инициатора на серверах Kubernetes

Lightbits Labs разработала NVMe/TCP и внесла его в вышестоящее ядро, поэтому он является открытым исходным кодом и является частью стандартного ядра Linux, начиная с ядра 5.0. Многие варианты корпоративной Linux с тех пор портировали блочный драйвер на более ранние ядра в своих дистрибутивах. К ним относятся Red Hat Enterprise Linux, CentOS, Ubuntu, SUSE SLES, OpenSuse, Debian и Fedora (рис. 6). Независимо от того, какой базовый дистрибутив Linux используется в Kubernetes, драйвер NVMe/TCP уже существует или его можно легко получить.

NVMe/TCP использует те же сетевые карты и инфраструктуру, которые могут использоваться такими протоколами, как iSCSI. Сетевые коммутаторы не требуют каких-либо специальных настроек для протокола хранения NVMe/TCP. Целевое программное обеспечение LightOS NVMe/TCP – это набор программных пакетов, применяемых к базовому дистрибутиву Linux, например, перечисленным выше.

Рис. 6. Стек Kubernetes, NVMe/TCP initiator, CSI и Lightbits NVMe/TCP [5].

Высокая производительность

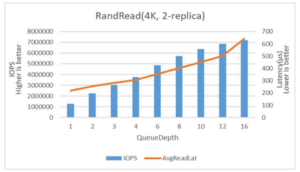

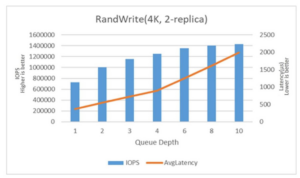

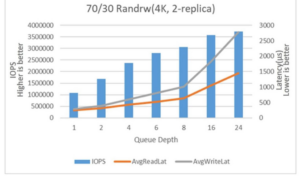

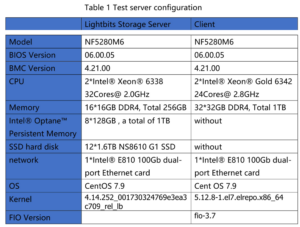

Результаты тестирования одного узла Lightbits развернутого на сервере Inspur NF5280M6 с использованием бэнчмарка FIO представлены на рис. 7, 8, 9 и в табл. 1, 2 [6].

Рис. 7. Тест производительности: 4KB data block, 2replica volume, 100% random read.

Рис. 8. Тест производительности: 4KB data block, 2replica volume, 100% random write.

Рис. 9. Тест производительности: 4KB data block, 2replica volume, 70/30 random read write mix.

Intel IPU E2000 и Lightbits

В конце сентября 2022 г. компания Lightbits Labs® (Lightbits) провела [1] демонстрацию своей программно-определяемой кластерной системы хранения данных Lightbits NVMe/TCP, оснащенной интерфейсными картами Intel IPU E2000, которая позволяет высвобождать ядра CPU и максимизировать прикладную эффективность без ущерба для производительности приложений (рис. 10, 11) [7, 8].

Рис. 10. Intel IPU E2000.

Рис. 11. Архитектура Intel IPU E2000.

Поставщики облачных услуг (CSP, Cloud Service Providers) стремятся сокращать потребление ресурсов CPU, выделяемых для обработки хранилища, тем самым предоставляя больше циклов CPU для запуска клиентских приложений. В совместном решении Lightbits и Intel при использовании Intel IPU E2000 количество ядер было уменьшено более чем в 4 раза в сравнении с решением без Intel IPU E2000. Также были продемонстрированы расширенные возможности динамического пре доставления ресурсов хранения в облачных развертываниях с функциями: автомасштабирования емкости без overprovisioning, оплатой только за используемую емкость, встроенной компрессией и thin provisioning (“тонким” выделением ресурсов).

Решение можно использовать в качестве высокопроизводительной платформы данных для любой среды оркестровки, такой как OpenStack, или для запуска приложений на основе контейнеров в среде Kubernetes, а также виртуализированных приложений в среде VMware vSphere.

С преобладанием облачных приложений и высоко виртуализированных сред значительный объем серверных ресурсов расходуется на обработку задач, выходящих за рамки пользовательских приложений. Другие проблемы с инфраструктурой исходят от традиционных центров обработки данных и поставщиков облачных хранилищ, использующих DAS для приложений, чувствительных к производительности. Такой подход приводит к нехватке емкости и плохому использованию флэш-памяти без централизованного управления службами данных. Чтобы решить эту проблему, Intel объединилась с Lightbits для создания комплексной SDS и интеграции IPU для разгрузки инфраструктурных приложений. IPU — это эволюционный скачок, который предлагает полную разгрузку инфраструктуры.

Intel IPU E2000 — это первое устройство Intel ASIC IPU, продукт 200G, разработанный совместно с Google и находящийся в производстве с 2022 года. Intel® IPU E2000 использует интегрированные знания нескольких поколений Intel® FPGA SmartNIC для обеспечения высокой производительности при реальных рабочих нагрузках с безопасностью и изоляцией. Это программируемое сетевое устройство позволяет поставщикам облачных услуг и услуг связи сократить накладные расходы и повысить производительность центральных процессоров. Среди ключевых особенностей:

- технологические инновации: высокопрограммируемый механизм об работки пакетов, интерфейс хранилища NVM Express, расширенный за счет технологии Intel® Optane™, надежный транспорт нового поколения, усовершенствованное шифрование и ускорение сжатия;

- дизайн программного обеспечения с открытым исходным кодом: комплект для разработки инфраструктурных программ (IPDK, Infrastructure Programmer Development Kit). Это открытый, не зависящий от поставщика фреймворк драйверов и API для разгрузки и управления инфраструктурой, работающий на CPU, IPU, DPU или коммутаторе. IPDK работает в Linux и использует набор хорошо зарекомендовавших себя инструментов, таких как SPDK, DPDK и P4, для обеспечения виртуализации сети, виртуализации хранилища, предоставления рабочей нагрузки, корневого доверия и возможностей разгрузки, имеющихся на платформе. IPDK предоставляет общую платформу для повышения производительности, оптимизации ресурсов и защиты инфраструктуры в качестве подпроекта Open Program mable Infrastructure, проекта Linux Foundation (https://ipdk.io/).

Intel IPU E2000 имеет богатый конвейер обработки пакетов, удаленный прямой доступ к памяти (RDMA) и возможности хранения, включая разгрузку NVMe, а также вычислительный комплекс на базе ARM Neoverse, позволяющий программному обеспечению заказчика выполнять функции, начиная от сложных конвейеров обработки пакетов и заканчивая транспортировкой данных и управлением устройствами. Подключенные к IPU клиенты могут варьироваться от вычислительных хостов для предоставления инфраструктуры как услуги, дисков хранения для обеспечения доступа к целевому хранилищу, ускорителей, таких как графические процессоры или GPU для обеспечения доступа к специализированным функциям обработки, или даже функционировать как чистая система на кристалле, обслуживающая специализированные устройства или нижестоящие устройства, такие как интеллектуальные коммутаторы. Эти возможности развертывания поддерживают инновации, необходимые для современного ЦОД

https://community.intel.com/t5/Blogs/Tech-Innovation/Data-Center/Intel-Details-IPU-and-New-Circuit-Innovation-at-ISSCC-2023/post/1453900?wapkw=IPU%20E2000

Повышение производительности с программируемой обработкой

Виртуальная машина Google Cloud C3 — первая виртуальная машина с пользовательскими процессорами Intel IPU и масштабируемыми процессорами Intel Xeon 4го поколения в закрытой предварительной версии.

В октябре 2022 г. компания Google Cloud объявила об успешном развертывании своей новой серии компьютеров C3, отмечая важную веху в создании комплексной программируемой платформы, которая использует преимущества аппаратного и программного обеспечения Intel. Машины серии C3 оснащены масштабируемыми процессорами Intel® Xeon® 4-го поколения, доступными для частного просмотра, и дебютируют с инфраструктурным процессором Intel® E2000, разработанным совместно Google и Intel.

Благодаря своему уникальному архитектурному подходу инстанты машин C3 обеспечивают значительный прирост производительности до 20% по сравнению с экземплярами C2 предыдущего поколения, что позволяет выполнять высокопроизводительные вычисления и рабочие нагрузки с интенсивным использованием данных. Машины Google Cloud C3 также прокладывают путь к будущему, когда блоки обработки инфраструктуры (IPU) интегрируются в центры обработки данных, ускоряя облачные инфраструктуры и повышая производительность. Виртуальные машины C3 будут выполнять рабочие нагрузки на процессорах Intel Xeon Scalable 4-го поколения, в то же время они безопасно освобождают программируемую обработку пакетов для IPU со скоростью передачи данных 200 гигабит в секунду (https://www.intel.com/content/www/us/en/newsroom/news/boosting—performance—programmable—processing.html?wapkw=IPU%20E2000).

IPU и DPU

IPU относится к классу карт DPU (data processing unit, блок обработки данных), представляющих собой программируемый контроллер канала с аппаратным ускорением обработки данных для дата-центрических вычислений. DPU обычно интегрирует в своем составе CPU, сетевую карту и программируемые механизмы ускорения данных. Это позволяет DPU иметь универсальность и программируемость центральных процессоров и в то же время специализацию на эффективной работе с сетевыми пакетами, запросами на хранение или аналитическими запросами (https://en.wikipedia.org/wiki/Data_processing_unit#cite_note17).

Механизмы ускорения данных DPU отличаются от CPU более высокой степенью параллелизма (необходимой для обработки многих запросов) и от GPU архитектурой MIMD, а не архитектурой SIMD (требуется, поскольку каждый запрос должен принимать разные решения и следовать по другому пути через чип). DPU могут реализовываться на основе ASIC, FPGA или SoC. DPU все чаще используются в центрах обработки данных и суперкомпьютерах с момента их появления в 2010-х годах из-за роста использования вычислений, ориентированных на данные, большие данные, безопасность и искусственный интеллект / машинное обучение / глубокое обучение. DPU разрабатываются как независимые конечные точки инфраструктуры. Среди вендоров DPU:

- AMD/Pensando: Capri, Elba & DSC;

- Broadcom: Stingray;

- Fungible: F & S Series;

- Intel: Infrastructure Processing Unit (IPU);

- Kalray: Kalray K200LP;

- Marvell Technology: OCTEON и ARMADA;

- Nvidia/Mellanox Technologies: Nvidia BlueField, ConnectX, Innova.

Среди программных вендоров, использующих DPU: Bloombase, Cloudflare, DDN, Fortinet, Palo Alto Networks, VAST Data, VMware, WekaIO.

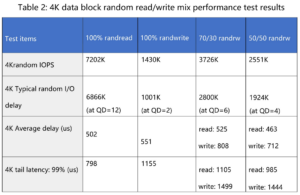

Варианты использования IPU в центрах обработки данных включают [8] (рис. 12):

- ускоренная работа в сети, которая переносит функциональность виртуального коммутатора на аппаратное обеспечение;

- ускоренное хранилище, которое перемещает стек хранилища с процессора хост-приложений на IPU;

- ускоренная безопасность, которая разгружает шифрование/дешифрование, сжатие и другие задачи безопасности, интенсивно использующие ЦП;

- инфраструктурная обработка, которая переносит функции управления службами гипервизора на IPU.

Рис. 12. Варианты использования IPU [8].

Источники, доп. ресурсы

[1] Lightbits To Demonstrate Application Acceleration And Improved Resource Utilization Using An Intel IPU And Disaggregated NVMe Storage At Intel Innovation. September 26, 2022 – https://www.lightbitslabs.com/press-releases/lightbits-to-demonstrate-application-acceleration-and-improved-resource-utilization-using-an-intel-ipu-and-disaggregated-nvme-storage-at-intel-innovation/.

[2] IPU Bare Metal Disaggregated Storage. 25 марта 2022 г. – https://www.youtube.com/watch?v=Be1HH6PwKoY.

[3] LightOS 2.2 Product Overview – https://www.lightbitslabs.com/wpcontent/uploads/2021/03/LightOS2.2ProductOverview.pdf.

[4] Supermicro Lightbits NVMe/TCP Storage for CSPs, Private, and Edge Clouds – https://www.supermicro.com/en/solutions/lightbits.

[5] CloudNative Storage for Kubernetes. Performance, Persistence, Simplicity. SOLUTION BRIEF – https://dev.lightbitslabs.com/wpcontent/uploads/2021/06/KubernetesSolutionBrief.pdf.

[6] Inspur Information, Intel, and Lightbits Labs jointly provide a dis tributed allflash storage solution based on NVMe/TCP – https://www.lightbitslabs.com/resources/inspur-information-intel-and-lightbits-labs-jointly-provide-a-distributed-all-flash-storage-solution-based-on-nvme-tcp/.

[7] Intel® Infrastructure Processing Unit (Intel® IPU) ASIC E2000 – https://www.intel.com/content/www/us/en/products/details/networkio/ipu/e2000asic.html.

[8] IPU Based Cloud Infrastructure White Paper – https://www.intel.com/content/www/us/en/products/docs/programmable/ipu-based-cloud-infrastructure-white-paper.html.

Авторы: Гантимуров А.П., Калашник А.Г.

Добавить комментарий

Комментариев пока нет