Боремся с дефицитом памяти GPU

Современные системы искусственного интеллекта всё чаще сталкиваются с критическим ограничением GPU-памяти: объём видеопамяти на ускорителях не успевает за ростом размеров и сложности нейронных моделей. В результате при обучении и инференсе крупномасштабных моделей нередко возникает «бутылочное горлышко», вынуждающее разработчиков расширять пул VRAM за счёт медленной внешней памяти или арендовать дорогостоящие облачные GPU-серверы. С целью преодоления этого барьера Phison и SanDisk предложили альтернативные подходы, позволяющие использовать блочную флеш-память NAND в роли расширения GPU-памяти – программно у Phison и аппаратно у SanDisk

Phison aiDAPTIV+: расширение виртуальной памяти программно

Решение aiDAPTIV+ от Phison представляет собой слой промежуточного программного обеспечения (middleware), которое устанавливается на GPU-сервере и создаёт единый виртуальный пул памяти, объединяющий VRAM графических процессоров (GDDR или HBM), системную DRAM и флеш-накопитель Phison AI100E (SLC, 1 бит на ячейку). При загрузке модели aiDAPTIV+ анализирует её потребности и делит данные на «горячие» (hot), «тёплые» (warm) и «холодные» (cool) фрагменты:

- Hot – размещаются непосредственно в видеопамяти GPU;

- Warm – уходят в оперативную память CPU;

- Cool – отправляются на SSD.

В ходе работы модели aiDAPTIV+ динамически перемещает фрагменты между уровнями памяти, сохраняя GPUs занятыми вычислениями и минимизируя дорогостоящие повторные вычисления токенов. По заявлению Phison, такой подход позволяет одной небольшой группе GPU с ограниченным объёмом VRAM (вплоть до штатных RTX 6000 Ada или платформ Jetson) эффективно обучать и инференсить модели до 70 млрд параметров, что ранее требовало либо более мощных GPU, либо переноса задач в облако

SanDisk High Bandwidth Flash (HBF): аппаратная эволюция VRAM

В противоположность софтверному решению Phison, SanDisk разрабатывает аппаратный аналог расширенной VRAM — High Bandwidth Flash (HBF).

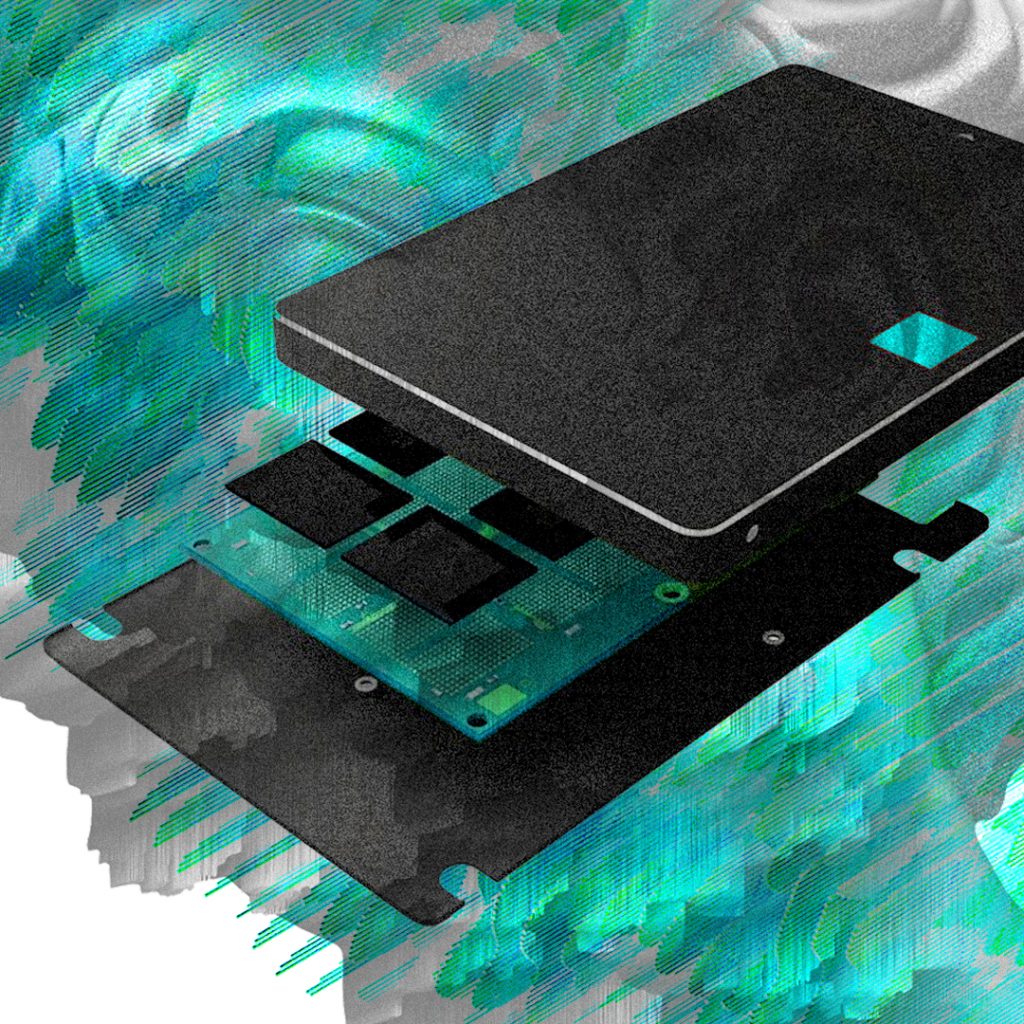

Технология повторяет архитектуру HBM: несколько слоёв NAND-кристаллов стекаются над логическим кристаллом, связаны через TSV (Through-Silicon Vias) и через интерпозер подключаются к GPU. Отличие в том, что HBF не заменяет HBM, а дополняет его: интерпозер GPU модифицируется для работы сразу с HBM-стеком и HBF-стеком, а в аппаратной памяти реализуется контроллер, управляющий перемещением данных между горячим HBM и дополнительным HBF

Для ускорения вывода на рынок HBF SanDisk сформировала Технический консультативный совет, в который вошли автор RISC-архитектуры профессор Дэвид Паттерсон и специалист по GPU-архитектурам Раджа Кодури. Их задача — разработать открытые стандарты и протоколы взаимодействия HBF с GPU, а также содействовать внедрению технологии у производителей ускорителей

Сравнительный анализ

- Скорость и задержки HBF благодаря близкому расположению к GPU и отсутствию промежуточного уровня CPU обеспечивает более низкие задержки и более высокую пропускную способность, сопоставимую с HBM или превышающую её. aiDAPTIV+ же зависит от SSD-уровня, что увеличивает задержки, но остаётся быстрее многократных обращений к удалённым хранилищам или повторных вычислений токенов

- Гибкость и масштабируемостьПрограммное решение Phison можно внедрить на существующих платформах, не требуя изменений в аппаратном дизайне GPU-серверов, — достаточно установки ПО и SSD. Это снижает барьер входа для средних организаций и edge-систем. HBF же требует совместной доработки интерпозера и аппаратного интерфейса у каждого производителя GPU

По мнению BAUM, дальнейшее развитие моделей и особенно внедрение агентного AI будет всё больше усугублять проблему memory wall. Для комплексного решения, уверены в BAUM, потребуется не просто расширять узкие места через программные прокладки или аппаратные “дополнения”, но и пересматривать архитектурные принципы хранения и передачи данных внутри серверов:

- Новые протоколы доступа к сетевым хранилищамНеобходимо думать про протоколы которые позволят иметь доступ к внешним пулам с уровнем задержек сопоставимым как минимум с локальными SLC накопителями

- Модульные хранилища ультравысокой производительностиЭти хранилища, обладая минимально необходимым набором функциональности для создания и управления пулами на больших масштабах должны обеспечивать уровень производительности хотябы в несколько десятков миллионов IOps

Такой подход, по убеждению BAUM, позволит не только снизить латентность и повысить гибкость развёртывания, но и облегчит масштабирование AI-кластеров в гетерогенных средах, где задачи могут перескакивать между локальными дата-центрами, edge-узлами и глобальной облачной сетью.

Андрей Гантимуров

andrey_gantimurov@baum.ru

Добавить комментарий

Комментариев пока нет