NVIDIA Inference Context Memory Platform (платформа контекстной памяти для инференса)

Архитектура и назначение платформы Context Memory Storage

NVIDIA Inference Context Memory Storage Platform – это новая архитектура хранения данных, специально разработанная для ускорения инференса крупных моделей за счет эффективной работы с контекстной памятью (inference context). Речь идет о данных типа Key-Value (KV) cache, которые хранят историю и состояние модели во время инференса (например, длинные контекстные окна в диалогах, последовательности запросов и промежуточные результаты работы агентных систем)[1][2]. Увеличение длины контекста (числа токенов) приводит к линейному росту требуемой памяти для KV-кэша, который легко достигает терабайтов и выходит за пределы объема памяти одного GPU[3][4]. Без специального решения приходится выбирать между размещением этих данных в дефицитной сверхбыстрой памяти GPU (HBM) либо на обычных хранилищах, не рассчитанных на эфемерные, временные данные – оба варианта влекут проблемы: либо ограничение контекста, либо рост латентности, нагрузки и затрат[5][6].

Назначение платформы – создать новый уровень памяти контекста, расширяющий эффективную память GPU на уровне всего кластера и снимающий «стену памяти» инференса. Эта платформа вводит дополнительный слой (context memory tier, условно называемый уровнем G3.5) между локальными ресурсами узла (HBM, DRAM, SSD) и традиционными сетевыми хранилищами[7][8]. В итоге контекст моделей рассматривается как первоклассный ресурс инфраструктуры, разделяемый между GPU узлов, а не как побочный продукт вычислений[9][10]. NVIDIA подчеркивает, что новая архитектура обеспечивает до 5-кратного увеличения пропускной способности (tokens per second) и в 5 раз лучшую энергоэффективность при длинном контексте по сравнению с традиционными хранилищами[11][12]. Это достигается тем, что “горячий” контекст больше не вытесняется на медленные хранилища, вызывая простои GPU, а обслуживается специальным высокоскоростным уровнем памяти контекста[13][14].

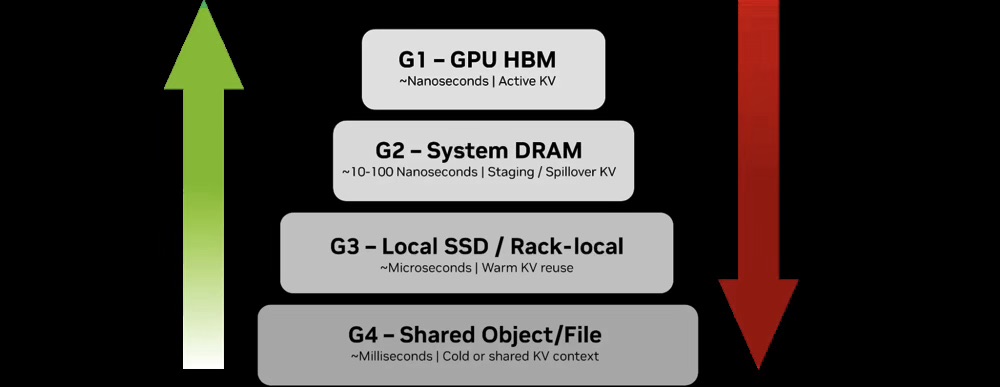

Многоуровневая память контекста. Платформа опирается на иерархию памяти из четырех основных уровней (G1–G4) для хранения KV-кэша, дополняемую новым промежуточным слоем G3.5[15][7]. Верхние уровни – это сверхбыстрая память GPU (G1: HBM, наносекундная задержка) для активного контекста, затем G2: DRAM узла (десятки наносекунд) для буферизации и спилл-овера из HBM. Ниже – G3: локальные SSD/NVMe на узле (микросекундные задержки) для «теплого» кэша, используемого в краткосрочной перспективе, и наконец G4: общие сетевые хранилища (миллисекундные задержки) для «холодных» данных – долговременной истории, логов и результатов, требующих сохранности[16][17]. Проблема в том, что по мере роста контекста емкости G1–G3 быстро не хватает, а перенос активного кэша на уровень G4 ведет к большим накладным расходам и задержкам[18][19]. Новый Context Memory слой (G3.5) встраивается между G3 и G4, заполняя этот разрыв – он обеспечивает кластерный (pod-level) уровень памяти контекста, достаточно емкий для многотеребайтных KV-кэшей, но гораздо быстрее традиционных сетевых хранилищ[7][8].

Рис. 1: Иерархия памяти для KV-кэша при инференсе (уровни G1–G4). Верхние уровни (HBM GPU, DRAM) обеспечивают наносекундный доступ для активного контекста, но ограничены по емкости. Нижние (локальные SSD, общие хранилища) дают больше места, но с возрастающей задержкой (микро- и миллисекунды) и сниженной энергоэффективностью[20][19].

Реализация платформы. Контекстная память G3.5 организована как совокупность Ethernet-подключенных flash-нод, управляемых специализированными DPU-процессорами NVIDIA BlueField-4[7][21]. Эти ноды называются Inference Context Memory Storage (ICMS) targets и по сути представляют собой высокопроизводительные flash-хранилища, встроенные в инфраструктуру AI-пода. Они работают в единой низко-латентной сети с GPU-узлами и предназначены исключительно для хранения и обслуживания KV-кэша (никаких иных данных там не хранится)[22][23]. Такой “контекстный буфер” на флэш-памяти, будучи достаточно близко к GPU по задержкам, позволяет предварительно подгружать (prestage) нужные блоки контекста обратно в GPU/DRAM (G1/G2) перед генерацией токенов, тем самым избегая пауз на декодере модели[24][13]. NVIDIA заявляет, что это надежное упреждающее подкачивание контекста снижает простои и увеличивает устойчивую скорость генерации токенов до 5× на длинных диалогах и агентных нагрузках[13]. Контекст при этом рассматривается как временный и реконструируемый (если потерян, его можно вычислить заново), поэтому платформе не нужны «тяжелые» службы хранения (репликация, сложные метаданные, резервирование) – за счет этого снижены накладные расходы, энергопотребление и задержки, присущие Enterprise-хранилищам[25][26].

В целом, Inference Context Memory Platform выполняет роль “довременной памяти” AI-агентов на уровне датацентра[27][28]. Она позволяет хранить и разделять большой объем инференс-контекста (историю диалогов, состояния агентов, результаты промежуточных шагов) между многими GPU и узлами, и многократно его переиспользовать, вместо того чтобы каждый раз пересчитывать с нуля или сбрасывать после одного запроса[1][29]. Таким образом достигаются более высокая сквозная производительность (больше токенов и запросов в секунду на каждый GPU) и энергоэффективность, особенно в сценариях длительных многоходовых взаимодействий и при масштабировании количества одновременных пользователей[30][31].

NIXL: библиотека высокоскоростной передачи контекста

Одной из ключевых технологий в составе платформы является NIXL (NVIDIA Inference Transfer Library) – библиотека, оптимизирующая передачу данных контекста между GPU, DPU и хранилищами. NIXL обеспечивает асинхронное, point-to-point взаимодействие в рамках инференс-фреймворков (например, NVIDIA Dynamo) и абстрагирует различные типы памяти и хранилищ через модульные плагины[32]. Проще говоря, NIXL скрывает от разработчиков различия между переносом данных из памяти CPU, памяти GPU или, например, чтением KV-блоков с NVMe-носителей – библиотека унифицировано и максимально эффективно перемещает нужные куски контекста туда, где они требуются в данный момент.

В составе Inference Context Memory Platform библиотека NIXL играет роль оркестратора движения KV-кэша по уровням памяти G1–G4. Инференс-фреймворки (такие как NVIDIA Dynamo) используют NIXL вместе со своими менеджерами кэша для решения, когда и что выгружать или загружать между HBM, DRAM и ICMS-хранилищем[33][34]. Например, при генерации ответа NIXL обеспечивает предварительную загрузку (pre-fill) нужных блоков KV из ICMS (уровень G3.5) обратно в GPU-память (HBM, G1) или память хоста (G2) перед фазой декодирования токенов[24]. После генерации новых токенов NIXL может выгружать менее актуальные данные обратно на флэш-слой. Все это делается прозрачно и в фоновом режиме, позволяя GPU избегать задержек ввода-вывода и сосредоточиться на вычислениях.

Важно, что NIXL поддерживает разнообразные бэкенды хранения через плагины – файловые системы, блочные устройства NVMe-oF, объектные хранилища и т.д.[32]. Это соответствует общей философии NVIDIA – не «привязывать» решение жестко к одному типу хранилища, а использовать стандартные транспорты (NVMe, NVMe-over-Fabrics, RDMA, включая NVMe KV-расширения под ключ-значение)[35][36]. Благодаря этому ICMS-платформа остается совместимой с обычной инфраструктурой хранения данных, но при этом достигает нужной производительности для KV-кэша. Практический пример – NIXL уже интегрирован в открытый стек LMCache, позволяющий вне NVIDIA-платформ организовать многоуровневый KV-кэш (CPU, SSD, S3-хранилища и пр.) в таких фреймворках как vLLM[37][38]. В случае же NVIDIA-стека, NIXL тесно взаимодействует с DPU BlueField-4 и ПО DOCA (о них ниже) для максимально эффективной передачи данных контекста в масштабе кластера[39][40].

Аппаратные компоненты: GPU, DPU BlueField-4, NVLink и NVSwitch, сеть Spectrum-X

GPU и память. Платформа контекстной памяти рассчитана на работу с новейшими GPU NVIDIA, входящими в Rubin platform (поколение после H100/Blackwell). Каждый такой GPU имеет огромный объем быстрой памяти (HBM4, до ~288 ГБ на GPU) и колоссальную пропускную способность ~22 ТБ/с[41]. Эта память служит уровнем G1 (горячий контекст), и за счет нового поколения NVLink она объединяется между GPU для меж-GPU обмена данными. Rubin GPU обладает до 3.6 ТБ/с пропускной способности NVLink на чип, а в составе серверов SuperPod GPU объединяются через коммутаторы NVSwitch, образуя единую высокоскоростную матрицу связей между десятками GPU[42][43]. NVLink/NVSwitch в контексте инференса важных для случаев, когда модель распределена по нескольким GPU или когда несколько GPU совместно обслуживают один большой запрос – они обеспечивают обмен активациями и частью контекста практически без участия PCIe, с минимальной задержкой. NVLink также используется для кэш-кооперации GPU с CPU: так, процессоры Grace/Vera соединяются с GPU через NVLink-C2C (Cache Coherent NVLink) с пропускной способностью ~1.8 ТБ/с, позволяя CPU с большой DDR-памятью выступать расширением памяти для GPU (уровень G2)[44][45]. В совокупности, связка “GPU + NVLink CPU + NVSwitch” обеспечивает внутри узла гибридную память (HBM + DDR) объемом вплоть до нескольких терабайт, с наносекундно-нс задержками доступа для GPU. Именно когда этот локальный ресурс исчерпан, система обращается к внешнему уровню G3.5 (ICMS).

BlueField-4 DPU (ICMS контроллер). Сердцем платформы контекстной памяти выступает NVIDIA BlueField-4 – программируемый DPU 4-го поколения, размещаемый как на вычислительных узлах Rubin, так и в стоечных флэш-энкложах ICMS[7][21]. BlueField-4 сочетает в одном чипе сетевой интерфейс 800 Гб/с Ethernet и 64-ядерный программируемый CPU-окомплекс (NVIDIA Grace архитектуры Arm) с собственной быстрой памятью (LPDDR)[46][47]. Ключевое достоинство BF4 – наличие аппаратных ускорителей ввода-вывода, специально полезных для задач KV-кэша: это engine, выполняющие крипто-шифрование и целостностный контроль (CRC) на линии 800 Гбит/с без нагрузки на CPU[46], а также механизмы ускорения RDMA и NVMe-oF. По сути, BlueField-4 разгружает хост-CPU от любых операций, связанных с передачей данных контекста: он самостоятельно завершают сессии NVMe-over-Fabrics, обработку NVMe-команд (в том числе KV-расширений), RDMA-трафика, выполняет проверку данных – “на лету” с минимальными задержками[48][49]. Благодаря этому NVMe SSD в ICMS-энкложах воспринимаются GPU-узлами почти как продление памяти, а не “медленное хранилище”: нет классической цепочки копирования данных через CPU (SSD -> контроллер -> по сети -> CPU DRAM -> GPU), вместо этого BlueField-4 напрямую двигает данные между флэш и GPU-нодами по RDMA, минуя узкое место x86 CPU[50][51]. Такой подход снимает конкуренцию за CPU-ресурсы (важно, когда десятки GPU одновременно запрашивают контекст) и устраняет избыточные копирования, радикально снижая суммарную задержку доставки данных[52][53].

В каждой стойке AI-пода NVIDIA предлагает размещать несколько ICMS-энкложей (например, 16 шасси на стойку), в каждом – по 4 контроллера BlueField-4. За каждым DPU может стоять порядка 150 ТБ NVMe-флэш емкости[54][22]. Таким образом, совокупно один под способен держать несколько петабайт контекстных данных (например, конфигурация Vera Rubin SuperPod: 1152 GPU Rubin и 64 DPU BF4 с ~9.6 ПБ флэш – что эквивалентно до 16 ТБ контекста на один GPU)[55]. Подчеркнем, что эти флэш-энкложи – не универсальные СХД, а специально сконструированные JBOF (Just a Bunch of Flash) для KV-кэша[56]. Они не выполняют типичные функции хранения (RAID, дедупликация, репликация и т.п.), а заточены на одну задачу – максимально быстро держать и выдавать несколько terabyte “горячих” ключ-значение блоков[23]. За надежность длительного хранения отвечает верхний уровень G4, а ICMS же рассматривается как кэш-память без долговременной устойчивости (stateless, ephemeral storage)[57][58]. Такая философия позволила NVIDIA исключить из тракта хранения лишние сервисы и добиться гораздо более высокой энергоэффективности: до 5× больше токенов на ватт, т.к. ни один ватт не тратится впустую на фоновые задачи хранения – все идёт на полезную работу GPU[26][30].

AI-сеть Spectrum-X. Для связи между GPU-узлами и ICMS-нодами используется высокопроизводительная фабрика NVIDIA Spectrum-X Ethernet с поддержкой RDMA/RoCEv2. Коммутаторы Spectrum-6 (серия Spectrum-X – совместная архитектура NVIDIA и Mellanox) обеспечивают суммарную пропускную способность до 102.4 Тбит/с и специальные алгоритмы для предсказуемо-низкой задержки на масштабах всего кластера[59][60]. Они реализуют congestion control, адаптивный роутинг и гарантированное отсутствие потерь (lossless), что минимизирует джиттер и tail latency (хвостовые задержки) даже под полной нагрузкой[61][62]. Важной особенностью Spectrum-X является аппаратная поддержка изоляции производительности – то есть несколько одновременных инференс-потоков (от разных приложений или арендаторов) могут сосуществовать без влияния друг на друга по трафику[62]. Это критично для multi-tenant сценариев, где один pod обслуживает разных клиентов: сеть гарантирует стабильную задержку и пропускную способность для всех. В результате, Ethernet-фабрика NVIDIA выступает как расширение памяти – GPU обращаются к удаленному контексту через RDMA почти так же, как к локальной памяти, и достигается близкая к линейной масштабируемость без традиционных “узких мест” NAS/серверов[63][64].

Программный стек и интеграция с NVIDIA AI Enterprise

Аппаратные решения требуют поддержки на уровне ПО. NVIDIA создала целостный программный стек для координации распределенной контекстной памяти и интеграции с существующими AI-фреймворками:

- NVIDIA Dynamo – компонент (возможно, часть NVIDIA AI Enterprise) для оркестрации инференса на уровне данных. Он отвечает за распределение и согласованность контекста между узлами: где хранится какой KV-блок, актуален ли он, сколько копий нужно и т.д.[65]. Dynamo вместе с NIXL реализует логику prefill/decode, поддерживая общий KV-кэш для множества GPU, и обеспечивает, чтобы при переносе задач между узлами сохранялась локальность контекста (т.е. агент “переезжает” вместе со своим состоянием)[66][40]. По сути, это распределенный менеджер KV-кэша (KV Cache Manager), взаимодействующий с оркестраторами (типа Kubernetes).

- NVIDIA Grove – так NVIDIA называет топология-ориентированный планировщик (вероятно, надстройка над Kubernetes), который размещает задачи инференса с учетом локализации их контекста[40]. Например, Grove постарается запустить повторный запрос того же диалога на том же сервере или стойке, где остался соответствующий KV-кэш, чтобы минимизировать сетевые обращения[40][67]. Это повышает cache-hit rate и сквозную производительность при масштабировании на десятки/сотни узлов.

- NVIDIA DOCA (Data-Center Offload and Control Architecture) – программный фреймворк для BlueField DPU. В контексте ICMS, NVIDIA добавила в DOCA специальный слой KV-communication/storage, то есть API и сервисы для работы с KV-кэшем как с отдельным типом данных[68]. DOCA предоставляет стандартизованные интерфейсы, через которые внешние системы хранения могут взаимодействовать с ICMS-слоем (например, управлять размещением данных уровня G3.5)[69]. BlueField-4, работающий под управлением DOCA, выполняет, грубо говоря, роль runtime для KV-кэша – он принимает команды от Dynamo/NIXL (через DOCA API) по тому, какие блоки кэша читать/писать на SSD, шифровать, передавать по сети и т.д., реализуя их максимально эффективно на аппаратном уровне[68][70]. DOCA при этом открыта для партнеров: NVIDIA заявляет поддержку open-интерфейсов, чтобы сторонние вендоры хранилищ могли подключать свои решения к новому tier контекста[69].

- NVIDIA AI Enterprise и NIM. Весь комплекс интегрируется в платформу AI Enterprise – коммерческую оболочку NVIDIA для развертывания AI на уровне предприятия. Отдельно упоминается компонент NIM (в материалах партнёров его расшифровывают как NVIDIA Inference Microservice или Manager) – набор микросервисов и API для разработчиков, упрощающий использование контекстной памяти[71][72]. По сути, NIM позволяет вызвать необходимые функции (например, сохранить или загрузить контекст с идентификатором сессии) через высокоуровневые сервисы, без необходимости вручную оперировать RDMA или NIXL. Таким образом, разработчики могут воспользоваться новым уровнем памяти в своих приложениях (чат-ботах, поисковых движках и пр.)

- LMCache, Triton и др.: Платформа не изолирована от остального экосистемы. Как уже отмечалось, существует открытый проект LMCache (Long Memory Cache) от университета Чикаго, нацеленный на универсальное решение KV-кэша для LLM и совместимый с разными железными платформами[37]. NVIDIA поддерживает интеграцию LMCache (в частности, Dell и некоторые другие партнеры используют связку LMCache+NIXL на существующих хранилищах, о чем ниже)[73][74]. Инференс-сервер Triton также будет способен работать с контекстной памятью – ожидается, что будущие версии Triton научатся взаимодействовать с Dynamo/NIXL для поддержки длинных контекстов. Уже сейчас такие оптимизации внедряются в open-source inference-движки: например, vLLM с PagedAttention у AMD оптимизирует размещение KV внутри памяти GPU[75], и при помощи LMCache может выгружать данные во внешнее хранилище на более стандартном оборудовании. Все это говорит о том, что программный стек вокруг KV-кэша активно формируется и расширяется, причем NVIDIA задает стандарт, но поддерживает и open-source решения для широкой экосистемы.

Итог: сочетание аппаратных и программных компонентов NVIDIA обеспечивает сквозную поддержку контекстной памяти – от уровня сетевого протокола (RDMA, NVMeoF), через DPU-ускорение, до уровня фреймворков инференса и приложений. Это превращает долгосрочный контекст инференса в управляемый ресурс, доступный “из коробки” для разработчиков AI-систем, без необходимости самим строить сложные пайплайны для сохранения/загрузки состояния моделей.

Интеграция со storage-решениями: VAST Data, WEKA, Hammerspace и др.

NVIDIA не планирует единолично производить все компоненты инфраструктуры – вместо этого объявлен широкий перечень партнеров по хранению данных, которые поддержат новую платформу. Во время анонса Jensen Huang демонстрировал слайд с логотипами многих поставщиков СХД: VAST Data, DDN, Dell, HPE, Hitachi Vantara, IBM, Nutanix, Pure Storage, Supermicro, WEKA и др. (NetApp и Lenovo также упомянуты как ожидающие поддержку ближе к запуску)[76][77]. В целом партнеры делятся на две категории: (1) те, кто интегрирует свое ПО непосредственно на уровне ICMS (уровень G3.5), то есть запускают свои сервисы внутри BlueField-4 контроллеров или оптимизируют их под KV-кэш; (2) те, кто обеспечивают связку с внешними уровнями хранения (G4), предоставляя долговременную сохранность или глобальную доступность данных контекста.

Ниже приведена таблица с примерами решений от разных вендоров и их ролью в контексте новой платформы:

| Вендор / решение | Подход к поддержке контекстной памяти | Особенности и интеграция |

|---|---|---|

| VAST Data (платформа AI OS, проект Ceres, VUA) | Плотно сотрудничает с NVIDIA для запуска своего ПО на DPU. Уже реализована поддержка BlueField-3 (контроллеры BF3 встроены в флэш-энкложи VAST Ceres), ожидается версия на BF4. Также VAST открыла собственный проект VAST Undivided Attention (VUA) – open-source реализация механизма KV-кэша на флеш-хранилищах[74][78]. | VAST фактически превращает свои флеш-массивы в расширение GPU-памяти. ПО VAST CNode может выполняться прямо на BlueField, обеспечивая локальный для GPU доступ к данным. В связке с ICMS это позволит масштабировать контекст до петабайт с минимальной задержкой. VUA дает сообществу открытый инструмент, совместимый с NVIDIA NIXL, для поддержки KV-кэш-оффлоада. |

| WEKA (Augmented Memory Grid) | Компания WEKA (известна своей файловой системой WekaFS для HPC) еще до появления BF4 предлагала решение расширения памяти GPU на базе NVMe. Augmented Memory Grid от WEKA – это ПО, позволяющее через GPUDirect Storage дать GPU прямой RDMA-доступ к NVMe-пулу, как к продолжению памяти[79][80]. | По сути, WEKA создала аналог G3.5 уровня своими силами: их решению уже используют ряд клиентов, позволяя хранить KV-кэш на SSD с доступом за микросекунды. Появление BlueField-4 стандартизирует такой подход и дает аппаратное ускорение. WEKA заявляет полную поддержку новой платформы: связка BlueField-4 + DOCA + NIXL будет задействована для оптимизации Augmented Memory Grid, снизив нагрузку на CPU и улучшив масштабируемость[81][82]. Иными словами, WEKA интегрирует свою систему в G3.5-tier, чтобы клиенты могли прозрачно использовать совместное решение NVIDIA+WEKA. |

| Hammerspace (Tier Zero) | Hammerspace известна ПО для глобальной распределенной файловой среды. Они продвигают концепцию Tier Zero – специального быстрого слоя данных для приложений. В контексте AI, Tier0 соответствует уровню G3 в терминологии NVIDIA (локальное NVMe), но Hammerspace считает, что с BlueField Inference Context Memory станет продолжением их подхода на новый уровень. | По заявлению Hammerspace, их платформа изначально “заточена под доставку нужных данных к нужному GPU в нужный момент” (цитата CMO)[83][84]. Сейчас компания активно работает с NVIDIA, планируя поддержку BlueField-4 и ICMS в своем продукте. Это позволит Hammerspace управлять KV-кэшом как частью глобального неймспейса: их ПО будет отслеживать, где в распределенной среде должен храниться контекст, перемещать его ближе к нужным GPU, и использовать возможности BF4 для быстрого доступа. Таким образом Tier Zero эволюционирует в полноценный G3.5 уровень для инференса, добавляя глобальную видимость данных. |

| IBM (Storage Scale) | IBM предлагает решение на базе IBM Storage Scale (бывший GPFS) – распределенной файловой системы с единым глобальным неймспейсом и учетом локализации данных. Вместе с NVIDIA они интегрируют Storage Scale с платформой контекстной памяти. | IBM Storage Scale берет на себя объединение уровней G3 и G4: KV-данные пишутся на локальные NVMe каждого узла, но тут же доступны через общий namespace другим узлам без явного копирования[85][86]. Это достигается механизмами репликации/шардинга FS. BlueField-4 подключается к Storage Scale и ускоряет доступ к этим данным по сети, минимизируя участие CPU[87][88]. В итоге разные экземпляры NVIDIA Dynamo на нескольких серверах могут обращаться к одним и тем же KV-записям, как если бы они были локальны[85]. IBM заявляет, что их решение прозрачно масштабируется от пары до тысяч узлов, включая гибридные облако/край сценарии – единый namespace упрощает работу с контекстом на разных площадках[89]. |

| Dell Technologies (PowerScale, ObjectScale, Lightning) | Dell – крупный игрок в хранилищах – тоже включился в гонку. Совместно с NVIDIA они анонсировали поддержку Context Memory Storage (CMS) в своих системах: PowerScale (NAS), ObjectScale (объектное хранение) и новый Lightning (параллельная файловая система для AI). | Dell изначально показала впечатляющие результаты по ускорению инференса на существующем железе: интегрировав LMCache + NIXL с RDMA в свои хранилища, они добились до 19× сокращения времени до первого токена (TTFT) и ~5.3× роста запросов в секунду на LLM, даже без BF4[90][91]. С выходом BlueField-4 Dell “довинчивает” решение: разрабатываются аппаратно-интегрированные системы, где BF4 используется для CMS-уровня в связке с флэш-массивами Dell[92][93]. В промежуточный период Dell продвигает гибрид: например, PowerScale может уже сейчас через NFS-over-RDMA служить быстрым хранилищем KV-кэша (NAS с низкой задержкой), ObjectScale – как S3-over-RDMA (объектное), а Lightning (пока в превью) – через NVMeoF прямо доставлять данные с дисков на GPU[94][95]. Эти варианты дают клиентам “вкус” преимущества длинного контекста уже сегодня, а в будущем могут сочетаться с BlueField для еще большей оптимизации. |

Как видно, практически все крупные вендоры хранения заявили поддержку концепции KV-cache offload. Hammerspace, VAST, WEKA – фокусируются на программном уровне и интеграции с DPU; Dell, IBM, Pure и другие – адаптируют свои системы под стандарты NVIDIA (NVMe KV, RDMA) и/или запускают ПО на BlueField. По сути, NVIDIA задает отраслевой стандарт для такого «уровня контекста», и экосистема стремится соответствовать ему[74][96]. При этом клиенты не привязаны к одному поставщику: платформа остаётся достаточно открытой (стандарты NVMe-oF, совместимость со сторонними Flash-энкложами), так что G3.5-слой можно реализовать разными продуктами. Это подтвердил и анонс: NVIDIA показала “референсный дизайн” ICMS-энкложей, но сами устройства поставляются партнерами на базе их проверенных технологий[97]. Для конечного пользователя это выражается в большем выборе: можно будет построить контекстный storage-tier на решении, лучшим образом подходящем под остальную инфраструктуру (будь то all-flash массивы VAST, ПО типа WekaFS или облачные хранилища, поддерживающие RDMA).

Реальные сценарии использования

- Инференс больших языковых моделей (LLM) с длинным контекстом. Главный драйвер разработки платформы – возросшая потребность в длительных диалогах и обработке огромных текстовых контекстов в LLM. Современные приложения выходят за рамки простого “вопрос-ответ”: появляются многоходовые агентные системы, где модель может вести диалог, вызывать инструменты, планировать цепочку действий и сохранять промежуточные результаты, иногда в течение минут или часов[98]. В таких условиях KV-кэш превращается в долговременную память модели, которую нельзя просто сбросить после каждого ответа[1][29]. Например, представим виртуального помощника, который запоминает предыдущие разговоры с пользователем: его контекстное окно может измеряться миллионами токенов, а состояние (KV) занимает сотни гигабайт. Явно держать столько в HBM невозможно – ранее система была вынуждена либо обрезать контекст (забывать историю), либо постоянно пересчитывать заново весь пройденный путь, тратя много времени и энергии. Inference Context Memory Platform устраняет эту проблему, позволяя прозрачно хранить расширенный контекст вне GPU, но с почти-GPU скоростью доступа. Это означает, что LLM может “помнить” большие истории, документы, результаты предыдущих запросов и использовать их мгновенно, без штрафа по latency. Практические выгоды: более длинные ответы без деградации скорости, способность модели давать персонализированные ответы, учитывающие долгосрочный контекст разговора, или анализировать большие документы (суммаризации, Q&A) полностью, держа их представление в KV-кэше. Всё это при минимальных паузах между токенами. Согласно тестам NVIDIA и партнеров, система с offload-кэшом способна увеличить throughput на пользователя в разы и снизить среднее время ответа даже при 10-100× увеличении длины контекста[30][99]. Также снижается энергопотребление на задачу – GPU не тратят циклы на повторные вычисления внимания, а работают «по делу»[30].

- Мульти-арендное (multi-tenant) обслуживание AI-сервисов. В больших облачных сервисах (например, AI-платформах вроде ChatGPT, корпоративных GPT-хабов и др.) один кластер обслуживает тысячи одновременных сессий и разных моделей. Это создает высокие нагрузки на подсистему памяти и ввода-вывода: если 1000 запросов одновременно пытаются сохранить или загрузить контекст, традиционная архитектура (CPU + SAN/NAS) “захлебывается” – возникают контеншен по CPU, очереди на дисках, рост tail latency[53]. NVIDIA ICMS адресует эту проблему: разгрузка операций на DPU и RDMA-сеть устраняет узкие места, и сотни GPU могут параллельно читать/писать контекст без заметного взаимного влияния[53][100]. Кроме того, общий контекстный слой позволяет шарить память между инстансами: напр. если разные пользователи обращаются к одной большой модели, их общие токены (начальная часть запроса, либо статическое знание модели) могут храниться единожды и переиспользоваться. Многопользовательский режим выигрывает также от снижения вариабельности задержек – как отмечено ранее, Spectrum-X сеть и аппаратные очереди BF4 гарантируют изоляцию, поэтому даже “шумные соседи” по storage-tier не увеличат задержку для критичных запросов[62]. В итоге платформа способствует более плотной консолидации нагрузки (больше агентов на один GPU одновременно), что важно для экономической эффективности (TCO) AI-сервиса[31]. В качестве кейса можно представить облачный API, где десятки моделей (разных размеров) обслуживаются на общем GPU-пуле: с контекстной платформой каждая модель быстро загружает свои KV-данные по требованию и выгружает обратно, не резервируя GPU-память постоянно. Это облегчает реализацию динамического пула моделей, переключающихся по нагрузке.

- Многомодальные и сложные пайплайны. Помимо чисто текстовых LLM, в современных приложениях появляются связки моделей – например, агент может использовать визуальную модель (анализ изображения) или делать промежуточные запросы к поисковому движку (retrieval). Платформа контекстной памяти полезна и здесь: она способна сохранять промежуточное состояние между этапами, доступное разным модулям. Например, результат распознавания изображения (векторные представления) можно хранить как часть контекста сессии, чтобы текстовая модель могла к ним обращаться при формировании ответа. Или в задачах Retrieval-Augmented Generation (RAG) – найденные факты/документы могут быть закэшированы на уровне KV, чтобы при генерировании ответа модель мгновенно их учитывала, не дожидаясь повторного чтения с диска. Inference Context Memory Platform поддерживает такие пайплайны, предоставляя общий низколатентный кэш для разных компонентов AI-системы. IBM, например, отмечает, что их решение с NVIDIA ускоряет multimodal и RAG-нагрузки в едином хранилище данных[101]. Это открывает дорогу более сложным агентам, которые могут взаимодействовать с разными источниками данных, сохраняя при этом все в общей памяти контекста.

- Пост-обучение и RLHF. Еще один потенциальный сценарий – пост-тренировочные этапы работы с моделями, такие как пост-обучение (post-training tuning) или reinforcement learning with human feedback (RLHF). На этих этапах часто требуется прогонять модель через очень длинные эпизоды взаимодействия (например, модель ведет диалог с симулированным пользователем или обходит большие объемы данных). Контекстная память также полезна: она позволяет хранить траектории взаимодействия, результаты на различных шагах и переиспользовать их при анализе или обновлении модели. Кроме того, при инференсе с дообучением (on-the-fly adaptation) можно хранить новые знания, полученные от пользователя, во временной памяти агента. Все это повышает гибкость модели в продакшене без полного переразвертывания.

В реальных внедрениях на 2025–2026 год ожидается, что сначала платформа будет использоваться в крупных датацентрах (так называемые “AI factories”), где развернуты большие языковые модели с поддержкой длительных сессий и множества агентов[102][103]. Именно там выигрыш 5× в throughput и энергопотреблении приносит максимальный эффект в пересчете на бюджет и качество сервиса. Постепенно, с появлением более доступных решений от партнеров, технология может найти применение и в меньших масштабах – например, в корпоративных AI-системах, где есть необходимость держать историю взаимодействия с пользователем (персональный помощник на сайте, анализ последовательности действий в документах и пр.).

Открытые вопросы и перспективы

Несмотря на явные преимущества, новая платформа поднимает ряд технических и стратегических вопросов для индустрии:

- Масштабируемость и архитектура развертывания. Как эффективно масштабировать ICMS за пределы одного pod (стойки или суперкомпьютера)? Сейчас объявлено, что платформа будет доступна во 2-й половине 2026 года, и референсные дизайны рассчитаны на SuperPod с ~1152 GPU и ~9.6 ПБ контекста[55]. Вопрос – как объединять несколько таких pod’ов, будет ли единое пространство контекста между датацентрами? IBM указывает, что их Storage Scale может растягивать namespace на облако и край[89], но сохранится ли при этом низкая задержка – открыто. Возможно, появятся многоуровневые иерархии (например, глобальный G4, локальный G3.5 в каждом регионе). Также, партнеры отмечают, что клиенты с гетерогенными средами (разные GPU или наличие AMD/Intel ускорителей) должны тщательно продумать свой выбор: NVIDIA ICMS прекрасно работает внутри NVIDIA-стека, но как быть, если в части задач используются другие платформы?[104][105] Может потребоваться поддерживать параллельно решения вроде LMCache, что добавляет сложности.

- Latency vs. консистентность данных. Платформа позиционируется как низко-латентная, но реальная задержка доступа к G3.5-tier все же выше, чем HBM. В критичных по задержке задачах (например, real-time приложения) может встать вопрос: допустима ли даже сотня микросекунд на доступ к контексту? NVIDIA заявляет <1 мс RDMA-доступ в среднем[106][107], и это весьма мало, но tail latency (например, в перегрузке сети) все равно может расти. Для минимизации нужны отлаженные механизмы кэширования и предвыборки: т.е. какие блоки KV держать в GPU/CPU памяти постоянно, а какие можно выгрузить. Эти алгоритмы пока закрыты (в недрах Dynamo), и будет важно, насколько они умны – ошибки могут приводить к внезапным задержкам (cache miss, требующий срочного чтения большого блока с флеша). Тут же вопрос консистентности: хотя KV-кэш объявлен stateless, на практике он представляет состояние сессий, и его целостность важна[108][109]. Оркестраторы должны следить за валидностью данных: например, если часть контекста изменилась (новый шаг в диалоге), старые копии должны инвалидироваться. Решается ли это средствами Dynamo/NIXL? Вероятно да, но подробности не раскрыты. Это направление для дальнейшей разработки – возможно, появятся протоколы когерентности для распределенного KV-кэша, аналогичные cache coherence в суперкомпьютерах, но работающие по RDMA.

- Стоимость и экономическая эффективность. Внедрение дополнительного аппаратного уровня влечет расходы: DPU BlueField-4, высокоскоростные SSD, новые сетевые коммутаторы. Плюс, увеличение общей сложности системы (требуется место в стойках, питание, администрирование нового слоя). Хотя NVIDIA утверждает, что выгоды перевешивают – за счет экономии мощности GPU и возможности не покупать лишние GPU только ради памяти[99][110], – но тщательный анализ TCO предстоит. У AMD, к слову, стратегия иная: их новый MI300X просто имеет 192 ГБ HBM3 на борту, что в ряде случаев позволит обойтись без offload’а, правда ценой гораздо более дорогого ускорителя[111][112]. AMD как бы говорит: “у нас и так память больше, поместите весь контекст туда”. Однако этот путь не масштабируется за пределы одного GPU и не решает шаринг между узлами[113][114]. NVIDIA делает ставку на дешевую Flash vs дорогая HBM. Что выгоднее – будет зависеть от конкретных рабочих нагрузок. Вполне вероятно появление гибридных метрик экономичности, напр. “стоимость за токен/сек” или “токенов на ватт”[115][30], которые покажут, оправдан ли новый слой. Если да, то даже дополнительные вложения окупятся улучшением throughput.

- Поддержка разных форматов моделей и новых алгоритмов. Пока концепция явно заточена под трансформеры и их KV-кэши. Вопрос – применима ли она к другим типам моделей? Например, вспоминаемые нейронные сети (RNN) или совсем иные подходы к длительной памяти (некоторые исследуют внешние дифференцируемые памяти, базы знаний и т.п.). Вероятно, архитектура гибкая: раз она оперирует абстрактными блоками “ключ-значение”, то не привязана строго к Transformers. Однако эффективность для других подходов надо изучать. Кроме того, форматы самих данных могут меняться: сейчас KV – это тензоры с определенной структурой (головы внимания, и пр.), а в будущем модели могут хранить и другие виды состояния. Платформа должна адаптироваться – возможно, появятся расширения NVMe KV под другие типы записей или DOCA будет доработана. Стратегически открытым остается и вопрос стандартов: закрепится ли NVMe Key-Value как основной интерфейс для таких задач или возникнут новые спецификации? NVIDIA выбрала NVMe KV, чтобы быть совместимой с существующим (пусть и малораспространенным) стандартом[116]. Если этот стандарт получит распространение (его уже поддерживает, например, RocksDB и некоторые KV-SSD), то экосистема может получить импульс к развитию вне зависимости от NVIDIA. Если же нет, может потребоваться участие открытых организаций (например, OpenCompute) для выработки cross-vendor стандарта “Memory Tier for AI”.

- Доступность и экосистема. Платформа объявлена, но пока находится на этапе внедрения. NVIDIA говорит о доступности в 2026 году, и поддержка партнеров выглядит широкої[76]. Однако реальных внедрений еще не было публично продемонстрировано (по крайней мере, в общем доступе нет кейсов на начало 2026 г.). Первые проекты, скорее всего, будут пилотными в сотрудничестве с крупнейшими облачными провайдерами (неоклауды, крупные корпорации)[117][118]. Вопрос – насколько гладко пройдет интеграция: будут ли, например, популярные фреймворки (PyTorch, JAX) поддерживать прозрачно выгрузку KV, появятся ли инструменты мониторинга и отладки для этого уровня (отметим, что в NIXL уже заложены telemetry hooks[119]). Также посмотрим, как ответят конкуренты: AMD и Intel пока не имеют прямого аналога, но могут усилить другие аспекты (больше HBM, быстрее interconnect). Для пользователей же ближайшая перспектива – внимательно оценить свои нагрузки: если вы планируете внедрять большие LLM с многомиллионным контекстом, стоит закладывать в архитектуру подобный контекстный уровень. NVIDIA уже “узаконила” его появление в AI-инфраструктуре[120][121], и индустрия, вероятно, последует в этом направлении, делая долгосрочную память неотъемлемой частью масштабируемого инференса.

Вывод: NVIDIA Inference Context Memory Platform представляет собой важный шаг в развитии инфраструктуры для ИИ. Она нацелена на решение конкретного узкого места – ограниченности памяти для длительного контекста – и делает это посредством инновационной интеграции GPU, сетей и хранения. Первые оценки обещают значительный прирост производительности и эффективности для долгих диалогов и agentic AI. В то же время, перед внедрением такого решения стоит учитывать архитектурные изменения и зрелость экосистемы. По мере того как технологии вокруг длинного контекста (LMCache, новые GPU с большей памятью, ПО для управления памятью) будут развиваться, можно ожидать появление все более унифицированных и оптимальных решений. На данный момент NVIDIA фактически задает тренд: контекст инференса стал такой же важной частью системы, как и сами модели, и он требует собственного масштабируемого “хранилища памяти”. Платформа Context Memory Storage – первая реализация этой идеи на уровне датацентра, и, судя по поддержке индустрии, за ней следует новая эра архитектур AI, где вычисления и данные неразрывно слиты воедино для достижения максимальной производительности[122][121].

[1] [5] [6] [11] [13] [14] [16] [17] [18] [19] [20] [24] [25] [26] [27] [28] [30] [31] [33] [35] [39] [40] [46] [48] [61] [62] [66] [67] [68] [69] [102] [103] [115] Introducing NVIDIA BlueField-4-Powered Inference Context Memory Storage Platform for the Next Frontier of AI | NVIDIA Technical Blog

[2] [3] [4] [9] [29] [41] [44] [45] [63] [64] [71] [72] [106] [107] NVIDIA Unveils the Inference Context Memory Storage Platform — A New Era for Long-Context AI — BuySellRam

https://www.buysellram.com/blog/nvidia-unveils-the-inference-context-memory-storage-platform/

[7] [12] [15] [21] [37] [38] [47] [49] [50] [51] [52] [53] [59] [60] [65] [70] [74] [75] [76] [77] [96] [100] [104] [105] [108] [109] [111] [112] [113] [114] [117] [118] [120] Research Note: Improving Inference with NVIDIA’s Inference Context Memory Storage Platform — NAND Research

[8] [22] [23] [34] [36] [54] [55] [56] [78] [83] [84] [97] [116] Nvidia’s basic context memory extension infrastructure

https://blocksandfiles.com/2026/01/12/nvidias-basic-context-memory-extension-infrastructure/

[10] [79] [80] [81] [82] [98] [121] [122] The Context Era: AI Inference & Augmented Memory Grid — WEKA

https://www.weka.io/blog/ai-ml/the-context-era-has-begun/

[32] [119] GitHub — ai-dynamo/nixl: NVIDIA Inference Xfer Library (NIXL)

https://github.com/ai-dynamo/nixl

[42] [43] Inside the NVIDIA Rubin Platform: Six New Chips, One AI Supercomputer | NVIDIA Technical Blog

[57] [58] [85] [86] [87] [88] [89] [101] Accelerating NVIDIA Dynamo with IBM Storage Scale and NVIDIA BlueField‑4‑Powered Inference Context Memory Storage Platform

[73] [90] [91] [92] [93] [94] [95] [99] [110] Dell and NVIDIA Expand the Horizons of AI Inference | Dell

https://www.dell.com/en-us/blog/dell-and-nvidia-expand-the-horizons-of-ai-inference/

Добавить комментарий

Комментариев пока нет