Введение

В исследовании Gartner Magic Quadrant for Distributed File Systems and Object Storage (Published 19 October 2022) [1] VAST Data позиционируется в качестве претендента в этом магическом квадранте, занимая 6-е место по присутствию на рынке (рис. 1). VAST Data Universal Storage или определяется как “унифицированная распределенная файловая система и устройство хранения объектов, предназначенное для крупномасштабных многопротокольных развертываний центров обработки данных. VAST Data лучше всего подходит для ИИ/машинного обучения (МО), финансовой аналитики, медико-биологических наук и других крупномасштабных рабочих нагрузок, чувствительных к производительности.” Сама VAST Data позиционирует свое решение еще и как альтернативу параллельным файловым системам в гибридных инфраструктурах, где, помимо традиционных НРС-нагрузок, требуется поддержка и НРС-AI-нагрузок, а также в качестве замены Hadoop-развертываниям. Т.е. VAST Data Universal Storage – универсальное многопротокольное масштабируемое хранилище для современной цифровой трансформации и поддержки сложных гибридных нагрузок – HPC/HPCAI/ML/DL/HPDA.

Цифровая трансформация приводит к быстрому распространению вариантов использования, основанных на рабочих нагрузках, требующих высокой производительности. Эти рабочие нагрузки, которые когда-то были эксклюзивными для академических кругов и государственных учреждений, теперь становятся массовыми благодаря острой необходимости получать информацию из ускоренного анализа разнообразных наборов данных [2].

Недавний опрос IDC показал, что более половины организаций указывают темпы роста данных с 20% до 50% в 2022 году, а треть ожидают, что они достигнут 99%. 80% этих данных будут неструктурированными по своей природе, с упором на итеративную аналитику, позволяющую получать отдачу от времени. Рабочие нагрузки, обеспечивающие такую информацию, использую лгоритмические подходы и рабочие процессы, такие как моделирование и симуляция (так же известные как высокопроизводительные вычисления [HPC]), обучение и логические выводы (используемые в искусственном интеллекте [AI] и машинном обучении [ML]) и (высокопроизводительный) анализ данных. Традиционные подходы к вычислениям и хранению, основанные на инфраструктурной архитектуре общего назначения, не соответствуют требованиям таких подходов к производительности и масштабируемости.

Рис. 1. Gartner Magic Quadrant for Distributed File Systems and Object Storage

(Published 19 October 2022 – ID G00760026).

Инвестиции в такие рабочие нагрузки требуют сопутствующих расходов на специально созданную вычислительную инфраструктуру, хранилище и сетевую инфраструктуру, в которой может размещаться одна или несколько таких ориентированных на производительность сред.

Этот стек инфраструктуры по своей сути сложен и тесно связан со многими тесно взаимосвязанными частями, которые нелегко отделить друг от друга. С конвергенцией этих рабочих процессов и подходов растет потребность в том, чтобы инфраструктура хранения поддерживала расходящиеся шаблоны ввода-вывода традиционного моделирования и симуляции HPC-вычислений (маленькие данные на входе/большие данные на выходе) и новых шаблонов обучения и логических выводов AI/ML (большие данные на входе/маленькие данные на выходе) одновременно. Исторически сложилось так, что они различались, что приводило к раздвоению инфраструктуры хранения. Это привело к увеличению затрат и противоречит экономике цифровой трансформации.

VAST Data предлагает уникальную архитектуру, отвечающую этим требованиям как для предприятий, так и для институциональных клиентов, стремящихся развернуть конвергентную среду для традиционных HPC и новых AI/ML рабочих нагрузок. Это решение, использующее высокопроизводительную сетевую файловую систему (NFS) для доступа к данным, приводит к повышению гибкости, производительности и масштабируемости среды конвергентной инфраструктуры HPC-AI. Это также значительно упрощает управление средой благодаря службам данных корпоративного уровня, которые также разработаны с учетом потребностей институциональных пользователей.

Конвергенция НРС и AI нагрузок

История параллельных файловых систем

В начале развития решений для моделирования и симуляции (то, что называется традиционными средами HPC) сообщество HPC полностью поддерживало сетевую файловую систему в качестве протокола доступа для обмена данными между кластерами высоко производительных вычислений. NFS приобрела популярность благодаря своей широкой адаптивности, универсальности и простоте использования. Будучи испытанным протоколом на основе IP, NFS представляет собой экономичное решение для обмена файлами по сети между несколькими разнородными вычислительными узлами. NFS еще больше упростила управление файлами, устранила бункеры хранения, сократила передачу файлов между узлами и предоставила возможности прозрачного многоуровневого хранения файлов.

Несмотря на эти преимущества, NFS представляла собой неотъемлемые проблемы масштабирования в средах параллельных вычислений, где производительность важнее всего остального. Они были решены с помощью сетей с высокой пропускной способностью, малой задержкой и обновленных версий протокола, но основные проблемы масштабирования на уровне протокола остались. Например, если несколько клиентов записывают в кэшированную копию одного и того же файла в сети и выдают команду close, протокол не может гарантировать, какие биты станут достоверной версией данных, что приведет к несогласованности данных. Именно традиционные реализации систем на основе NFS создали проблемы масштабирования.

Поскольку традиционные реализации систем на основе NFS никогда не предназначались для атомарного параллельного ввода-вывода, многие практики в сообществе HPC перешли на другие параллельные (распределенные) файловые системы, такие как Lustre, которые были специально разработаны для параллельных кластерных вычислительных сред. Параллельные файловые системы имеют свой собственный драйвер, который необходимо поддерживать в соответствии с версиями программного обеспечения, работающими на стороне сервера, которые используются отдельно от драйвера NFS. В этих средах используется клиентский модуль для файловой системы, установленный на каждом из вычислительных узлов, который дополняет стандартный драйвер NFS для доступа к общим данным.

По сей день большинство HPC-сред (особенно это относится к исследовательским институтам) полагаются на параллельные файловые системы. IDC считает [2], что для организаций, которые развертывают эти параллельные файловые системы, день или несколько дней простоя кластера считаются приемлемым риском, а корпоративные функции считаются менее актуальными.

Например, на самом высоком уровне самых быстрых суперкомпьютеров мира Lustre по-прежнему широко используется с долей 40% (последний список SC22 IO500 [https://io500.org/] говорит об обратном – на первом месте среди первых 28 самых высокопроизводительных компьютеров – DAOS с долей 46%, а Lustre занимает всего 7%, прим. ред.), за ней следуют другие коммерческие файловые системы и файловые системы с открытым исходным кодом. Frontier, первый в мире экзафлопсный суперкомпьютер, развернутый в Национальной лаборатории Ок-Риджа (ORNL) Министерства энергетики США, использует трехуровневую файловую систему Lustre с 679 ПБ (на диске) со скоростью чтения 5,5 Тбайт/с, пиковой скоростью записи 4,6 Тбайт/с, случайным чтением 2 млн IOPS; устройства NVMe на основе флэш-памяти для 11,4 ПБ при пиковой скорости чтения/записи 10 ТБ/с, 2 миллиона операций ввода-вывода в секунду при произвольном чтении; и емкость метаданных на основе флэш-памяти 10 ПБ.

Проблемы параллельных файловых систем

Параллельные файловые системы обычно расширяют семантику кэширования POSIX, которая определена только для одного хоста (где их гораздо проще реализовать эффективно), на кластер хостов (где соответствующие усилия по синхронизации обычно замедляют работу до такой степени, что например, запись в общий файл становится невозможной, и необходимо добавить дополнительные промежуточные уровни). Опубликованные общедоступные исследования показывают, что параллельные файловые системы, например те, которые поддерживают пакетные буферы, часто плохо работают с рабочими нагрузками произвольного доступа с большим количеством операций чтения.

POSIX (Portable Operating System Interface — переносимый интерфейс операционных систем) — набор стандартов, описывающих интерфейсы между операционной системой и прикладной программой (системный API), библиотеку языка C и набор приложений и их интерфейсов. Стандарт создан для обеспечения совместимости различных UNIX подобных операционных систем и переносимости прикладных программ на уровне исходного кода, но может быть использован и для не-Unix систем, https://ru.wikipedia.org/wiki/POSIX.

Кроме того, сам переход к параллельным файловым системам создает более сложные операционные проблемы в этих средах высокопроизводительных вычислений:

- квалифицированный персонал. С переходом на параллельные файловые системы стало обязательным наличие высококвалифицированных системных администраторов высокопроизводительных вычислений для управления и оптимизации установки. Даже сегодня эти навыки по-прежнему испытывают острую нехватку на рабочем месте, поскольку крупные поставщики услуг осознают таланты таких администраторов систем хранения и нанимают их, что вызывает циклическую потребность в обучении и циклическом переключении талантов;

- контроль версий. Параллельные файловые системы должны поддерживать определенную согласованность с версиями ядра и ОС, чтобы иметь совместимые версии на клиентах и серверах. Поскольку параллельные файловые системы не используют стандартный протокол, их проприетарная версия может меняться при каждом обновлении;

- развертывание. Параллельные файловые системы требуют тщательного планирования на этапе внедрения. Многие из параметров настройки приводят к компромиссу между задержкой и пропускной способностью, что не может быть решено с учетом архитектуры систем (например, установка максимальных пределов инодов по умолчанию, управление метаданными, параметры настройки для известных шаблонов чередования ввода-вывода для приложений, включение высокой доступности и т.д.), настройка параметров отказоустойчивости);

- управление изменениями. Изменения конфигурации в автономном и онлайн-режиме часто могут нарушить хрупкий баланс для оптимизации производительности. Любые изменения конфигурации серверов, томов и целей или изменение маркировки имен устройств во время конфигурации с несколькими путями за пределами интегрированного диспетчера программного обеспечения повышают риск нарушения функций высокой доступности, управления файловой системой и мониторинга. Кроме того, многие обновления и расширения системы требуют простоя, поскольку их нельзя выполнять, пока среда работает;

- сложность сети. В гетерогенной сетевой среде, использующей смешанные поколения сетей InfiniBand и Ethernet, необходимо интегрировать шлюзы и маршрутизаторы, что еще больше вводит управление конфигурацией и увеличивает накладные расходы на управление.

Операционные накладные расходы, в свою очередь, приводят к более высоким затратам. Если учесть общую стоимость внедрения, это может иметь существенное значение.

Тенденции развития файловых систем в HPC- и AI-средах

С конвергенцией сценариев использования HPC и AI общий характер рабочих нагрузок меняется. Негативное наследие, связанное с использованием NFS в качестве основного протокола доступа, может быть уменьшено с помощью правильной масштабируемой архитектуры для базовой файловой системы и протокола. Это, прежде всего, требует реализации параллелизма в самом хранилище, а не на уровне протокола, что приводит к значительному улучшению характеристик производительности и масштабирования.

В традиционных HPC-средах NFS-хранилище часто используется для доступа к хранилищу в гетерогенной и гибридной инфраструктуре. Исследование IDC показывает, что в большинстве HPC-сред используется до трех уровней хранения (первичный, вторичный и третичный), причем NFS часто используется в качестве вторичного или третичного уровня. Это уровневость приводит к более высоким технической и управленческой сложностям хранилищ данных, фрагментации данных и ненужных миграций данных.

Быстрый рост экосистемы с открытым исходным кодом во главе с Linux привел к быстрому развитию индустрии сетевых хранилищ (NAS), росту сетей TCP/IP с высокой пропускной способностью и малой задержкой, а также приложений, сертифицированных для работы с общими сетевыми файловыми системами. Основными бенефициарами зрелости NFS были предприятия. Рост неструктурированных и полуструктурированных данных привел к тому, что NFS получила широкое распространение в организациях в большинстве отраслей.

Рост рабочих нагрузок AI/ML на предприятии способствует дальнейшему внедрению NFS. Опрос за последний год показал, что там, где внедряют рабочие нагрузки AI/ML, большинство предприятий имеют тот или иной тип масштабируемой файловой системы с общим сетевым доступом, обычно через NFS. Для большинства рабочих нагрузок со скромными требованиями к вводу-выводу NFS работает хорошо, хотя, как только она начинает масштабироваться, могут возникнуть проблемы. Общие требования, выявляющие эти проблемы с производительностью, включают потребность в чрезвычайно высокой производительности последовательного чтения/ записи в один большой файл и возможность масштабирования до необходимых уровней параллелизма по мере добавления дополни тельных клиентов и приложений, обращающихся к данным.

Конвергентная инфраструктура для HPC-AI усиливает потребность в NFS

Различные подходы определяли развертывание корпоративных ИТ и традиционных HPC-сред в течение нескольких десятилетий; на предприятии это традиционная трехуровневая архитектура, тогда как в HPC-сообществе это программно-определяемая, массово масштабируемая или параллельная архитектура. Конвергенция вариантов использования HPC, AI/ML и высокопроизводительного анализа данных (HPDA, high-performance data analytics) означает, что большинство предприятий и учреждений стремятся использовать общую инфраструктурную архитектуру для всех нагрузок, которая вбирает в себя лучшее из обоих миров.

NAS-системы предназначены для масштабирования с использованием базовых файловых систем, обширного пространства имен и возможностей масштабирования, основанных на сетях с высокой пропускной способностью и малой задержкой. При правильной параллельной архитектуре такие системы могут масштабироваться до сотен петабайт.

IDC считает, что сочетание преимуществ NFS, флеш-накопителей и параллельной горизонтально масштабируемой архитектуры на стороне сервера обеспечивает максимальные преимущества для сред HPC-AI. Такая система обеспечивает общий уровень инфраструктуры для традиционных высокопроизводительных вычислений, а также конвергентных рабочих нагрузок HPC-AI. Это значительно снижает сложность развертывания и административную нагрузку.

По мере того, как HPC-вычисления становятся массовым явлением и объединяются с AI/ML, аналитикой данных и инженерными задачами, HPC-вычисления становятся востребованными во всех организациях, проходящих цифровую трансформацию и стремящихся обеспечить оптимальную производительность и эффективность своей инфраструктуры в локальной среде, в облаке и на периферии. В качестве подтверждения были представлены результаты исследования IDC Worldwide HPC 2022. В ответах респонденты указали, что в 2022 году большинство организаций в Северной Америке (США), Азии (Китай и Япония) и Европе (Франция, Германия и Великобритания) будут тратить треть своего HPC-AI бюджета на высокопроизводительное хранилище.

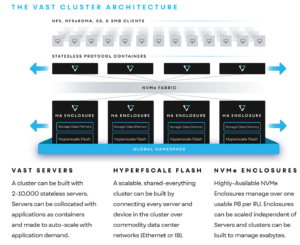

Архитектура VAST Data Universal Storage

Архитектура хранилища VAST Data Universal Storage определяется как Dis-Aggregated, Shared Everything (DASE) состоит из трех уровней: интерфейсных узлов (CNode), сетевой NVMe-фабрики (IB или Ethernet, связывает CNode и полки хранения) и полок хранения, включающих как NVMe Persistent Memory, так и NAND-флэш SSD. VAST Data развивает масштабируемую систему хранения данных Universal Storage на стандартном серверном оборудовании для хранения данных x86 в сочетании с программно-определяемой платформой контроллера хранилища (рис. 1а).

Рис. 1а. Архитектура VAST Data Universal Storage.

VAST Data Universal Storage снижает стоимость и сложность файлов и объектов на флэш-дисках, создавая платформу данных для всех рабочих нагрузок. Созданная для использования всех преимуществ NVMeoF, Storage Class Memory и плотной гипермасштабируемой флэш-памяти (QLC) VAST обеспечивает эффективность, которая невозможна с устаревшей архитектурой:

- локально декодируемые коды стирания обеспечивают защиту данных N+4 с затратами всего 2,7%;

- сокращение объема данных по сходству (similarity) дает большее сокращение, чем в любой другой метод;

- глобальная трансляция флэш-памяти с использованием буфера записи Storage Class Memory продлевает срок службы сверхмасштабируемой флэш-памяти до десяти лет.

Результатом стала файловая и объектная система, обеспечивающая производительность all-flash для самых ресурсоемких рабочих нагрузок больших данных, масштабируемость от петабайтов до эксабайтов и экономичность, которая делает ее доступной для любой корпоративной рабочей нагрузки.

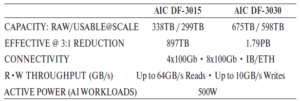

Базовые компоненты комплектации платформы VAST Data Universal Storage с диапазонами масштабирования представлены на рис. 1б [4].

Рис. 1б. Базовые компоненты комплектации VAST Data Universal Storage.

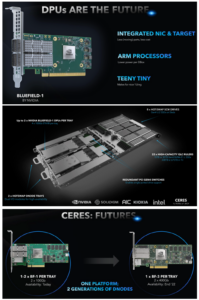

В марте 2022 г. компания VAST Data представила последнюю разработку – VAST AIC DF3015/3030 — в корпусе Ceres 1RU с флэш-модулями QLC нового форм-фактора линейки (ruler) [6] (рис. 1б).

Блок Ceres содержит до 338 ТБ или 675 ТБ необработанной емкости (299 ТБ или 598 ТБ для использования) флэш-памяти QLC в форм-факторе линейки (с использованием 22 линеек по 15 ТБ или 30 ТБ) и 6,4 ТБ NVMe в корпусах с 8 модулями энергонезависимой памяти NVMe (Intel Optane). Основные характеристики блока Ceres:

Новый блок хранения данных Ceres увеличивает пропускную способность до 64 ГБ/с по сравнению с узлами хранения 2RU Lightspeeds, которые достигают 40 ГБ/с. Ключевым нововведением блока Ceres использование DPU NVIDIA BlueField-1.

Среди преимуществ блока Ceres:

- более простое обслуживание;

- повышенная модульность, что позволяет создавать меньшие и более экономичные кластеры VAST;

- более высокая плотность: до 675 ТБ флэш-памяти в 1RU;

- основа для перехода на новые версии PCIe.

Архитектура VAST DASE позволяет легко интегрировать новые узлы, такие как Ceres, в существующие развертывания VAST. СХД Ceres можно комбинировать с любыми другими корпусами Lightspeed для создания унифицированного пула хранения VAST. Любые новые модели, которые будут выпущены в будущем, могут быть аналогичным образом добавлены в существующие кластеры VAST. Эта прямая совместимость обеспечивает простоту обновлений и расширений без необходимости замены ранее приобретенных узлов.

Рис. 1в. Блок хранения серии CERES – VAST DATA AIC DF3015/3030.

В настоящее время системы VAST развернуты во многих центрах обработки данных из списка 500 крупнейших. Архитектура VAST Disaggregated Shared Everything (DASE) предназначена для масштабирования в соответствии с самыми высокими требованиями к инфраструктуре эпохи HPC-AI (до более чем 10 000 серверов хранения и 1000 корпусов NVMe с общей масштабируемостью до 1,5 EB, пропускной способностью до 100 ТБ/с и с более чем 500 млн. IOPS).

Архитектура VAST DASE использует программный стек, который применяет глобальные алгоритмы для максимальной производительности и масштабирования. Состояние и объем хранилища системы строятся из корпусов хранения NVMe-oF высокой плотности, а логика системы реализуется контейнерами Docker без сохранения состояния, которые подключают все носители и управляют ими. Поскольку вычислительные элементы отделены от носителя по всей фабрике центра обработки данных, каждый из них может масштабироваться независимо, разделяя емкость и производительность и позволяя масштабировать их независимо друг от друга. Благодаря устранению необходимости во внутрикластерной координации и масштабированию в сетях с высокой пропускной способностью файловые службы NFS могут масштабироваться до экзафлопсных масштабов в распределен ной сети с подключенными массивами хранения. Согласно VAST, DASE — это первая новая архитектура данных с момента введения концепции «общего ничего» (shared nothing) в 2003 году.

Комплексный программный стек VAST Cluster поддерживает NFS, NFSv4 с аутентификацией Kerberos, NFS поверх RDMA, SMB и Docker CSI и S3 методы доступа, а также использует новые технологии хранения, такие как память класса хранилища, NVMe over Fabrics и четырехуровневую ячейку высокой плотности, (QLC, quad-level cell) на основе твердотельных дисков (SSD). Все клиенты VAST Data используют ее в качестве масштабируемой файловой системы, но более 40% также используют ее для S3 доступа.

VAST Data поддерживает различные функции управления хранилищем корпоративного класса, которые обеспечивают высокую доступность, плотную многопользовательскую консолидацию рабочих нагрузок и чрезвычайно эффективное использование вычислительных ресурсов и емкости хранилища. Поставщик предоставляет унифицированную платформу данных корпоративного класса, которая обеспечивает плотную консолидацию широкого спектра рабочих нагрузок без риска для производительности и/или доступности, выходные конструкции для хранения. Для служб данных система поддерживает пространство имен эксабайтного масштаба, неизменность моментальных снимков и объектов, распределенную блокировку файлов, интеграцию LDAP и Active Directory, глобальное сжатие данных, мультиарендность, многопротокольный доступ к одним и тем же данным, списки контроля доступа, аналитику емкости и производительности, и моментальные снимки с нулевым воздействием.

Преимущество VAST перед параллельными файловыми системами заключается в том, что первая использует NFS в качестве стандартного протокола, который не меняется при обновлении. Следовательно, когда серверы VAST обновляются до новых версий, это не требует соответствующих изменений на клиентах. Это устраняет необходимость тщательного планирования и реализации во время обновлений, которые могут повлечь за собой сбои в работе и/или простои.

Встроенная поддержка RDMA

Платформа Universal Storage может быть подключена через сети Ethernet и InfiniBand без использования шлюзов или маршрутизаторов протоколов, что обеспечивает гибкость в многовариантных сетях. С добавлением RDMA производительность NFS может выйти за пределы TCP/IP. Доступ к системе можно получить либо через NFS, либо через NFS over RDMA, что позволяет одному клиенту NFS насыщать 100-гигабитное соединение (например, 11 Гбайт/с через EDR). Серверы VAST могут быть объединены в группы ресурсов, что позволяет получить доступ к кластеру через несколько сетевых подсетей, не требуя, чтобы каждая подсеть имела доступ ко всему пулу серверов. Это обеспечивает полную дезагрегацию сети, позволяя каждому серверу иметь доступ к глобальному состоянию кластера через NVMe-oF.

Глобальная блокировка файлов, когерентность кэша

Платформа VAST Universal Storage поддерживает Network Lock Man ager (NLM) протокол (блокировка диапазона байтов) для запроса и снятия блокировки файлов и диапазонов байтов. NLM допускает разделяемые и эксклюзивные блокировки для приложений и предназначен для параллельных приложений, где можно одновременно заблокировать множество диапазонов байтов в одном файле. Подход VAST Data к блокировке NLM по своей сути является масштабируемым, поскольку блокировка и управление блокировкой полностью распределены по кластеру VAST. Кластеры VAST используют архитектуру DASE, чтобы устранить необходимость в централизованном управлении блокировками. Вместо этого информация о блокировках хранится в виде расширенных метаданных файловой системы для каждого файла в V-дереве VAST, распределен ном глобально по SCM системам. Поскольку все системные метаданные доступны для всех узлов хранения в кластере, каждый узел хранения может создавать, освобождать или запрашивать состояние блокировки каждого файла, к которому он обращается, без сервера центрального диспетчера блокировки, который может стать узким местом в системе. Несмотря на то, что он оптимизирован для случайного ввода-вывода, когда данные сначала записываются в SCM, существует возможность отключить кэширование клиента, когда оно не требуется приложению. При отключении кэширования клиента с помощью параметров sync или o_direct записи становятся атомарными операциями, а проблема согласованности клиента в устаревших системах NFS решена. Приложения, требующие включения кешей, используют глобальную блокировку файлов.

Глобальное сжатие данных

Инновации VAST Data в сокращении данных (известные как сокращение данных на основе подобия) объединяют сжатие и дедупликацию в новую возможность, которая значительно сокращает объем файловых и объектных данных. Компрессор сканирует данные на наличие повторяющихся шаблонов, заменяет их более мелкими символами и создает словарь, чтобы декомпрессор мог обратить процесс вспять. Он работает глобально для всех файлов (дедупликация на основе блоков), а сопоставление с образцом осуществляется побайтно. Поскольку сопоставление с образцом работает с точностью до 1/4000 по сравнению с традиционными алгоритмами дедупликации, оно менее чувствительно к различиям в данных. Эта функция уменьшает данные, которые уже были сжаты приложениями. Во многих крупномасштабных HPC-средах обычно наблюдается коэффициент сокращения данных 2,5:1. На практике сокращение данных было достигнуто с помощью предварительно сжатых данных в геномике (2:1), сейсмических данных (2,5:1), устройствах резервного копирования (3,1, предуплицированные), файлах анимации/VFX (3:1), индексных данных и файлы журналов (4:1), данные торгового рынка (8:1) и резервные данные (20:1). Эти коэффициенты сокращения предназначены для оперативных данных, и, поскольку сокращение данных VAST всегда включено, они всегда сокращают все данные.

Оптимизация стоимости All-Flash Universal Storage VAST Data

Платформа Universal Storage разработана как одноуровневая система хранения данных на основе флэш-памяти, которая обеспечивает экономичность хранилища, реализованных на основе HDD. Стратегия хранения данных на флэш-дисках сейчас важна как никогда, поскольку рабочие нагрузки HPC (ориентированные на запись) и AI (ориентированные на чтение) объединяются в общую вычислительную инфраструктуру с высокой производительностью, состоящую из сочетания процессоров и сопроцессоров/ускорителей (например, CPU, GPU и FPGA).

Ввод-вывод чтения также характеризуется случайным множеством маленьких файлов (LOSF, lots of small files), которые не могут быть детерминировано предварительно загружены в какой-либо буфер или уровень кэша в хранилище. Промахи кэша, которые передаются в хранилище на жестком диске, могут стоить организациям до 98% потери производительности и влиять на эффективность вычислений ИИ. Это связано с тем, что жесткие диски не могут хорошо справляться со случайным чтением. Чтобы прочитать случайный блок на диске, головке необходимо переместиться на нужную дорожку по радиусу пластины (время поиска до ~15 мс). За тем диск должен вращаться до тех пор, пока сектор или блок не окажется под головкой чтения/записи (задержка вращения ~ 6 мс). По этой причине жесткий диск при случайном чтении 4K работает со скоростью 1–3 МБ/с при 50–90 IOPS.

All-flash подход VAST Data позволяет компании обслуживать клиентов HPC и AI с высокой плотностью пропускной способности, а также с неограниченным количеством операций ввода-вывода в секунду по цене менее производительного решения с жесткими дисками. Что касается снижения затрат на использование дорогих компонентов all-flash, VAST Data постоянно и агрессивно оптимизирует аппаратные и программные уровни:

- для оборудования: эффективность и производительность достигаются за счет интеграции NVMe-oF, QLC (4 бита на ячейку), PLC нового поколения (5 бит на ячейку) и SCM;

- для программного обеспечения: методы сжатия и сокращения данных с использованием хэшей подобия и адаптивного разделения на блоки с переменной длиной блока обеспечивают 23 кратное преимущество по сравнению с аналогичными продуктами.

В целом, они эффективно сохраняют и увеличивают емкость хранилища и значительно сокращают затраты на внедрение системы VAST all-flash.

VAST Data нацелен на три цели, которые большинство предприятий и учреждений стремятся достичь при обновлении технологий:

- переход к более эффективной, гибкой и масштабируемой архитектуре инфраструктуры;

- консолидация критически важных для производительности рабочих нагрузок, таких как HPC и AI/ML;

- снижение операционных накладных расходов и затрат.

Новая эпоха инфраструктур для больших данных

Hadoop, наряду с файловой системой Hadoop (HDFS), был ведущей платформой для анализа данных 2010-х годов. Hadoop был спроектирован с учетом технических ограничений того времени, когда сеть была основным узким местом, а вычисления с локальным хранилищем были относительно быстрыми [3].

HDFS реализовала распределенную архитектуру без общего доступа, создавая копии данных на нескольких узлах с прямым подключением к хранилищу. Эта модель допускала локальную обработку данных без необходимости обхода сетей и хорошо работала для пакетно-ориентированных рабочих нагрузок наряду со сравнительно небольшими наборами данных того времени.

Несколько факторов привели к упадку Hadoop:

- аналитика переходит от пакетной обработки к запросам в реальном времени;

- объемы наборов данных выходят за пределы масштаба, который практически удобен для управления с помощью HDFS;

- современные средства анализа данных, такие как Spark, Presto, Elastic и Kafka, теперь поддерживают S3 и NFS.

Требования к хранилищу больших данных

Широкое внедрение аналитики, а также искусственного интеллекта предъявляет новые требования к инфраструктуре хранения:

- предсказуемое время отклика независимо от размера файла и шаблонов доступа. HDFS борется с вводом-выводом небольших файлов, что ограничивает ее гибкость. Выбранная платформа не должна ограничивать будущие рабочие нагрузки;

- масштабируемая производительность, предназначенная для массового параллелизма. Репозиторий данных должен быть в состоянии обрабатывать доступ нескольких приложений одновременно, а также многопоточные рабочие нагрузки для обеспечения высокой производительности;

- реакция в режиме реального времени по мере роста наборов данных. Метод масштабирования может повлиять на производительность. Решения, реализующие многоуровневость, могут страдать от нестабильной производительности, поскольку данные извлекаются из менее производительных уровней. Кроме того, архитектуры без общего доступа или те, которые полагаются на федерацию («кластер кластеров»), могут стабилизироваться или снижать производительность после определенной точки;

- поддержка всех типов аналитики, включая пакетную, Adhoc, ML и другие. Постоянно расширяющаяся экосистема аналитических приложений требует большей гибкости, чем разработанные специально для Hadoop;

- низкая совокупная стоимость владения флэш-памятью. Платформа хранения должна быть ориентирована на флэш-память с “умеренной” стоимостью с целью поддержания максимальной производительности и возможности расширять наборы данных без ущерба для бюджета.

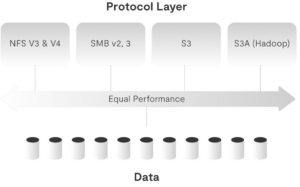

Мультипротокольность для поддержания современных рабочих нагрузок

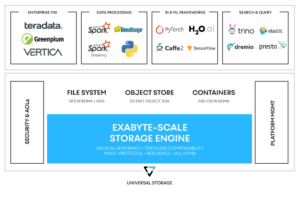

Объектный доступ, в частности, S3 API фактически стал протоколом де-факто для аналитических рабочих нагрузок. При этом многие аналитические приложения также используют и протокол NFS (рис. 2).

Рис. 2. Мультипротольность – необходимая опция хранилищ для поддержания современных нагрузок больших данных.

Гибкость поддержки как S3, так и NFS обеспечивает значительные преимущества:

- поддержка приложений, которые требуют или предпочитают POSIX;

- NFSoRDMA + GPUDirect обеспечивает исключительную производительность;

- перспективный доступ к данным;

- возможность избежать разрастания данных и проблем с согласованностью.

Современные вызовы требуют современной архитектуры

Чтобы оценить варианты хранения для аналитики, полезно просмотреть доступные сегодня архитектуры хранения:

“Ничего общего” (Shared Nothing)

Масштабируемые архитектуры типа “ничего общего” были впервые разработаны более 20 лет назад и оптимизированы для медленных сетей, механических жестких дисков и наборов данных размером до десятков петабайт (рис. 3). Модель без общего доступа объединяет носители данных и вычислительные ресурсы в один базовый строительный блок, называемый узлом. Эти узлы предоставляют приложениям службы NAS или Object API, а также выполняют задачи по защите данных, такие как репликация и стирающее кодирование. Сегодня системы хранения без общего доступа поддерживают флэш-носители, но архитектура, разработанная с учетом ограничений механических жестких дисков, может значительно снизить срок службы при активных рабочих нагрузках.

Каждый узел кластера без общего доступа состоит из вычислений с хранилищем с прямым подключением (DAS). Как упоминалось ранее, это позволяет выполнять локальную обработку данных, однако для ввода-вывода также требуется связь между членами кластера. Эта связь между кластерами растет экспоненциально по мере расширения кластеров и является ограничивающим фактором для масштабирования производительности и емкости. Сочетание хранилища и вычислений как тесно связанного блока означает, что емкость и производительность нельзя масштабировать независимо друг от друга. Это отсутствие гибкости обычно приводит к тому, что клиенты чрезмерно выделяют один фактор, чтобы удовлетворить требования другого.

Дезагрегированный, общий доступ ко всему (DASE, Disaggregated, Shared Everything)

DASE — это переработанная архитектура горизонтально масштабируемого хранилища, основанная на высокоскоростных сетях с малой задержкой и флэш-хранилище, созданном для эксабайтных наборов данных. DASE устраняет ключевые ограничения Shared Nothing, дезагрегируя вычислительные ресурсы и хранилище в высокоскоростной фабрике NVMe с малой задержкой.

В отличие от узлов Shared Nothing, каждый VAST CNode (вычислительный узел) имеет равный доступ к общим постоянным устройствам NVMe в высокодоступных хранилищах. Эта высокопроизводительная инфраструктура позволяет VAST CNodes быть машинами без сохранения состояния, которым не нужно координировать запросы ввода‑вывода друг с другом, тем самым устраняя ограничения масштабирования и жесткость Shared Nothing.

Рис. 3. Сравнение архитектур Shared Nothing и VAST DASE.

Фабрика NVMe подключает CNodes к корпусам хранения с задержкой всего в несколько микросекунд, предоставляя преимущества хранилища с прямым подключением без каких-либо ограничений. Это позволяет пользователям масштабировать производительность кластера, добавляя и удаляя интерфейсные CNodes из пулов независимо от емкости кластера, управляемой путем добавления корпусов хранения.

Преимущество VAST DASE

Сравнение VAST Disaggregated, Shared Everything и HDFS с Shared Nothing представлено на рис. 4. Оно иллюстрирует преимущества перехода на современную платформу. Эффективность, ставшая возможной благодаря архитектуре, основанной на NMVe, в сочетании с сокращением объемов данных и защитой данных с низки ми издержками, впечатляет по сравнению с хранилищем HDFS с защитой данных с тройным копированием. Клиенты получают дополнительные преимущества за счет уменьшения занимаемого места в стойке и экономии электроэнергии.

Рис. 4. Сравнение архитектур HDFS и VAST DASE [3, 5].

Сравнение архитектуры VAST DASE с архитектурами Pure Flashblade, MinIO, Cloudera Ozone и Dell PowerScale дано на рис. 5.

Рис. 5. Сравнение архитектуры VAST DASE с архитектурами Pure Flashblade, MinIO, Cloudera Ozone, Dell PowerScale.

VAST Catalog

В конце февраля 2023 г. VAST Data выпустила релиз v4.6 – v4.7 своей VAST OS, являющийся самым крупным обновлением за всю историю VAST Data. Среди новшеств [7]:

- каталогизация в табличном виде неструктурированных данных, что дает возможность работы с ними как базами данных по SQL запросам;

- расширенные возможности QOS для каждого пользователя;

- расширенные возможности управления ключами шифрования;

- теперь клиенты могут делать до 100 000 моментальных снимков с любой глубиной пространства имен с точностью до 15 сек;

- прогнозирование использования ресурсов на основе обучаемой модели;

- расширенная поддержка концеции ZeroTrust;

- CSIVAST теперь поддерживает различные классы хранения для постоянных и эфимерных томов контейнеров Kubernetes.

Среди ключевых отличий VAST Data от других предложений на рынке следующие [8]:

- производительность Al-lFlash: VAST — это унифицированная платформа данных, которая демократизирует быстрый доступ ко всем данным с помощью all-flash. Платформа представляет себя приложениям и пользователям как хранилище объектов и масштабируемая система NAS. Структурированные и неструктурированные данные могут быть загружены из самых разных приложений и источников в единый унифицированный репозиторий для анализа и обработки;

- многопротокольный доступ к данным (рис. 6): объектный интерфейс VAST (S3) обеспечивает интеграцию с наборами инструментов для анализа больших данных, такими как MapReduce, HIVE и Spark. Кроме того, он поддерживает механизмы распределенных запросов (например, Dremio, Trino, Presto) и хранилища данных с ускорением на GPU (например, SQream). Поскольку VAST может представлять пространство имен с использованием стандартных NFSv3 и NFSv4, система также поддерживает традиционные аналитические приложения и базы данных, такие как SAS Grid, Postgres и KDB. Teradata, Splunk, ElasticSearch и Vertica могут интегрироваться с использованием S3 или NFS.

Рис. 6. Мультипротокольная поддержка доступа к данным VAST Data.

Поскольку VAST также поддерживает Windows SMB-протокол обмена файлами, аналитики и другие пользователи могут легко получать доступ к отчетам и выводить данные со своих рабочих станций без необходимости копирования в отдельную систему хранения или приобретения специальных инструментов или навыков, как это требуется при взаимодействии с системами на основе HDFS. Это означает, что VAST подходит для различных целей, в том числе:

- поддержки устаревших аналитических приложений в стиле хранилища данных (data warehouse);

- поддержки промежуточного уровня обработки данных в озере данных;

- ETL & ELT;

- специальной аналитики (Ad hoc) с использованием таких инструментов, как Presto, Trino, Impala и Dremio;

- новых инструментов AI/ML;

- поддержка GPU Direct Storage: VAST предлагает инновационный подход к AI/ML/DL за счет повышения активности и эффективности GPU. Использование GPU Direct Storage позволяет передавать данные, поступающие из VAST, напрямую с сетевой карты на сервере GPU в память GPU. Это приводит к более высокой пропускной способности, а также к устранению накладных расходов графического процессора на обработку ввода-вывода;

- ведущее в мире сокращение данных: VAST обеспечивает лучшее в своем классе сокращение данных с помощью алгоритмов данных, основанных на сходстве. Для структурированных или полуструктурированных данных в формате значений, разделенных запятыми или табуляцией, VAST обеспечивает сокращение данных от 3:1 до 4:1 без какого-либо ущерба для производительности. Даже если данные были предварительно сжаты, как в случае с такими форматами, как Parquet, обеспечивается дополнительная экономия 1,45:1;

- современная архитектура для современных рабочих нагрузок: VAST использует DASE-подход (Dis-Aggregated Shared Everything) к архитектуре хранения. Этот уникальный и хорошо масштабируемый подход позволяет клиентам масштабировать емкость хранилища независимо от его производительности. Им не нужно поддерживать фиксированное соотношение емкости и производительности, и они могут настраивать систему по мере изменения своих потребностей с течением времени.

Одно из ключевых преимуществ архитектуры от VAST DASE — это возможность масштабирования до эксабайтов емкости для миллиардов файлов и объектов. Но с этим масштабом возникает проблема управления всеми этими данными. Чтобы решить эту проблему, VAST создал встроенный индекс метаданных был назван каталогом VAST. Теперь можно легко искать и находить данные – в несколько раз быстрее, чем традиционные методы. Эта технология дает возможность пользователям и приложениям начать рассматривать файловую систему как базу данных, позволяя приложениям искусственного интеллекта и машинного обучения следующего поколения использовать ее в качестве самореферентного хранилища функций [9].

Каталог VAST является основой семантического слоя. Этот уровень, состоящий из файлов и объектов, избавляет от необходимости создавать или поддерживать отдельные системы. Теперь специалисты по бизнесу и предметной области могут быстро находить данные и получать к ним доступ, используя стандартные условия поиска. Несколько примеров того, как клиенты могут использовать каталог VAST рассматриваются далее.

Магазин функций AI/ML

На высоком уровне модели AI и ML должны обучаться на данных, и все чаще на значительных их объемах. Когда эти данные обрабатываются и анализируются, генерируются функции и атрибуты каждой части данных. Эти функции должны храниться где-то, что бы их можно было быстро и легко восстановить. Исторически сложилось так, что инженеры по работе с данными и инженеры по эксплуатации машинного обучения поддерживали отдельные базы данных или индексы, в которых хранится эта информация. Часто эти отдельные хранилища функций будут иметь ссылки или указатели на исходные файлы или объекты. Эту родословную важно сохранить нетронутой, потому что нужно иметь возможность найти точные данные, используемые для создания функций, которые, в свою очередь, влияют на разработку модели.

Когда хранилище функций и хранилище данных являются отдельными объектами, может быть сложно обеспечить сохранение этой родословной. Это также означает, что может быть два «источника истины», что может привести к расхождению, дублированию данных и сложности «доказать», что они синхронизированы друг с другом.

Используя каталог VAST, инженеры по операциям с данными и машинным обучением могут напрямую использовать метаданные объектов и файловой системы для встраивания функций и атрибутов непосредственно в хранилище объектов с помощью тегов S3 и метаданных объектов S3, зная, что они будут проиндексированы и готовы к запросу. Это также означает, что их приложения могут рассматривать его как хранилище функций.

Представьте, если бы было возможно загрузить серию объектов S3, каждый из которых имеет метаданные, которые выглядят следующим образом:

“Metadata”: {

“city”: “Pittsburgh”,

“make”: “Apple”,

“model”: “iPhone 14”,

“state”: “Pennsylvania”,

“zip”: “15218”,

“processed”: “false” }

После загрузки объектов можно запустить запрос и найти любой файл, который не был обработан, как указано тегом processed:

SELECT parent_path,name,size,user_tags FROM “vast_big_catalog_table:/” where user_tags_count > 0

AND element_at(user_tags, ‘processed’)=’false’; parent_path | name | size | user_tags

—————+————————————————————

/photos/ | andycoffin.jpg | 414403 | {processed=false}

/vfs/processed/false/ | PXL_20230115_082215604.jpg | 3143258 | {processed=false}

/photos/ | PXL_20230215_222637434.MP.jpg | 5779131 | {processed=false}

Обслуживание файловой системы

Клиенты доверяют VAST многие ПБ (некоторые из них — сотни ПБ) важных для бизнеса неструктурированных данных. В большинстве случаев клиенты используют VAST в качестве точки консолидации для ряда ранее разрозненных рабочих нагрузок, начиная с нуля и заканчивая домашними каталогами, от озер данных до репозиториев резервных копий. Объединение всех этих данных позволило значительно повысить эффективность с точки зрения затрат, а также снижения нагрузки на приложения и администрирования.

Тем не менее, остается проблема: как в системе, в которой размещены ПБ данных из миллиардов файлов и объектов, пользователям легко найти то, что они ищут? Как администраторы могут понять, как используются их ресурсы, и убедиться, что они продолжают эффективно обслуживать своих пользователей?

Конечно, можно использовать сторонний продукт или приложение с открытым исходным кодом для обхода и индексации вашей файловой системы, но это создает новый набор проблем:

- сканирование файловых систем занимает много времени — в некоторых случаях несколько дней. Это означает, что ваш каталог всегда не синхронизирован с фактическим текущим со стоянием файловой системы;

- сканирование может создать нагрузку на файловую систему, что может повлиять на производительность рабочих приложений и пользователей;

- продукты сторонних производителей — это дополнительная инфраструктура для управления и обслуживания; не говоря уже о дополнительных затратах на серверы и программное обеспечение.

Теперь представьте, что есть каталог, который может рассказать все, что необходимо знать о том, что хранится в вашей файловой системе и всегда актуально. Что при этом можно сделать:

- найти все файлы старше 90 дней размером более 10 ГБ, существующие в каталоге /projects;

- найти все файлы, созданные с прошлой недели определенным пользователем;

- найти все объекты с тегом «обработано», где значение = false;

- ранжировать пользователей, потребляющих больше всего ресурсов, в определенной папке/проекте;

- изучить типы данных в системе, ранжируя емкость по расширению файла.

Как это работает

Резервный магазин каталога VAST

Любой каталог метаданных должен опираться на какую-либо базу данных, чтобы хранить всю информацию о файлах и объектах. Ряд внешних систем, используемых сегодня, используют технологии с открытым исходным кодом, такие как mysql, postgres, cassandra или elastic. Была рассмотрена возможность использования таких механизмов, но в конечном итоге стало понятно, что они станут узкими местами с точки зрения масштабируемости и производительности. Кроме того, придется найти способ упаковать их и управлять ими, что увеличивает административную нагрузку. Поэтому была создана собственная база данных с ее ориентацией необходимую масштабируемость, производительность и простоту использования. В случае каталога VAST он не требует администрирования или настройки – просто обновляйте VAST SW до последней версии (4.6), и он готов к работе.

Изучение таблицы базы данных, используемой каталогом, иллюстрирует атрибуты метаданных, которые извлекаются:

- одна запись (строка) для каждого файла или объекта;

- каждый интересующий атрибут метаданных представляет собой отдельный столбец;

- сложные атрибуты метаданных (например, теги S3) хранятся в столбцах «карты» (представьте, что документ JSON находится в одной ячейке):

- для часто используемых тегов и метаданных объектов: индексированные поля можно добавлять на лету.

Ниже приведена схема таблицы, используемая каталогом VAST:

Column |

Type |

Description |

phandle |

row() |

VAST internal identifier for each object/file (comparable to an inode number) |

creation_time |

timestamp |

Element creation time (birthtime) |

uid |

integer |

POSIX UID of file (owner) |

owner_sid |

varchar |

Windows owner SID (owner) |

owner_name |

varchar |

Owner user name |

gid |

integer |

POSIX GID of file (group) |

group_owner_sid |

varchar |

Windows group SID |

group_owner_name |

varchar |

Group owner name |

atime |

timestamp |

atime – last access time |

mtime |

timestamp |

mtime – last content modification time |

ctime |

timestamp |

ctime – last file system metadata change time |

nlinks |

integer |

Number of associated hard links |

element_type |

integer |

(eg: file, directory, named pipe, etc) |

size |

integer |

Size of file/object |

used |

integer |

Space used by file/object |

name |

varchar |

File name |

extension |

varchar |

File name extension (e.g. “gz” or “exe”) |

parent_path |

varchar |

Parent path of file (dirname) |

symlink_path |

varchar |

If object is a symlink, this is the target |

major_device |

integer |

|

minor_device |

integer |

|

s3_locks_retention |

row() |

|

nfs_mode_bits |

integer |

POSIX permissions mode (as integer) |

name_aces_exist |

boolean |

Flag to indicate extended ACEs (NTFS/NFS4/Posix) exist on this element |

s3_locks_legal_hold |

boolean |

Legal hold lock on this object |

user_tags_count |

integer |

Number of tags associated with this object |

user_metadata |

map() |

Metadata items on object (xamzmeta) |

user_tags |

map() |

S3 Tags associated with this object |

Базовые таблицы VAST DB поддерживают эволюцию схемы, что означает возможность добавления новых столбцов в будущем. Потенциальный вариант использования в будущем — очистить заголовки распространенных типов файлов и сохранить их в индексе.

Для поддержания этой таблицы в актуальном состоянии требуется масштабируемый механизм, который может обнаруживать изменения и вставлять их без ущерба для производительности системы. Для этого была задействована основная функция, которая использовалась в VAST более двух лет: механизм моментальных снимков и репликации. На основе определяемого пользователем расписания (которое может происходить каждые 15 секунд) VAST делает моментальный снимок в корне файловой системы и создает список изменений, которые вставляются в таблицу. Все это происходит без вмешательства пользователя и не требует дополнительного управления или мониторинга.

Кроме того, поскольку для этой цели была использована технология моментальных снимков, также делаются снимки самого каталога. Это означает, что всегда есть исторические версии каталога, которые можно использовать для ряда вариантов использования, например, для запросов к каталогу VAST в определенные моменты времени для сравнения.

Взаимодействие с каталогом VAST

Поскольку мы обслуживаем самых разных клиентов с разными предпочтениями в отношении того, как они используют свои данные, мы хотели охватить все основы, когда речь шла о том, как они могут взаимодействовать с каталогом VAST.

Веб-интерфейс

VAST предоставляет интуитивно понятный и быстрореагирующий пользовательский интерфейс, который позволяет администраторам легко выполнять поиск и запросы, используя любой из выше упомянутых атрибутов, чтобы найти именно то, что они ищут. “Огранка” результатов проста и требует всего несколько коротких кликов. Результаты отображаются в течение нескольких секунд, даже если файловая система заполнена миллионами или даже миллиардами файлов и объектов.

CLI Опытные пользователи оценят богатый интерфейс командной строки, который обеспечивает все те же функции пользовательского интерфейса, а также позволяет выполнять конвейерную обработку команд для лучшей сортировки и агрегирования. Рассмотрим следующую команду, которая суммирует емкость, потребляемую файлами данного пользователя, с учетом минимального размера и расширения файла:

bigcatalog query \ —path /nametest \

—extension pdf \

—uid 50006 \

—size 52428800: \

l1000\

|gawk F\| ‘{print $4}’ |gawk ‘{s+=$1} END {print s}’

API

Фактически VAST предоставляет два API для взаимодействия с VAST-каталогом:

- стандартный RESTful API, доступный для всех административных аспектов, также можно использовать для выполнения запросов к каталогу VAST;

- новый python SDK, обеспечивающий прямое взаимодействие с базовой базой данных, в которой находится каталог VAST. Это может позволить создавать более сложные приложения и включать их в конвейеры AI и ML.

Механизмы запросов

VAST также предоставляет каталог, а также пользовательские таблицы базы данных, используя некоторые из самых популярных механизмов запросов с открытым исходным кодом. Сегодня ApacheSpark, а также Trino поддерживаются за счет использования соединителя хранилища, развернутого на этих ядрах.

Использование механизма запросов предлагает некоторые дополнительные преимущества:

- использование диалекта SQL для формирования запросов, что обеспечивает значительную мощность и гибкость;

- улучшение производительности запросов при использовании механизма распределенных запросов;

- улучшенную поддержку функций агрегации.

Вот несколько примеров:

SELECT parent_path,name,size,uid FROM “vast_big_catalog_table:/” WHERE uid = 50006 AND size > 52428800 AND extension = ‘pdf’; Пример агрегации: SELECT sum(used) FROM “vast_big_catalog_table:/nametest” WHERE uid = 50006 AND size > 52428800;

Применения

IDC опросила клиентов VAST Data из двух отраслей (академические исследовательские институты и финансовые службы), чтобы получить представление о универсальной адаптивности платформы Universal Storage [2].

Пример 1. Ведущий исследовательский университет

Варианты использования: генетика, геномика, моделирование и симуляции: вычислительная гидродинамика (CFD), физика высоких энергий.

IDC взяла интервью у руководителя отдела исследовательских вычислений в частном исследовательском университете, курирующем две крупные среды высокопроизводительных вычислений. ИТ-команда состоит из пяти сотрудников, обслуживающих 2200 пользователей.

Инфраструктура высокопроизводительных вычислений состоит из 2000 серверов с примерно 10 000 процессорных ядер, 200 графических процессоров и 2 ПБ данных VAST. Университет перешел через несколько поколений графических процессоров и в настоящее время сообщает о миллиардах часов использования графических процессоров (1/150 ЦП). Среда высокопроизводительных вычислений в значительной степени основана на фабрике Ethernet с некоторым количеством InfiniBand, но в конечном итоге университет планирует полностью перейти на Ethernet. Стек программного обеспечения полностью основан на открытом исходном коде, что типично для большинства университетов.

Университет установил VAST менее двух лет назад, опередив огромный спрос на свои среды HPC. В результате он планирует удвоить всю свою инфраструктуру за несколько месяцев.

Решение использовать VAST Data — после оценки других систем хранения на рынке — было принято на основе затрат на управление и возможности масштабирования производительности по мере увеличения размера сред.

Опыт университета с VAST был очень положительным. До сих пор у среды не было простоев, что значительно улучшило качество обслуживания. ИТ-администраторы университета, которые также являются исследователями, довольны простотой управления и обслуживания (несколько часов обслуживания каждый квартал) и быстрым обращением за поддержкой (решение проблемы занимает несколько минут). Высокая интегрируемость (NFS, SMB и отсутствие многоуровневого хранения) позволила университету быстро нарастить свою инфраструктуру хранения, не прибегая к сложности хранилища HPC. Это позволило ИТ-персоналу уделять больше времени своим исследованиям.

ИТ-команда, как одна из первых внедривших VAST, считает, что они еще не достигли пределов своей среды высокопроизводительных вычислений с точки зрения производительности, пропускной способности, задержки и масштабирования. Их опыт работы с VAST вселил в сотрудников уверенность в том, что они смогут перейти на использование платформы Universal Storage в качестве единственного и единственного решения для хранения HPC для всех своих приложений в течение шести месяцев. «Все известные мне университеты уже установили VAST (имеется в виду шесть других университетов)», — сказал собеседник.

Пример 2. Финансовая торговая фирма

Варианты использования: AI/ML/Deep Learning Training and Inference.

IDC взяла интервью у директора по финансовым услугам ведущей компании, предоставляющей финансовые услуги, которая курирует четыре среды высокопроизводительных вычислений, поддерживающих глобальные торговые операции. Эти среды расположены в Нью-Йорке, Сингапуре, Лондоне и Норвегии. Локальная инфраструктура высокопроизводительных вычислений фирмы состоит из кластеров с 2000 серверов и 10 ПБ данных VAST во всех местах.

В фирме работают три ИТ-администратора для управления инфраструктурой хранения. Прежде чем выбрать VAST Universal Storage, компания изучила множество локальных и облачных решений для хранения данных. В конечном итоге решение VAST выиграло благодаря простоте управления и обслуживания, сервисам данных корпоративного уровня и, что особенно важно, производительности в любом масштабе.

Развертывание VAST было частью более крупной стратегии цифровой трансформации ИТ, направленной на оптимизацию инфраструктуры и упрощение поддержки при одновременном обеспечении производительности и масштабируемости для сред высокопроизводительных вычислений. Фирма увидела огромную ценность для бизнеса в переходе на VAST:

- среда VAST сделала ИТ-операции более гибкими и быстрореагирующими на потребности бизнеса, поскольку они могут выполнять больше заданий без дополнительного оборудования. Например, исследовательский стек фирмы насчитывает 10 000 одновременных заданий, которыми можно легко управлять на платформе VAST. Время, необходимое для развертывания новых ресурсов хранения, сократилось на 90% (до пяти часов по сравнению со средними двумя днями);

- после перехода на VAST фирма не сталкивалась с замедлением работы или перерывами в работе исследовательских или производственных работ. Например, количество незапланированных простоев в месяц сократилось до нуля с трех в среднем, а среднемесячное время незапланированных простоев сократилось до нуля с шести часов в среднем. Без простоев нет потери производительности пользователей, потери данных и никакого влияния на бизнес;

- компания пришла к выводу, что платформа VAST Data Universal Storage по стоимости сопоставима с корпоративными решениями для хранения данных на основе жестких дисков. Фирма добилась дополнительной экономии эксплуатационных расходов с помощью VAST за счет лучшей поддержки и нулевого времени про стоя, а также за счет перехода на NFS (таким образом отказавшись от покупки проприетарных лицензий на хранение).

Источники, доп. ресурсы

[1] Magic Quadrant for Distributed File Systems and Object Stor age. Published 19 October 2022

[2] IDC White Paper: HighPerformance NFS Storage for HPCAI. Sponsored by: VAST Data. January 2023

[3] Comparing Storage Platforms for Big Data Applications. 02 2023

[4] Universal Storage. Innovation to Break Decades of Tradeoffs. OCTOBER 2022

[5] UNIVERSAL STORAGE FOR DATA ANALYTICS, solution brief

[6] VAST DATA CERES LAUNCH 2022

[7] Our Biggest Software Release, Ever. By Jeff Denworth February 22, 2023

[8] VAST Data Ranked #1 for Analytics Use Case in the 2022 Gartner®? Critical Capabilities for Distributed File Systems and Object Storage Report. By Andy Pernsteiner, Field CTO, VAST Data January 11, 2023

[9] VAST Catalog: Treat Your File System Like a Database. By Andy Pernsteiner. February 28, 2023

Авторы: Гантимуров А.П., Калашник А.Г.

Отслеживать

Отслеживать