Введение

DDN (DataDirect Networks, https://www.ddn.com/) — крупнейшая в мире частная компания по хранению данных, образованная в 1998 г. В 2022 г. оборот компании составил $352 млн. В портфеле DDN представлены все типы СХД: NAS, блочные, объектное хранилище, а также собственные кластерные файловые системы и системы управления данными. В последнее время DDN позиционирует себя как ведущий поставщик технологий и инфраструктурных решений для крупных предприятий и клиентов в области искусственного интеллекта, аналитики и высокопроизводительных вычислений.

В июне 2018 года DDN приобрела у Intel команду разработчиков файловых систем Lustre, возродив бренд Whamcloud. В сентябре 2018 года DDN продолжила расширение за счет покупки компании Tintri, специализирующейся на виртуализации. В мае 2019 года DDN приобрела поставщика программно-определяемых систем хранения данных Nexenta. В ноябре 2019 года DDN завершила приобретение подразделения IntelliFlash, ранее известного как Tegile, у Western Digital. Эти последние три приобретения стали бизнес-подразделением Tintri Enterprise (https://en.wikipedia.org/wiki/DataDirect_Networks).

DDN тесно сотрудничает с NVIDIA и в качестве своей одной из основных целей ставит задачу разработки кластерных высокомасштабируемых гибридных HPC/AI-решений с интенсивным использованием данных для поддержки нескольких сотен GPU, а в облаке и тысяч GPU (с поддержкой скорости доступа к данным для одного GPU от 1 до 2 Гбайт/с с размером файла до 500 Тбайт) [1]. Данные решения DDN строит на базе параллельной файловой системы DDN EXAScaler®, которая включает Intel® Enterprise Edition for Lustre и DDN Multi-Level Security (MLS) Solution for Lustre, с использованием собственных СХД – ES14KX™, ES12KX®, ES7KX®.

В мае 2023 г. DDN® объявила (https://www.ddn.com/press-releases/ddn-is-the-leading-data-storage-company-behind-the-machine-learning-and-generative-ai-explosion/), что за первые четыре месяца 2023 года она продала больше AI storage appliances, чем за весь 2022 год. Широкий энтузиазм по поводу бизнес-возможностей, предоставляемых генеративным искусственным интеллектом, привел к устойчивому увеличению инвестиций в искусственный интеллект и инфраструктуру искусственного интеллекта.

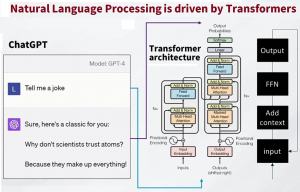

Языковые приложения искусственного интеллекта, такие как ChatGPT, привлекли большое внимание. Но есть ряд других вариантов использования искусственного интеллекта, в которых ожидаются значительные прорывы: сверхреалистичные 3D и иммерсивные игровые вселенные, создание сложных новых белков и молекул для открытия лекарств, автономное вождение и исследование космоса — это лишь несколько примеров, когда для стимулирования инноваций требуется масштабная обработка данных.

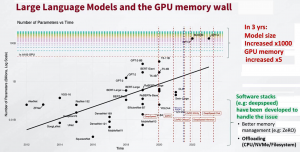

Число параметров моделей уже достигает сотен млрд и растет в геометрической прогрессии. Автономное вождение или обработка естественного языка, огромные наборы данных, собранные из различных источников, лежат в основе приложений генеративного искусственного интеллекта и машинного обучения. Однако для правильной работы им требуется очень высокий уровень производительности записи и чтения данных, чрезвычайно масштабируемая экономичная емкость данных, гибкая доставка локально и в облаке, а также высокая эффективность и минимальное энергопотребление.

В мае 2023 г. DDN выпустила (https://www.ddn.com/press-releases/ddn-qlc-ssd-storage-delivers-10x-speed-for-ai-and-data-centers-at-any-scale/) новые AI400X2 QLC (https://www.ddn.com/products/lustre-file-system-exascaler/) и гибридные массивы хранения данных DDN, построенные на базе параллельной файловой системы DDN с новым функциоалом сжатия данных на стороне клиента, что увеличивает производительность в 10 раз, эффективную емкость до 15 раз. При этом занимаемая площадь центра обработки данных сокращается в 2 раза.

Новая линейка дает возможность расширять (начиная с одного устройства высотой 2U) возможности хранения данных путем добавления дополнительных устройств или корпусов без внесения изменений в архитектуру для удовлетворения растущих требований к производительности или емкости. Кроме того, параллельная файловая система DDN EXAScaler® (https://www.ddn.com/products/lustre-file-system-exascaler/) со сжатием на стороне клиента может повысить производительность за счет обмена сетевого трафика на большее количество доступных циклов CPU.

DDN создала устройство AI400X2 (https://www.ddn.com/products/a3i-accelerated-any-scale-ai/) специально для корпоративных приложений искусственного интеллекта, как локальных развертываний, так и в центрах обработки данных и в облаке. Оно передает до эксабайт данных со скоростью терабайт в секунду при постоянной производительности записи и чтения, обеспечивая в 33 раза более высокую эффективность, чем традиционные системы хранения, при незначительном потреблении энергии.

Награды и достижения DDN

13 сентября 2023 г. DDN объявила (https://www.ddn.com/press-releases/ddn-storage-solutions-deliver-700-gains-in-ai-machine-learning-for-image-segmentation-natural-language-processing/) о результатах производительности своей AI-платформы хранения данных в тестах MLPerf ™ Storage v0.5 (https://mlcommons.org/en/storage-results-05/).

Измерения проводились в категориях Image Segmentation и Natural Language Processing тестаMLPerf Storage с одним и множеством GPU (узлов). При оценке отдельного вычислительного узла одно устройство DDN AI400X2 NVMe, оснащенное параллельной файловой системой DDN EXAScaler® 6.2, полностью обслуживало 40 ускорителей искусственного интеллекта, обеспечивая пропускную способность 16,2 ГБ/с [2]. В многоузловой конфигурации то же устройство DDN AI400X2 NVMe увеличило свою производительность в четыре раза, обслуживая 160 ускорителей на десяти узлах, достигнув пропускной способности 61,6 ГБ/с [3]. Эти результаты демонстрируют повышение эффективности на 700% в расчете на каждый узел хранения по сравнению с представленными конкурирующими локальными решениями.

6 июня 2023 г. DDN® объявила (https://www.ddn.com/press-releases/ddn-customer-cineca-posts-dominating-bandwidth-score-and-recognized-on-io500-list-for-production-systems/), что суперкомпьютер Leonardo (консорциум CINECA, https://www.cineca.it/) достиг наивысшего показателя пропускной способности производственной системы в тесте IO500. Система Leonardo, обеспечивающая вычислительную мощность искусственного интеллекта и высокопроизводительных вычислений для решения неотложных социальных задач, заняла первое место по самой высокой пропускной способности для систем, выполняющих производственные рабочие нагрузки, в недавно анонсированном IO500 на ISC High Performance (ISC) в Гамбурге, Германия, с результатом 807,12 ГБ/с.

Система Leonardo оснащена решением хранения EXAScaler® от DDN и гибридной инфраструктурой, состоящей из уровня флэш-памяти, способного обеспечить пропускную способность более 1,4 ТБ/с, и уровня емкости со 106 ПБ дискового хранилища, что обеспечивает совокупную пропускную способность более 600 ГБ/с. Система, признанная четвертым суперкомпьютером в мире по версии TOP500 (https://www.top500.org/), поддерживает приложения искусственного интеллекта и высокопроизводительных вычислений с интенсивным использованием данных, такие как искусственный интеллект, прогнозирование погоды, биоинженерия и дизайн материалов.

Список IO500 является важным эталоном эффективности систем хранения данных в суперкомпьютерных средах AI и HPC. Список обновляется два раза в год во время Международной конференции по высокопроизводительным вычислениям, сетям, хранилищам и анализу (SC) в США и ISC в Европе. Особое значение имеет то, что IO500 измеряет пропускную способность данных о производительности хранилища (ГБ/с) и скорость чтения/записи (IOPS) в различных тестах, чтобы получить результат, который репрезентативен для типичных рабочих нагрузок, наблюдаемых в системах, используемых для производственных приложений искусственного интеллекта и HPC.

Производственный список сужает количество подходящих систем до тех, которые соответствуют более строгому определению производственной системы. Чтобы соответствовать критериям, эти системы должны ежедневно использоваться конечными пользователями с производственными приложениями в течение длительного периода, а не системами, развернутыми только для целей тестирования, и должны иметь дополнительные характеристики надежности.

В июне 2023 г. DDN® была выбрана (https://www.ddn.com/press-releases/ddn-and-helmholtz-munich-receive-2023-artificial-intelligence-breakthrough-award/) вместе с компанией Helmholtz Munich (https://www.helmholtz-munich.de/en) в качестве победителя премии AI Breakthrough Awards 2023 в номинации «Лучшее решение на основе искусственного интеллекта для наук о жизни».

В рамках Ассоциации Гельмгольца, крупнейшей исследовательской организации Германии, Гельмгольц Мюнхен является одним из 19 исследовательских центров, которые разрабатывают передовые биомедицинские решения и технологии для мира завтрашнего дня. Исследование объединяет методологии искусственного интеллекта и охватывает множество вычислительных приложений с интенсивным использованием данных, таких как расшифровка геномов растений, тестирование образцов тканей или когортные исследования животных и эпидемиологии. Ученые и исследователи из Мюнхенского университета им. Гельмгольца постоянно ищут новые способы более быстрого решения сложных проблем и обратились к технологии параллельной файловой системы DDN, чтобы не отставать от потребностей исследований.

Helmholtz Munich имеет четыре полностью укомплектованные системы SFA® ES7990X (https://www.ddn.com/products/sfa7990x-hybrid-flash-storage-appliance/), которые охватывают глобальное пространство имен, что обеспечивает легкий контроль и управление большими наборами данных, оптимизированные рабочие процессы и непревзойденную производительность, необходимую для сокращения времени на обнаружение. Центр также внедрил систему SFA NVMe ES400NVX (https://www.ddn.com/products/sfa-nvme-storage-platforms/) с интеграцией GPU, которая обеспечивает более высокую пропускную способность данных с прямыми путями передачи данных между хранилищем и графическим процессором специально для интенсивных приложений искусственного интеллекта. Устройства на базе параллельной файловой системы DDN EXAscaler® значительно ускоряют возможности исследователей Helmholtz Munich по ускорению процессов обнаружения, одновременно снижая повседневные риски, связанные со сбором, распространением и анализом больших данных.

Программа AI Breakthrough Awards уже шестой год подряд отмечает выдающиеся достижения, инновации и успехи в области технологий в ряде категорий, связанных с искусственным интеллектом и машинным обучением. Программа этого года привлекла более 3000 номинаций по всему миру.

DDN и Helmholtz Мюнхен недавно провели Life Sciences Field Day 2023 в кампусе имени Гельмгольца в Мюнхене, на котором был рассмотрен широкий спектр тем, включая влияние новых методов искусственного интеллекта на результаты исследований, а также преимущества ускоренных вычислений и сложного управления данными. Презентации таких организаций, как BASF, LuxProvide, Оксфордский университет и Carl Zeiss, а также DDN и Helmholtz Мюнхен теперь доступны по запросу: https://www.ddn.com/company/events/life-sciences-field-day-on-demand/.

Список всех победителей премии AI Breakthrough Awards 2023 можно найти: https://aibreakthroughawards.com/2023-winners/.

Продуктовый портфель DDN

Устройства, разрабатываемые и продвигаемые DDN, можно разделить на две группы: объединяемые под брендом A3I и под брендом EXAScaler. Первая группа, которой DDN уделяет наибольшее внимание (и позиционирует себя как AI Company), это семейство СХД для поддержки ферм GPU в составе NVIDIA DGX SuperPOD™. Вторая группа в бОльшей степени ориентирована на классические НРС-решения и аналитику под управлением Lustre (с устройствами для метаданных и данных, а также с устройствами управления).

Также в портфеле DDN есть продукты из “историчекого” наследия – линейка intelliflash. Все аппаратные решения строятся на базе стандартизованных моделей под управлением real-time ОС – SFA Parallel Storage OS (Storage Fusion Architecture).

В семейство программных продуктов входят: паралельная файловая система EXA 6.2 на базе Lustre, но в значительной степени дополненная и оптимизированная под AI-приложения; ПО DDN DataFlow™ – для управления и DDN Insight – для мониторинга.

Компоненты продуктового портфеля DDN:

– a3i – высокопроизводительные корпоративные эталонные AI-архитектуры и устройство AI400X2 (устройства DDN SFA®) (https://www.ddn.com/products/a3i-accelerated-any-scale-ai/, https://www.ddn.com/resources/brochures-and-datasheets/a3i-datasheet/);

– EXA6 – параллельная файловая система для рабочих нагрузок искусственного интеллекта, высокопроизводительных вычислений и аналитики (https://www.ddn.com/products/lustre-file-system-exascaler/);

– dataflow – высокопроизводительное ПО для управления и защиты данных (класс HPC) (https://www.ddn.com/products/dataflow-backup-archive-data-migration/);

– insight – ПО для детального мониторинга и оптимизации масштабируемых сред (https://www.ddn.com/products/storage-monitoring-ddn-insight/);

– intelliflash – простое, масштабируемое, унифицированное корпоративное хранилище для NAS и SAN (класс HPC) (https://www.ddn.com/products/intelliflash-high-performance-midrange-enterprise-storage/);

– sfa400x2 – устройство с высокой производительностью и эффективностью для самых передовых приложений (https://www.ddn.com/products/sfa-nvme-storage-platforms/);

– sfa200x2 – проверенная флэш-система хранения данных для рабочих нагрузок среднего уровня;

– sfa18kx – масштабируемая гибридная система хранения данных для решения самых масштабных задач по обработке данных (https://www.ddn.com/products/converged-storage-platform-sfa18kx/);

– sfa7990x – гибкая гибридная система хранения данных для упрощения управления.

DDN A3I® Storage Platforms

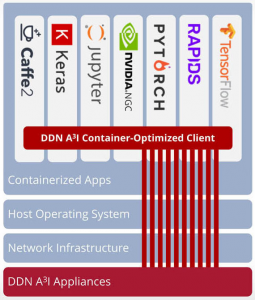

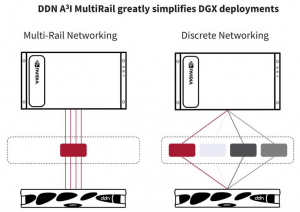

Решения DDN A3I (Accelerated, Any-Scale AI – ускорение AI любого масштаба) открывают новые возможности для искусственного интеллекта (AI) и глубокого обучения (DL), обеспечивая гибкость для потребностей организации в области искусственного интеллекта (рис. 1).

Рис. 1. Возможности эталонных архитектур A3I (https://www.ddn.com/products/a3i-accelerated-any-scale-ai/).

Решения A3I, разработанные с нуля для центров обработки данных с поддержкой искусственного интеллекта, оптимизированы для приема, обучения, преобразования данных, репликации, метаданных и передачи небольших данных.

Решения DDN A3I предназначены для простого развертывания с системами NVIDIA DGX. DDN и NVIDIA тесно сотрудничали для проверки масштабируемых эталонных архитектур для всех систем DGX, включая системы SuperPOD и DGX A100 (рис. 1а).

Рис. 1а. NVIDIA DGX SuperPOD с DGX H100.

NVIDIA DGX SuperPOD™ с системами NVIDIA DGX™A100 – это суперкомпьютерная инфраструктура искусственного интеллекта, обеспечивающая вычислительную мощность, необходимую для обучения современных моделей глубокого обучения (DL) и стимулирования будущих инноваций. DGX SuperPOD обеспечивает революционную производительность, развертывается за несколько недель как полностью интегрированная система и предназначен для решения самых сложных вычислительных задач в мире.

Эталонная архитектура DGX SuperPOD (RA, reference architecture) является результатом сотрудничества ученых DL, инженеров по производительности приложений и системных архитекторов для создания системы, способной поддерживать самый широкий спектр рабочих нагрузок DL. Инновационная производительность, обеспечиваемая DGX SuperPOD с системами DGX A100, позволяет быстро обучать модели DL в больших масштабах. Интегрированный подход к предоставлению ресурсов, управлению, вычислениям, работе в сети и быстрому хранилищу позволяет создать разнообразную многопользовательскую систему, которая может охватывать анализ данных, разработку моделей и выводы ИИ.

Устройства AI400X2 — это компактные платформы хранения данных с низким энергопотреблением, которые обеспечивают высокую производительность благодаря использованию дисков NVMe для хранения данных и InfiniBand или Ethernet (включая RoCE) в качестве сетевого транспорта. Каждое устройство полностью интегрирует параллельную файловую систему DDN EXAScaler, оптимизированную для AI- и HPC-приложений. EXAScaler основан на файловой системе Lustre с открытым исходным кодом и дополнен значительными улучшениями производительности, управляемости и надежности. Несколько устройств могут быть объединены в одну файловую систему для создания очень больших пространств имен.

Общие параллельные файловые системы, такие как файловая система EXAScaler, упрощают доступ к данным и поддерживают дополнительные варианты использования, когда для эффективного обучения требуются быстрые данные, а локального кэширования недостаточно. Благодаря высокой производительности однопоточного и многопоточного чтения их можно использовать для:

– обучения, когда наборы данных не могут быть кэшированы локально в системной памяти DGX A100 или на RAID-массиве DGX A100 NVMe;

– быстрой передаче данных на локальный диск;

– обучения с большими отдельными объектами данных (например, несжатыми или большими сжатыми изображениями без потерь точности);

– обучения с использованием оптимизированных форматов данных, таких как TFRecord и RecordIO;

– рабочей области для долговременного хранения (LTS, long term storage) наборов данных;

– централизованного хранилища для сбора, обработки и обмена результатами с помощью стандартных протоколов, таких как NFS, SMB и S3.

Оценка DDN® AI400X2 на пригодность поддержания рабочих нагрузок DL при подключении к DGX SuperPOD

Производительность обучения может быть ограничена скоростью, с которой данные могут считываться и пересчитываться из хранилища. Ключом к производительности является возможность многократного чтения данных, в идеале из локального хранилища. Чем ближе данные кэшируются к GPU, тем быстрее их можно прочитать. СХД необходимо проектировать с учетом иерархии различных технологий хранения, как постоянных, так и непостоянных, чтобы сбалансировать потребности в производительности, емкости и стоимости.

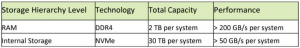

Иерархия кэширования системы DGX A100 показана в табл. 1. В зависимости от размера данных и требований к производительности каждый уровень иерархии может использоваться для максимизации производительности приложений.

Табл. 1. Иерархия системного хранилища и кэширования DGX A100.

Кэширование данных в локальной оперативной памяти обеспечивает наилучшую производительность чтения. Это кэширование прозрачно после чтения данных из файловой системы. Однако размер оперативной памяти ограничен 2,0 ТБ. На DGX A100 > 50 ГБ/с на системную систему, и эта емкость должна использоваться совместно с операционной системой, приложением и другими системными процессами. Локальное хранилище системы DGX A100 оснащено SSD-накопителем PCIe Gen 4 NVMe емкостью 30 ТБ. Хотя локальное хранилище работает быстро, управлять динамической средой только с помощью локального диска в многоузловой среде непрактично. Функционально централизованное хранилище может работать так же быстро, как и локальное хранилище, при многих рабочих нагрузках.

Требования к производительности высокоскоростного хранилища во многом зависят от типов используемых моделей искусственного интеллекта и форматов данных. DGX SuperPOD был разработан как система функционального класса, способная справиться с любой рабочей нагрузкой как сегодня, так и в будущем. Однако если системы собираются сосредоточиться на конкретной рабочей нагрузке, например, на обработке естественного языка, возможно, появится возможность лучше оценить потребности в производительности системы хранения.

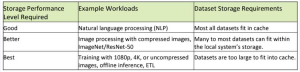

Чтобы клиенты могли охарактеризовать свои требования к производительности, в табл. 2 представлены некоторые общие рекомендации по общим рабочим нагрузкам и наборам данных.

Табл. 2. Характеристика различных рабочих нагрузок ввода-вывода.

В табл. 3 представлены оценки производительности системы хранения, необходимые для соответствия рекомендациям табл. 2. Для достижения этих характеристик производительности может потребоваться использование оптимизированных форматов файлов, TFRecord, RecordIO или HDF5.

Табл. 3. Рекомендации по желаемым характеристикам производительности хранилища

Высокоскоростное хранилище обеспечивает общее представление данных организации для всех систем. Его необходимо оптимизировать для небольших случайных шаблонов ввода-вывода и обеспечивать высокую пиковую производительность системы и высокую совокупную производительность файловой системы, чтобы соответствовать разнообразию рабочих нагрузок, с которыми может столкнуться организация.

DDN AI400X2

Устройство DDN AI400X2 соответствует вышеуказанным требованиям и предоставляет несколько функций, важных для максимизации производительности DGX SuperPOD и управления системой в центрах обработки данных.

Некоторые особенности устройства DDN AI400X2 включают в себя:

– устройство AI400X2 представляет собой масштабируемый строительный блок, который можно легко сгруппировать в единое пространство имен, которое легко масштабируется по емкости, производительности и возможностям. Оно полностью интегрировано, что упрощает развертывание и операции управления;

– устройство AI400X2 может быть настроено на несколько различных емкостей от 30 ТБ до 500 ТБ для NVMe и может быть расширено за счет диска емкостью до 5 ПБ для гибридной конфигурации. Несколько устройств могут быть объединены в одно пространство имен, которое обеспечивает до нескольких сотен петабайт полезной емкости;

– устройство AI400X2 взаимодействует с клиентами DGX SuperPOD, используя несколько сетевых подключений HDR200 InfiniBand или 200 GbE для обеспечения производительности, балансировки нагрузки и отказоустойчивости;

– встроенная поддержка InfiniBand – ключевая функция, позволяющая максимизировать производительность и минимизировать нагрузку на процессор. Поскольку вычислительная фабрика DGX SuperPOD представляет собой InfiniBand, разработка структуры хранения данных как InfiniBand означает, что необходимо управлять только одним типом высокоскоростной фабрики, что упрощает операции;

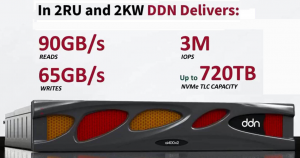

– общий параллельный протокол DDN позволяет одному клиенту DGX получить доступ ко всем возможностям одного устройства — более 90 ГБ/с и 3 млн IOPS. Несколько клиентов могут одновременно получать доступ к данным на устройстве, при этом производительность доступна для всех систем и распределяется динамически. Клиенты могут быть оптимизированы для рабочих нагрузок со сверхнизкой задержкой;

– полностью NVME-архитектура устройства AI400X2 обеспечивает высокую производительность произвольного чтения, зачастую такую же быструю, как и шаблоны последовательного чтения;

– устройство DDN AI400X2 отличается экономным пространством и энергопотреблением, высокой производительностью и емкостью, что обеспечивает оптимальное использование центра обработки данных и лучшую экономическую эффективность эксплуатации.

Методика и результаты валидации

Для оценки конкретной технологии хранения и конфигурации для использования с DGX SuperPOD используются три класса проверочных тестов: производительность микробенчмарка, реальная производительность приложения и функциональное тестирование. Микротесты измеряют ключевые шаблоны ввода-вывода для обучения DL и созданы таким образом, чтобы их можно было запускать только на узлах с ЦП. Это снижает потребность в больших системах на базе GPU только для проверки хранилища. Реальные обучающие приложения DL затем запускаются на DGX SuperPOD, чтобы подтвердить, что приложения соответствуют ожидаемой производительности. Помимо производительности, решения для хранения данных проверяются на надежность и отказоустойчивость в рамках функционального теста.

Процесс проверки хранилища NVIDIA DGX SuperPOD использует методологию «прошел или не прошел». Для микробенчмарка установлены конкретные цели. Каждый результат теста оценивается как хороший, удовлетворительный или плохой. Проходной балл – это такой балл, при котором по крайней мере 80% тестов являются хорошими и ни один из них не является плохим. Кроме того, во время тестирования не должно возникнуть катастрофических проблем. Для тестирования приложений проходным баллом считается тот, при котором все случаи выполняются в пределах 5% от производительности линии “крыши”, установленной при выполнении тех же тестов с данными, хранящимися на RAID-массиве DGX A100. При функциональном тестировании проходным баллом считается тот, при котором все функциональные тесты соответствуют ожидаемым результатам.

Микробенчмарки

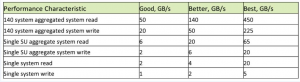

В табл. 3 перечислены несколько показателей производительности высокого уровня, которым должны соответствовать системы хранения, чтобы квалифицироваться как решение DGX SuperPOD. Текущее тестирование требует, чтобы решение соответствовало критериям «Лучшего», приведенным в таблице. В дополнение к этим метрикам высокого уровня проводится несколько групп тестов для проверки общих возможностей предлагаемых решений. К ним относятся тесты с одним узлом, где количество потоков варьируется, и тесты с несколькими узлами, где используется один счетчик потоков и количество узлов варьируется. Кроме того, каждый тест выполняется как в буферном режиме, так и в режиме DirectIO, а также когда ввод-вывод выполняется для отдельных файлов или когда все потоки и узлы работают с одним и тем же файлом.

Запускаются четыре различных шаблона чтения. Первая операция чтения является последовательной, когда в кэше нет данных. Вторая операция чтения выполняется сразу после первой, чтобы проверить способность файловой системы кэшировать данные. Кэш очищается, а затем данные считываются снова, на этот раз случайным образом. Наконец, данные снова считываются случайным образом для проверки кэширования данных.

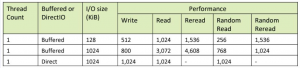

Был использован тест IOR (https://wiki.lustre.org/IOR) для одноузловых и многоузловых тестов.

Производительность в тесте Hero

Тест Hero помогает определить максимальную производительность всего решения. Параметры хранилища, такие как настройки файловой системы, размер ввода-вывода и управление привязкой ЦП, были настроены для достижения наилучшей производительности чтения и записи. Ожидалось, что устройства хранения продемонстрируют, что заявленная производительность близка к измеренной. В других тестах не каждый шаблон ввода-вывода (или какой-либо другой) способен достичь такого уровня производительности, но он обеспечивает понимание разницы между пиковой и достижимой производительностью интересующих шаблонов ввода-вывода.

Поставленное решение для одного SU должно было продемонстрировать более 20 GiB/s на запись и 65 GiB/s на чтение. В идеале производительность записи должна составлять не менее 50% от производительности чтения. Однако в некоторых архитектурах хранения разный баланс между производительностью чтения и записи, поэтому это всего лишь рекомендация, а производительность чтения более важна, чем скорость записи.

Производительность одного узла и нескольких файлов

Для производительности одного узла производительность операций ввода-вывода при чтении и записи измеряется путем постепенного изменения количества потоков. Каждый поток записывает (и читает) в свой файл (и из него) в том же каталоге.

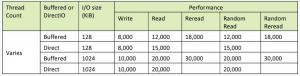

Для тестов производительности с одним узлом количество потоков варьируется от 1 до идеального количества потоков для максимизации производительности (обычно более половины ядер (64), но не более, чем общее количество физических ядер (128). Размер ввода-вывода варьируется от 128 КиБ до 1 МБ, а тесты проводятся с буферизованным вводом-выводом и прямым вводом-выводом. Целевые показатели этих испытаний показаны в табл. 4.

Табл. 4. Целевые показатели производительности для одного узла и нескольких файлов

При максимизации производительности одного узла количество потоков может варьироваться, однако ожидается, что производительность не упадет значительно, когда дополнительные потоки будут использоваться сверх оптимального количества потоков.

Целевая производительность для производительности одного узла с несколькими потоками указана в табл. 5. Оптимальное количество потоков может варьироваться для каждой конкретной конфигурации хранилища.

Табл. 5. Целевые показатели производительности для одноузловых многопоточных вычислений.

Производительность повторного чтения относительно производительности чтения может существенно различаться в зависимости от решения для хранения данных. Производительность повторного чтения должна составлять не менее 50 % от производительности чтения как для последовательного, так и для случайного чтения.

Многоузловая производительность при работе с несколькими файлами

Следующий выполняемый тест — это тест чтения и записи многоузлового ввода-вывода, чтобы убедиться, что устройство хранения может обеспечить минимально необходимый буферизованный чтение и запись на систему для DGX SuperPOD. Целью этого теста является проверка способности конкретной файловой системы масштабировать производительность различных шаблонов ввода-вывода. Производительность должна линейно масштабироваться от 1 до нескольких узлов, достигать максимальной производительности, а затем не снижаться значительно по мере добавления к заданию новых узлов.

Целевая производительность для одного SU из 20 узлов составляет 65 ГиБ/с для операций чтения с размером ввода-вывода 128 КБ или 1024 КБ, а также если ввод-вывод является прямым или буферизованным. Производительность записи должна составлять не менее 20 ГиБ/с, но в идеале она должна составлять 50 % от производительности чтения. Результаты этих исследований следует интерпретировать осторожно, поскольку для достижения этих уровней можно просто добавить больше оборудования. Целью является общая производительность, но желательно, чтобы производительность обеспечивалась эффективной архитектурой, которая не слишком спроектирована для ее использования.

I/O производительность одного файла

Ключевой шаблон ввода-вывода — чтение данных из одного файла. Зачастую самый быстрый способ чтения данных — это когда все данные организованы в один файл, например, в формате RecordIO. Зачастую это самый быстрый способ чтения данных, поскольку он исключает любые операции открытия и закрытия, необходимые, когда данные организованы в несколько больших файлов. Чтение одного файла является ключевым шаблоном ввода-вывода в конфигурациях DGX SuperPOD.

Целевая производительность и ожидаемое поведение ввода-вывода заключаются в том, что одноузловая многопоточная запись может успешно создать файл, что производительность последовательного и случайного чтения хорошая, а производительность чтения масштабируется по мере использования большего количества узлов. Многоузловые, многопоточные записи в один файл не тестируются. Кроме того, ожидается, что производительность буферизованного повторного чтения будет аналогична производительности повторного чтения нескольких файлов.

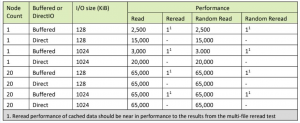

Целевая производительность для однофайлового ввода-вывода указана в табл. 6.

Табл. 6. Целевые показатели производительности при чтении отдельных файлов.

Тестирование приложений

Микробенчмарки позволяют оценить максимальную производительность ключевых показателей. Однако наиболее важна производительность приложений. Подмножество тестов MLPerf Training используется для проверки производительности и функционирования хранилища. Здесь тестируются как одноузловые, так и многоузловые конфигурации, чтобы убедиться, что файловая система может поддерживать различные шаблоны ввода-вывода и рабочие нагрузки. Производительность обучения, когда данные размещаются на RAID-массиве DGX A100, использовалась в качестве базового показателя производительности. Целью производительности является то, чтобы общее количество обучаемых данных, размещаемых в общей файловой системе, находилось в пределах 5 % от показателей, измеренных при размещении данных в локальном рейде. Это касается не только отдельных прогонов, но и когда несколько случаев выполняются на DGX SuperPOD одновременно.

ResNet-50

ResNet-50 — это эталон канонической классификации изображений. Размер набора данных превышает 100 ГиБ, и требуется быстрая обработка данных. В системе DGX A100 обучение одного узла требует примерно 3 ГиБ в секунду, а набор данных достаточно мал, чтобы поместиться в кеш. Предварительная обработка может различаться, но типичный размер изображения составляет примерно 128 КиБ. Одна из проблем этого теста заключается в том, что в NVIDIA обработанные изображения хранятся в формате RecordIO, который представляет собой один большой файл для всего набора данных, поскольку это обеспечивает наилучшую производительность для MLPerf. Поскольку это один файл, это может вызвать нагрузку на архитектуру общей файловой системы, которая не распределяет данные по нескольким целям или контроллерам.

Обработка естественного языка — BERT

BERT — это эталонная стандартная модель обработки естественного языка. В этом тесте система заполняется двумя заданиями по восемь узлов и четырьмя заданиями по одному узлу (или меньше, если не все 20 узлов SU доступны). Ожидается, что общее время обучения будет в пределах 5% от времени, измеренного при обучении в местном рейде. Этот тест не нагружает файловую систему, но проверяет, работает ли локальное кэширование должным образом.

Recommender–DLRM (Deep Learning Recommendation Model)

Рекомендательная модель имеет характеристики обучения, отличные от ResNet-50 и BERT, поскольку модель обучается менее чем за одну эпоху. Это означает, что набор данных считывается не более одного раза и локальное кэширование данных использовать нельзя. Для достижения полной производительности обучения DLRM должен иметь возможность считывать данные со скоростью более 6 ГиБ/с. Кроме того, программа чтения файлов использует DirectIO, который нагружает файловую систему иначе, чем два других файла. Данные форматируются в один файл.

Этот тест запускается только как тест одного узла; однако выполняется несколько тестов, в которых количество одновременных заданий варьируется от одного до общего количества доступных узлов. Ожидается, что общая файловая система будет поддерживать производительность только до пиковой производительности, измеренной в ходе главного теста. Для 20 одновременных случаев система хранения должна обеспечить устойчивую производительность чтения более 120 ГиБ/с, что больше, чем указано в табл. 3. Даже наилучшая производительность, указанная в этой таблице, не предназначена для поддержки всех возможных рабочих нагрузок. Он предназначен для обеспечения баланса высокой пропускной способности без чрезмерной архитектуры системы.

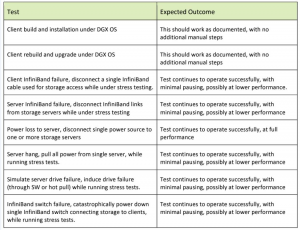

Функциональное тестирование

Помимо производительности, необходимо убедиться, что решение хранения данных соответствует требованиям интеграции DGX SuperPOD и рассчитано на максимальный уровень безотказной работы. Для проверки устойчивости решения оно подвергается нескольким тестам, чтобы гарантировать, что отказ одного компонента не приведет к прерыванию работы DGX SuperPOD. Испытания показаны в табл. 7.

Табл. 7. Функциональные тесты.

Тестирование показало, что устройство DDN AI400X2 соответствует требованиям к производительности и функциональности DGX SuperPOD. По мере роста требований к хранению данных можно добавлять устройства AI400X2 для плавного масштабирования емкости, производительности и возможностей.

Модельный ряд

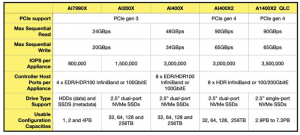

В настоящее время в линейке решений DDN A3I пять устройств (рис. 1б).

Рис. 1б. Семейство устройств DDN A3 I (https://blocksandfiles.com/2023/05/18/ddn-adds-qlc-ssd-ai-training-storage-system/).

Последняя модель – A1400X2 QLC – в линейке конструктивно отличается от предыдущей возможностью расширения QLC-модулями.

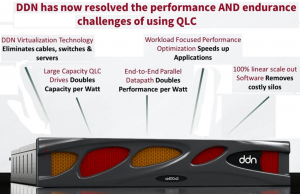

Добавление флэш-памяти QLC и сжатия к массиву A1400 X2 обеспечивает как лучшую производительность, так и действительно хорошую емкость флэш-памяти для клиентов. По словам Джеймса Кумера (James Coomer, старший вице-президент по продуктам DDN), “эта система может предоставить в 10 раз больше данных, чем конкурирующие системы, и использовать лишь часть их электрической энергии”. Она использует диски QLC емкостью 60 ТБ, что обеспечивает емкость 1,45 ПБ в корпусе 2RU x 24 слота, что вдвое увеличивает емкость на ватт по сравнению с SSD емкостью 30 ТБ, доступными от других поставщиков (https://blocksandfiles.com/2023/05/18/ddn-adds-qlc-ssd-ai-training-storage-system/).

A1400X2 QLC использует стандартный контроллер A1400X2 (storage compute node) в шасси высотой 2RU. Он оснащен твердотельным накопителем TLC емкостью 732 ТБ, а также многоядерным RAID-движком реального времени и контроллером, обеспечивающим производительность 3,5 млн IOPS и 95 ГБ/с. К нему могут быть добавлены два, четыре или пять лотков расширения SSD SP2420 QLC, связанных через NVMe/oF и Ethernet. Каждый лоток вмещает до 2,9 ПБ необработанной емкости QLC. Это 2,3 ПБ, которые после сжатия становятся эффективными 4,7 ПБ (рис. 1в).

Рис. 1в. DDN A1400X2 QLC (https://blocksandfiles.com/2023/05/18/ddn-adds-qlc-ssd-ai-training-storage-system/).

Максимальная эффективная емкость QLC составляет 11,7 ПБ в полностью сконфигурированной системе. DDN утверждает, что новый массив обеспечивает экономию до 80% по сравнению с массивом TLC сопоставимой емкости и позволяет приложениям работать быстрее, чем массив NFS. Добавленное сжатие на стороне клиента использует циклы ЦП массива, но, поскольку результирующий набор данных меньше, общая производительность чтения и записи примерно одинакова.

В DDN утверждают, что ее QLC-версия A1400X2 имеет более выгодную цену за терабайт флэш-памяти, чем существующая версия TLC, которая обеспечивает лучшее количество операций ввода-вывода в секунду (до 70 млн) и пропускную способность на стойку. Гибридная флэш-дисковая система TLC предлагает еще более низкую цену за ТБ. В компании говорят, что могут удовлетворить бюджеты систем хранения данных с использованием искусственного интеллекта в центрах обработки данных на трех уровнях: оптимизация по чистой производительности, по соотношению цена/производительность или по снижению затрат (https://blocksandfiles.com/2023/05/18/ddn-adds-qlc-ssd-ai-training-storage-system/).

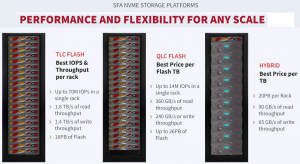

“Cтарые” флеш-системы DDN, полностью основанные на TLC, обеспечивают наилучшие показатели операций ввода-вывода в секунду и пропускной способности на стойку: до 70 млн IOPS в одной стойке. Гибридное решение с флэш-памятью TLC и традиционными дисками предлагает лучшую цену за ТБ — 20 ПБ на стойку. Новая флэш-система QLC обеспечивает лучшую цену за терабайт флэш-памяти с производительностью до 14 млн IOPS в одной стойке и высокой плотностью хранения данных (рис. 1г).

Рис. 1г. Семейство SFA NVME STORAGE PLATFORMS (https://www.ddn.com/products/sfa-nvme-storage-platforms/).

Диапазон систем DDN AI400X2 QLC варьируется от 2,9 ПБ до 7,3 ТБ, а эффективная емкость — от 4,7 ПБ до 11,7 ПБ при консервативной степени сжатия 2x. DDN намерена начать поставки своих решений на базе QLC в 3-м кв. 2023 года.

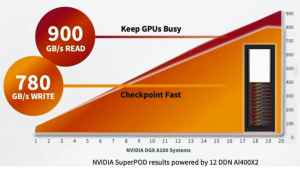

По заявлениям DDN, имеется линейное масштабирование до скорости чтения 900 ГБ/с из хранилища емкостью 24RU – 12 устройств A1400X2 со скоростью 90 ГБ/с на устройство. Эти 12 устройств также обеспечивают скорость записи 780 ГБ/с. В DDN утверждают, что при работе с большими языковыми моделями вычисления перекрывают передачу данных, а более быстрая передача означает, что вычисления выполняются быстрее (https://blocksandfiles.com/2023/06/13/ddn-getting-massive-second-wave-ai-boost-to-storage-revenues/).

DDN обеспечивает гибкость в выборе платформы, предлагая или all-flash-решение NVMe AI400X2, или гибридную платформу с SSD и HDD дисками, которая использует параллельный доступ к флэш-памяти и жестким дискам. AI400X2 поддерживает горизонтально масштабируемую модель с решениями размером от нескольких ТБ, но с возможностью масштабирования до 10 ПБ.

DDN AI200X — это флэш-устройство, полностью использующее NVMe, оптимизированное для AI. Двойные активные контроллеры обеспечивают скорость до 24 ГБ/с и 1,5 млн IOPS через четыре порта EDR/HDR100 IB или 100GbE. DDN AI200X — это выбор для развертывания вычислительных устройств с одним GPU и легко масштабируется в соответствии с любыми требованиями к емкости и производительности. AI200X доступен в вариантах емкостью 32 ТБ, 64 ТБ, 128 ТБ и 256 ТБ.

DDN AI400X — это флэш-устройство, полностью выполненное на NVMe, которое обеспечивает максимальную производительность для рабочих процессов искусственного интеллекта в любом масштабе. Двойные активные контроллеры обеспечивают скорость до 48 ГБ/с и 3 млн IOPS через восемь портов EDR/HDR100 IB или 100GbE. DDN AI400X позволяет запускать рабочие нагрузки со всеми данными в любом месте и ускорять самые требовательные рабочие процессы и приложения. AI400X доступен в вариантах емкостью 32 ТБ, 64 ТБ, 128 ТБ и 256 ТБ.

DDN AI7990X — это гибридное устройство хранения данных, обеспечивающее максимальную гибкость, которое позволяет сочетать высокопроизводительные флэш-накопители и диски большой емкости в системе высокой плотности. Двойные активные контроллеры в устройстве AI7990X обеспечивают клиентам скорость до 24 ГБ/с и 800 тыс. IOPS через четыре порта EDR/HDR100 IB или 100GbE. AI7990X доступен с емкостью 1 ПБ, 2 ПБ и 4 ПБ.

Полностью интегрированные платформы данных, оптимизированные для GPU

Решения A3I просты в развертывании, готовы к использованию, предварительно настроены и представляют собой наиболее эффективную масштабируемую платформу с точки зрения емкости и производительности.

Полное насыщение GPU

Решения A3I полностью оптимизированы для всех типов шаблонов ввода-вывода и структуры данных и доставляют данные в приложения, обеспечивая полное использование ресурсов GPU даже при распределенных приложениях, работающих на нескольких вычислительных серверах. Тестирование производительности архитектуры DDN A3I проводилось со всеми широко используемыми платформами DL (TensorFlow, Horovod, Torch, PyTorch, NVIDIA® TensorRT™, Caffe, Caffe2, CNTK, MXNET и Theano). Используя интеллектуальный клиент A3I, контейнерные приложения могут задействовать все возможности инфраструктуры данных, а серверы искусственного интеллекта последовательно достигают полной загрузки графического процессора для рабочих нагрузок DL.

Эффективное хранилище данных с искусственным интеллектом

Решения A3I предоставляют гибкие возможности расширения емкости: до 500 ТБ масштабируемой емкости NVMe на каждое устройство AI400X2.

Высокая отказоустойчивость, надежность и безопасность в любом масштабе

Все аппаратные и программные компоненты A3I, разработанные для обеспечения высочайшей доступности данных и максимального времени безотказной работы системы, интегрированы в систему с полным резервированием.

Единое пространство имен

Решения A3I позволяют консолидировать данные горячего (hot) обучения и расширяемые библиотеки данных на единой платформе, обеспечивая легкий доступ к данным через унифицированный интерфейс.

Поддержка мультитенантности и квот

Решения A3I могут быть защищены для каждого арендатора, что гарантирует пользователям и приложениям доступ только к тем данным, на которые у них есть право. Расширенные средства управления квотами обеспечивают простое управление использованием файловой системы на уровне пользователя, группы и проекта.

Технические характеристики:

– высокопроизводительная параллельная файловая система, оптимизированная для графического процессора;

– скорость последовательного чтения до 90 ГБ/с;

– скорость последовательной записи до 65 ГБ/с;

– до 3 млн IOPS на устройство;

– хост-порты контроллера на устройство – 8 портов 200G HDR InfiniBand или 200 GbE;

– поддержка дисков: 2,5-дюймовые двухпортовые накопители NVMe; конфигурации полезной емкости 30 ТБ, 60 ТБ, 120 ТБ, 250 ТБ, 500 ТБ;

– стандартные функции ПО: высокопроизводительная параллельная файловая система, сопоставление и маскирование LUN, интеллектуальное чередование записи, качество обслуживания чтения, обнаружение зонирования портов, проверка/исправление целостности данных, параметры интерфейса (SSH для CLI, веб-интерфейс, Python API), сообщения об изменении состояния (через e-mail, SNMP-ловушка и системный журнал);

– безопасность: сертификаты агентства Ul, cUl, CE, FC.

DDN SFA200X2/SFA400X2/SFA18KX/SFA18KXE/SFA7990X

DDN SFA200X2/SFA400X2

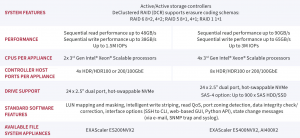

Устройства DDN Storage Fusion Architecture® (SFA®) SFA200X2/SFA400X2 созданы для обеспечения масштабируемой производительности и емкости флэш-накопителей для гибкого удовлетворения меняющихся потребностей бизнеса (https://www.ddn.com/products/sfa-nvme-storage-platforms/). В НРС-решениях они используются для хранения метаданных.

Платформы SFA NVMe поддерживают 100% хранилище NVMe с множеством вариантов высокоскоростного подключения.

Решения 2U SFA NVMe-only/Hybrid со скоростью до 90 ГБ/с являются самыми быстрыми решениями для хранения данных в отрасли и способны поддерживать до 24 NVMe SSD в минимальном форм-факторе. Построенные на 3-м поколении Gen Intel® Xeon® Scalable процессоров платформы SFA NVMe с экстремальным уровнем плотности производительности, хорошо подходят для центров обработки данных с ограниченным пространством, где требуется надежная высокопроизводительная флэш-память в масштабируемой архитектуре. Можно начать с одного корпуса и безгранично масштабируйте его в соответствии с требованиями файловой системы или блока.

Гибридные конфигурации масштабируются до 24 устройств NVMe плюс 900 устройств SAS (вращающихся дисков или SSD).

Производительность, масштабируемая по требованию

Независимо от того, ускоряете ли вы аналитическую рабочую нагрузку, сокращаете задержки при работе с тяжелыми (tough) базами данных NoSQL или начинаете проект глубокого обучения со скромными обучающими наборами, платформы SFA NVMe хорошо подходят в качестве экономичных строительных блоков. Платформа, разработанная для того, чтобы помочь получить максимальную отдачу от инвестиций, имеет внутреннюю коммутационную фабрику с до 288 линиями PCle Gen 4, а также до 64 линий, обеспечивающих подключение клиентов. SFA400NVX2 может добавить 16 портов x4 (64 канала) для подключения SAS-4, обеспечивая возможность гибридного расширения.

Небольшая, но мощная гибкость

Платформы SFA NVMe доступны в виде блочных устройств хранения и интегрированных высокопроизводительных файловых устройств. Файловая система DDN EXAScaler® позволяет использовать блочные хранилища SFA NVMe для горизонтального масштабирования пространства имен с максимальной эффективностью. Эти устройства обеспечивают максимальную производительность приложений и рабочих нагрузок за счет сочетания преимуществ DDN SFAOS с ведущей в отрасли параллельной файловой системой EXAScaler® (рис. 2).

Рис. 2. Технические характеристики моделей DDN SFA200X2/SFA400X2 (https://www.ddn.com/products/sfa-nvme-storage-platforms/).

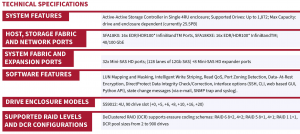

DDN SFA18KX/SFA18KXE

SFA18KX — это самая высокопроизводительная блочная система хранения данных и гиперконвергентная платформа (https://www.ddn.com/products/converged-storage-platform-sfa18kx/).

Строительные блоки SFA18KX начинаются с сотен терабайт и масштабируются до более чем 25 петабайт с производительностью до 3,2 млн IOPS и 90GB/s в 4U корпусе. Архитектура SFA18KX построена на базе высокооптимизированной PCIe-фабрики и 12Gb back-end SAS-фабрики.

Декластеризованный RAID SFA (DCR, DeСlustered RAID) значительно повышает производительность восстановления за счет увеличения пула дисков, которые участвуют в резервной группе, позволяя читать и записывать количество членов RAID, во много раз превышающее количество участников RAID (например, 10 дисков в 8+2).

DCR позволяет распределять данные по гораздо большему набору физических дисков, чем это было ранее доступно в традиционном RAID, и значительно увеличивает параллелизм восстановления дисков. Именно этот параллельный процесс позволяет выполнять восстановление намного быстрее, чем традиционный RAID. Помимо сокращения времени восстановления, DCR также может привести к повышению эффективности хранилища и производительности операций ввода-вывода в секунду.

Технические характеристики устройств линейки DDN SFA18KX/SFA18KXE представлены на рис. 2а (https://www.ddn.com/products/converged-storage-platform-sfa18kx/).

Рис. 2а. Технические характеристики устройств линейки DDN SFA18KX/ SFA18KXE (https://www.ddn.com/products/converged-storage-platform-sfa18kx/).

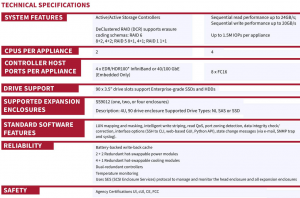

DDN SFA7990X

SFA7990X обеспечивает ведущие в отрасли инновации и возможности интенсивного использования данных как для блочного, так и для файлового хранения в любом масштабе. Масштабировать SFA7990X можно с нескольких терабайт и до петабайт для обслуживания самых требовательных задач смешанной рабочей нагрузки.

SFA7990X, созданный на базе процессоров 2nd Gen Intel® Xeon® Scalable, отвечает самым интенсивным требованиям приложений искусственного интеллекта и глубокого обучения, включая поддержку долгосрочного хранения больших объемов данных, к которым редко обращаются. Технические характеристики DDN SFA7990X – рис. 2б.

Рис. 2б. Технические характеристики DDN SFA7990X (https://www.ddn.com/products/sfa7990x-hybrid-flash-storage-appliance/).

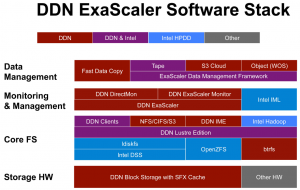

Продуктовое семейство EXAScaler

Продуктовое семейство EXAScaler это: параллельная файловая система EXA6.1 и ее клиенты на серверах, а также специализированные аппоайнсы, которые поддерживают встроенные серверы метаданных на устройствах DDN SFA или на внешних масштабируемых серверах метаданных с использованием Lustre DNE. Программный стек DDN ExaScaler представлен на рис. 2в. Аргументации в пользу выбора BtrFS следующая:

– стандартная локальная файловая система в RHEL7;

– более высокая пропускная способность, чем у ZFS;

– аналогичный набор функций, но все Linux;

– отсутствие возможного нарушения патентных прав;

– простая интеграция и развертывание.

Рис. 2в. DDN ExaScaler Software Stack (LUG2015, https://wiki.lustre.org/images/9/9b/LUG-Presentation-Final_Triendl.pdf).

Искусственный интеллект (ИИ), аналитика и высокопроизводительные вычисления (HPC) позволяют организациям по всему миру получать ценную информацию из своих данных с беспрецедентной скоростью и точностью. Рабочие процессы с интенсивным использованием данных ставят инфраструктуру хранения данных на критически важный путь, что приводит к возникновению требований к экстремальной, надежной производительности, которая легко масштабируется для удовлетворения растущих требований рабочих нагрузок локально и в облаке (https://www.ddn.com/download/ddn-exascaler-data-sheet/).

Искусственный интеллект (ИИ)

Новые варианты использования ИИ стимулируют стратегии управления данными, ориентированные на рост. Там, где традиционные архитектуры хранения терпят неудачу, EXA6 оптимизирован для решения проблем производительности, масштабирования и мобильности данных с простотой и надежностью.

От данных, собранных на периферии, до основных репозиториев и управления мультиоблачными стратегиями, EXA5 обеспечивает повышенную производительность для специалистов по обработке данных и лидеров инициатив в области искусственного интеллекта.

Высокопроизводительные вычисления (HPC)

Ученые и инженеры постоянно ищут новые способы более быстрого решения сложных проблем. Рабочие нагрузки высокопроизводительных вычислений, такие как физическое моделирование, обнаружение нефти и газа и геномика, обрабатывают огромные объемы данных, к которым одновременно обращаются несколько систем.

EXA6 — это стандарт для рабочих нагрузок HPC: он использует файловую систему Lustre для создания масштабируемой общей параллельной архитектуры, обеспечивающей быструю доставку данных на крупномасштабные вычислительные мощности по всему миру, ускоряя получение результатов для всех.

EXA6 – это новое поколение параллельной файловой системы на основе Lustre со следующими основными особенностями:

– поддержка глобальной платформы данных (локально и в облаках);

– простая масштабируемость;

– поддержка высокой производительности;

– поддержка самой высокой плотности данных;

– поддержка гибкой архитектуры;

– глубокая интеграция с GPU.

EXA6: параллельная файловая система с расширенными возможностями

Разработанная и оптимизированная с использованием последних достижений в области ПО для файловых систем, EXA6 обеспечивает высочайшую производительность, масштабируемость, возможности, надежность и простоту.

EXA6, дополненная множеством функций, представляет собой настоящую глобальную платформу данных, способную обеспечить и ускорить широкий спектр рабочих процессов с интенсивным использованием данных в любом масштабе. Полностью интегрированные устройства DDN EXAScaler сочетают в себе самую быструю в мире гиперконвергентную платформу хранения данных с по-настоящему параллельным программным обеспечением файловой системы в пакете, который легко развертывается, управляется и поддерживается лидерами в области масштабируемых данных.

EXA6 полностью оптимизирована для доставки данных с высокой пропускной способностью, низкой задержкой и массовым параллелизмом с использованием общей параллельной архитектуры, которая может гибко масштабироваться, обеспечивая впечатляющую производительность и экономические преимущества. Основываясь на более чем десятилетнем опыте развертывания решений для параллельных файловых систем в самых требовательных средах по всему миру, DDN обеспечивает высокую производительность, возможности и гибкость для пользователей, желающих управлять огромными объемами данных и получать ценную информацию.

Автоматизированное, оптимизированное и безопасное управление данными

EXAScaler включает новые функции управления данными и обеспечения целостности файловой системы, разработанные DDN и доступные только в ее устройствах и облачных предложениях. Stratagem — это мощный механизм оркестрации данных, который предоставляет пользователям комплексный контроль над размещением данных с использованием размещения на основе политик (рис. 3).

Рис. 3. Stratagem обеспечивает быстрое и эффективное управление данными.

Функция «горячих узлов» еще больше ускоряет доступ к данным за счет автоматического кэширования данных на локальном NVMe систем графических процессоров, сокращения задержек ввода-вывода и трафика за счет исключения сетевых циклов и высвобождения инфраструктуры для обслуживания дополнительных рабочих нагрузок.

Реализация Hot Pools дает возможность интеллектуального перемещения данных между высокопроизводительной флэш-памятью и дисками большой емкости, что обеспечивает эффективное использование хранилища. Собственная реализация T10DIF гарантирует полную целостность обработки данных от приложения до диска.

EXAScaler позволяет организациям по всему миру создавать, анализировать и управлять большим количеством данных, чем когда-либо прежде, ускоряя время получения аналитической информации и обеспечивая непревзойденную производительность для самых требовательных рабочих нагрузок локально и в облаке.

Среди основных функциональных особенностей EXA6 следующие:

– EMBEDDED/CONVERGED: обеспечение самой низкой совокупной стоимости владения с помощью простых и эффективных устройств EXAScaler;

– встроенные средства развертывания: упрощение внедрения EXAScaler с помощью инструментов миграции данных и настройки;

– стратегема EXASCALER: оптимизация управления и оркестрации данных с помощью этого инструмента интеграции данных на основе политик и API;

– снимки: защита важных данных с помощью эффективных глобальных снимков;

– шифрование: обеспечение безопасности данных с помощью шифрования во время передачи и хранения;

– целостность данных (DATA INTEGRITY): прозрачное обеспечение точности и согласованности данных посредством сквозной проверки;

– аудит: соблюдение законодательных и нормативных требований с полной картиной того, кто и когда внес изменения;

– квоты: обеспечение контроля над файловой системой с помощью квот использования, проектов и каталогов;

– оптимизация для ИИ: возможность быстрого развертывания новых приложений ИИ и глубокого обучения благодаря полной совместимости с общими платформами и интеграции с GPU;

– гибкие протоколы: обеспечение средств приема и доступа к данным со стандартными файловыми и объектными протоколами;

– аналитика рабочей нагрузки: получение глубокого понимания использования файловой системы и оборудования, а также отслеживание производительности на уровне узлов и заданий;

– горячие узлы: автоматическое кэширование данных на локальном NVMe системая GPU, что уменьшает задержку ввода-вывода и трафик и освобождает инфраструктуру для обслуживания дополнительных рабочих нагрузок, таких как ingest, labelling и archive;

– горячие пулы: оптимизация использования флэш-памяти и долгосрочного хранения данных с помощью автоматизированных политик и перемещения данных на основе API;

– поддержка контейнеров: возможность получения высокопроизводительного параллельного доступа для контейнерных приложений;

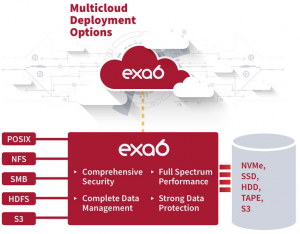

– готовность к мультиоблачности: возможность развертывания одной архитектуры управления данными локально и в коммерческих облаках с собственным облачным развертыванием (рис. 4);

Рис. 4. Поддержка мульоблачности в DDN EXAScaler.

– миграция и синхронизация: возможность защищать, перемещать и делиться данными, а также упрощать рабочие нагрузки MultiCloud с помощью интегрированных инструментов перемещения данных;

– мультиарендность (multitenancy): обеспечение безопасного изолированного доступа к данным для нескольких пользователей или организаций;

– ускорение приложений: обеспечение максимальной пропускной способности и производительности операций ввода-вывода в секунду с минимальной задержкой с помощью клиента EXAScaler;

– глубокая интеграция GPU: снижение времени выполнения приложений за счет наиболее эффективного пути передачи данных благодаря поддержке технологии NVIDIA GPUDirect.

Технические характеристики устройств линейки EXAScaler представлены на рис. 5.

Рис. 5. Технические характеристики устройств с поддержкой EXAScaler.

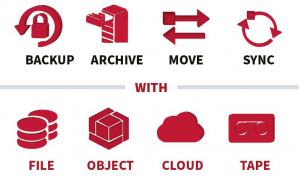

DDN DataFlow

DDN DataFlow — это комплексное программное решение, которое позволяет клиентам проектировать, развертывать и управлять высокопроизводительными рабочими процессами обработки данных в любом масштабе. Это быстрая, гибкая и надежная платформа данных, которую можно легко масштабировать для удовлетворения даже самых требовательных требований проекта. DDN DataFlow защищает критически важную информацию, обеспечивает долгосрочное хранение ценных активов в организованном репозитории и предоставляет распределенные многопоточные возможности для быстрых операций с данными. Он также предлагает мощные решения для синхронизации файлов — даже на гетерогенных платформах хранения и в удаленных местах.

DDN DataFlow легко интегрируется с системами хранения DDN, а также с большинством файловых, объектных, облачных и ленточных платформ данных. Обширная совместимость DDN DataFlow обеспечивает рабочие процессы с несколькими источниками и несколькими пунктами назначения с практически безграничными возможностями (рис. 5а).

Рис. 5а. DDN DataFlow интегрируется с системами хранения DDN, а также с большинством файловых, объектных, облачных и ленточных платформ данных (https://www.ddn.com/products/dataflow-backup-archive-data-migration/).

Модуль параллельных данных

Благодаря DDN DataFlow каждая задача выполняется с помощью многопоточных средств перемещения данных и управляется интеллектуальным планировщиком заданий для быстрой, эффективной и надежной работы системы. Распределенная архитектура обеспечивает потрясающую производительность, масштабируемость и гибкость, что делает DDN DataFlow мощным и простым в интеграции в любую инфраструктуру.

Быстрая идентификация новых и измененных данных

Запатентованная технология параллельного сканирования файловой системы FastScan быстро и эффективно проверяет содержимое систем хранения для быстрого и эффективного управления данными.

Простой интуитивный интерфейс

Консоли DDN DataFlow с графическим интерфейсом охватывают все административные и эксплуатационные функции. Они предоставляют обширные и мощные возможности каждому пользователю и позволяют осуществлять самообслуживание даже неспециалистам. Также доступны комплексные интерфейсы командной строки и API для интеграции и автоматизации конвейеров.

Проверка целостности данных на каждом шаге

Расширенные функции контрольной суммы вычисляются средствами перемещения данных для каждого файла во время каждой операции. Автоматические средства проверки целостности обеспечивают точность всех данных и позволяют по требованию проверять целостность архивного хранилища. DDN DataFlow поддерживает несколько схем контрольных сумм с использованием как открытых, так и собственных стандартов.

Контроль безопасности и соответствия

Доверенная структура управляет доступом пользователей и обеспечивает соответствующее разделение информации на основе политики и классификации. DDN DataFlow интегрируется со службами каталогов для аутентификации пользователей и управления правами, а также с внешними платформами мониторинга.

Полная защита данных

DDN DataFlow защищает важную информацию и гарантирует, что она останется доступной в случае непредвиденного события. Решение упрощает настройку, управление и мониторинг рабочих процессов защиты данных с помощью простой централизованной консоли администрирования. Высокопроизводительная масштабируемая архитектура гарантирует соблюдение каждого окна резервного копирования и обеспечивает надежное аварийное восстановление (DR) для непрерывности бизнеса в любом масштабе.

DDN DataFlow позволяет легко и гибко получать данные. Его уникальная консоль на основе временной шкалы позволяет пользователям быстро находить и восстанавливать отдельные файлы в любой момент времени и с любого уровня хранилища с высокой степенью уверенности.

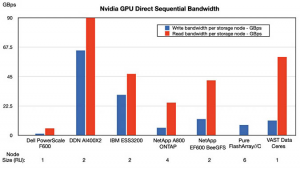

Оценка пропускной способности GPUDirect

GPUDirect Storage (GDS) – это NVMe- и CPU-bypass протокол, позволяющий системам хранения отправлять данные на SuperPod и другие графические серверы Nvidia напрямую. При чтении в традиционном хранилище процессор сервера копирует данные из своего ресурса хранения, DAS, SAN или NAS, в буфер памяти, а затем записывает их на устройство сетевого интерфейса для дальнейшей передачи. Данные как бы перескакивают из хранилища в буфер памяти, прежде чем отправиться к месту назначения. Входящие данные (запись) следуют по тому же маршруту в обратном порядке. GDS отсекает этот этап буфера возврата и отправляет его напрямую из хранилища в память целевой системы графического процессора [6].

GDS поддерживают Dell, DDN, IBM, NetApp (ONTAP и E-Series BeeGFS), Pure Storage, VAST Data и WekaIO.

GPUDirect — не единственный метод передачи данных между графическими процессорами NVIDIA и системами хранения, но он считается самым быстрым.

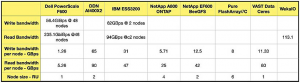

Были сопоставлены все показатели пропускной способности общедоступных узлов хранения с последовательным чтением и записью, которые удалось найти для систем данных Dell, DDN, IBM, NetApp, Pure и VAST Data при передаче данных на серверы Nvidia GPU и обратно с помощью GPUDirect.

Для WekaIO удалось найти только результат пропускной способности последовательного чтения 113,1 ГБ/с для ее горизонтально масштабируемой и параллельной файловой системы. Но это был совокупный результат работы кластера серверов, использующих файловую систему Weka. Ни количество серверов, ни их физический размер не были раскрыты, поэтому не удалось получить данные о пропускной способности каждого узла. Также не удалось найти никаких показателей пропускной способности записи, поэтому таблица результатов, представленная на рис. 7. На рис. 7 также нет показателя полосы пропускания чтения Pure FlashArray//C, поскольку его не удалось найти.

Результаты по общей пропускной способности чтения на узел показали, что DDN находится на первом месте, VAST на втором месте, IBM ESS3200 на третьем, NetApp E series на четвертом месте, ONTAP на пятом месте и Dell на последнем месте (рис. 6).

Рис. 6. Пропускная способность при использовании GPUDirect различных СХД [6].

Результаты по пропускной способности записи были разными: на первом месте DDN, на втором месте IBM, на третьем NetApp E series, на четвертом VAST, на пятом Pure, на шестом NetApp ONTAP и на седьмом месте Dell (см. рис. 7).

Следует отметить, что узлам хранения VAST необходимы вычислительные узлы, а строка размера узла в нижней части диаграммы предназначена только для узла хранения VAST Ceres.

Значения PowerScale были получены на основе общедоступных показателей Dell PowerScale F600 GiBps (https://www.delltechnologies.com/asset/en-us/products/storage/industry-market/h18931-dell-emc-powerscale-and-nvidia-gpudirect.pdf) для 48-узловой системы GPUDirect. Из них было рассчитано количество узлов.

История развития и архитектурные особенности DDN-решений

Особенности AI-приложений [7]

Для эффективного управления AI-данными их жизненный цикл требует четкого и непрерывного потока как для обучения AI-моделей, так и для применения AI-моделей для принятия решений в реальном времени.

AI включает в себя несколько различных этапов: от приема данных до обучения модели, вывода и многого другого. Каждый этап может стать узким местом в процессе, замедляя время создания новых моделей или получения новых идей. Все более разрозненные источники данных и сложность моделей увеличивают узкие места конвейера, поэтому неудивительно, что многие AI-проекты занимают слишком много времени, превышают рамки бюджета или не доходят до производства.

Управление AI-данными на протяжении всего жизненного цикла данных и возможности AI-хранилищ имеют решающее значение для повышения эффективности AI-систем. Модельно-ориентированный подход к AI может выиграть от увеличения количества обучающих данных и повышения качества и разнообразия данных, используемых для обучения, поэтому создание ориентированного на данные конвейера для управления сквозным жизненным циклом данных имеет решающее значение.

Жизненный цикл AI-данных

Системы искусственного интеллекта ориентированы на данные, и каждому приложению может потребоваться уникальный рабочий процесс управления данными для удовлетворения бизнес-требований на нескольких этапах. На разных этапах различаются типы данных, потребности в пропускной способности и уровень поддержки различных режимов соответствия. Типичный путь передачи данных в одном проекте ИИ может включать следующее:

– прием данных – сбор необработанных данных, таких как изображения или данные временных рядов, которые используются для создания и уточнения модели или в качестве входных данных для процесса принятия решений. Также может потребоваться некоторая восходящая фильтрация или буферизация для управления процессом приема;

– подготовка данных. Перед обработкой необработанные данные необходимо очистить или подготовить. Например, данные обучения необходимо соответствующим образом классифицировать и помечать, а данные в реальном времени необходимо фильтровать или нормализовать перед вводом в модель;

– обучение и обучение с подкреплением (Training and Reinforcement Learning). Создание сложной модели ИИ может занять значительное время (скажем, недели или больше), поскольку предварительно подготовленные данные обучения необходимо загружать, многократно повторять и проверять на соответствие известным правильным данным;

– выводы и рекомендации. Данные в реальном времени определяют рекомендации или решения после проверки модели. Также может существовать цикл обратной связи для настройки модели на новые данные посредством обучения с подкреплением;

– архив данных. Правила аудита данных и соответствия требованиям могут требовать регистрации каждого решения ИИ вместе с входными данными и информацией о модели. Например, системе распознавания изображений потребуется зарегистрировать исходное изображение в дополнение к рекомендациям ИИ, чтобы предоставить документальное подтверждение того, как было принято решение.

Каждый из этих этапов конвейера имеет уникальный набор требований к производительности, пропускной способности и задержке — и каждый из них может представлять собой потенциальное узкое место в конвейере ИИ, задерживая доставку данных для следующего этапа процесса. Распространенной ошибкой является рассмотрение каждого этапа как отдельного бункера, оптимизированного с учетом характеристик этого этапа. Однако при этом часто упускается из виду наиболее распространенная проблема, стоящая перед каждым этапом, — необходимость непрерывного и бесперебойного потока данных по конвейеру. Без такого сквозного подхода отдельные хранилища, как правило, работают в пакетном режиме, без непрерывности и частых задержек данных, что не позволяет обеспечить эффективный и беспрепятственный переход данных от одного этапа к другому и далее.

Системы поддержки для рабочих нагрузок ИИ

Масштабируемые и высокопроизводительные файловые службы необходимы для большинства рабочих нагрузок ИИ, но также необходима поддержка и других рабочих нагрузок. По мере того, как организации совершенствуют свои процессы разработки и начинают внедрять ИИ во все больше областей бизнеса, некоторые вспомогательные системы становятся все более важными. Кроме того, эволюция сред искусственного интеллекта предъявляет дополнительные требования к хранению данных для управления данными искусственного интеллекта, такие как:

– домашние каталоги. Специалистам по данным и разработчикам нужны домашние каталоги для хранения рабочих документов, включая отчеты, спецификации и программные сценарии. Обычно это интерактивные рабочие нагрузки, поддерживающие повседневные операции и сотрудничество;

– контейнеры. Виртуализированные и контейнерные технологии идеально подходят для поддержки современных динамических сред, особенно когда группа разработчиков запускает новые приложения или выполняет аналитику для прототипов приложений. Системы хранения, оптимизированные для виртуальных машин и контейнерных технологий, могут обеспечить большую гибкость, производительность и безопасность, чем традиционные ИТ-системы хранения;

– базы данных. Базы данных могут поддерживать интерактивные и встроенные системы для различных рабочих нагрузок, включая этапы маркировки данных и подготовки к обучению модели ИИ. Системы хранения, оптимизированные для БД, также могут помочь с интегрированным мониторингом и возможностями AIOps;

– резервное копирование. Системы искусственного интеллекта часто имеют такой большой объем данных, что традиционные системы резервного копирования могут испытывать трудности с наборами данных пета-масштаба, где «гравитация данных» является проблемой. Снимки данных не являются идеальным способом управления резервными копиями, поэтому системам искусственного интеллекта могут потребоваться инструменты синхронизации/репликации данных для поддержки операций резервного копирования. В любом случае операции резервного копирования и восстановления могут затянуться, что приведет к значительному увеличению активности ввода-вывода и потенциальному снижению производительности;

– архив. Хотя резервное копирование AI является важным процессом для сбора или восстановления данных для восстановления в случае потери или сбоя данных, архив AI централизует копии данных, которые служат записью или аудитом для последующей оценки. Например, можно заархивировать набор обучающих данных или модель, а затем заархивировать копии входных данных и решения или рекомендации вместе со ссылкой на модель для целей аудита. Рабочая нагрузка может представлять собой непрерывный поток принятых и сгенерированных искусственным интеллектом данных на круглосуточную архивную платформу, что потенциально влияет на ввод-вывод и производительность.

Планирование каждого из этих дополнительных требований в общем контексте жизненного цикла данных ИИ имеет важное значение. Хотя возможно определить уникальные архитектуры хранения для оптимизации каждого стиля рабочей нагрузки, описанного выше, крайне важно тщательно организовать весь путь обработки данных ИИ для обеспечения непрерывных операций с данными 24×7.

Адаптация DDN Lustre к AI-нагрузкам

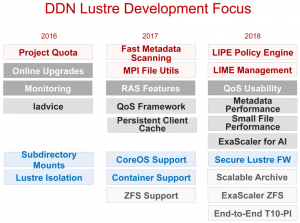

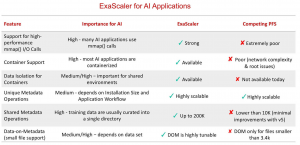

На рис. 7 представлено развитие DDN Lustre с точки зрения лучшего соответствия AI-нагрузкам. На рис. 8. – сравнение функциональных особенностей DDN EXAScaler с альтернативными параллельными файловыми системами на момент 2018 г. [8].

Рис. 7. История развития DDN Lustre в течение 2016-2018 гг. [8].

Рис. 8. Сравнение функциональных особенностей DDN EXAScaler с альтернативными параллельными файловыми системами на момент 2018 г. [8].

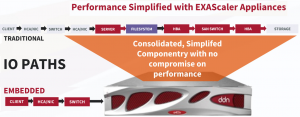

DDN максимально реализовала весь стек ПО при доступе к своим продуктам в составе т.н. интеллектуальных агентов, которые устанавливаются в контейнерные приложения и максимально снижают задержки и повышают производительность (рис. 9, [9]), а также упрощают развертывание и масштабирование. DDN на базе встроенных агентов поддерживает максимально полный стек всех контейнерных приложений (рис. 10, [9]).

Рис. 9. DDN максимально интегрировала весь стек ПО при доступе к своим DDN A3 I продуктам в составе агентов контейнерных приложений [9].

Рис. 10. Универсальный акселератор для контейнеров [9].

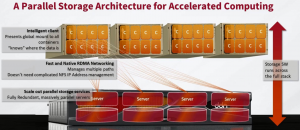

Доступ к устройствам DDN A3I виртуализован и максимально распараллеливается [10] (рис. 11), и фреймворки могут одновременно взаимодействовать со всеми серверами хранения (см. рис. 11).

Рис. 11. Доступ к устройствам DDN A3 I виртуализован и максимально распараллеливается [10].

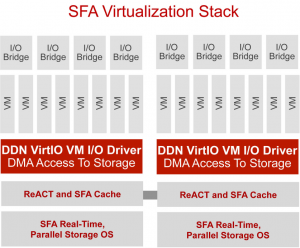

Поддержка DDN SFA стека виртуализации (рис. 12) дает возможность:

– простого управления с помощью стандартного стека виртуальных машин;

– гибкой реализация виртуализированных OSS и MDS;

– обеспечения работы стеков RAID и OSS в изолированных экземплярах ОС;

– повысить производительность IOPS и пропускную способность.

Рис. 12. Поддержка DDN SFA стека виртуализации [8].

EXAScaler DDN A3I обеспечивает быстрый и беспрепятственный доступ к файлам к общему хранилищу непосредственно из контейнерных приложений во время выполнения с полной производительностью (рис. 10, [9]).

Возможность параллельного клиента добавляется во время выполнения с помощью универсальной оболочки и не требует каких-либо изменений в приложении или контейнере. При этом поддерживается простота развертывания и управления разделенным доступом к данным, а также безопасная многопользовательская среда с надежными уровнями сегрегации с использованием контейнерных приложений.

DDN полностью всей сетевой инфраструктурой на базе быстрой встроенной сети RDMA. При этом поддерживается управление множеством путей и не требуется сложного управления IP-адресами NFS, а также одно бесшовное пространство имен (рис. 11, [10]).

Такие решения DDN дают возможность 12 системами DDN AI400X2 поддерживать 20 NVIDIA DGX A100 систем со скоростью чтения 900 GB/s и скоростью записи 780 GB/s (рис. 13, [10]).

Рис. 13. 12 систем DDN AI400X2 поддерживают 20 NVIDIA DGX A100 систем со скоростью чтения 900 GB/s и скоростью записи 780 GB/s [10].

Контрольные точки улучшают модель искусственного интеллекта и производительность рабочего процесса

Большое внимание DDN уделяется поддержке контрольных точек при обучении моделей, которое может длиться несколько недель и более. По ценкам Meta Al Research Team [10], «10% заданий выполняются не менее 13,5 часов, прежде чем они терпят неудачу, и 1% заданий завершаются неудачно после выполнения не менее 53,9 часов. Многие из этих заданий требуют 128 графических процессоров, охватывающих множество узлов, покупка которых очень дорога, а также поддержка и работа».

Контрольные точки делают снимок модели и сохраняют его в энергонезависимой памяти. Они являются важной частью эффективного обучения долго работающих моделей ИИ, особенно в масштабе:

– регистрация, сохранение, приостановка и возобновление работы приложений Al – возможность возобновить тренировку на определенном этапе процесса обучения и восстановить его после любой неудачи, сохраняя при этом все результаты обучения;

– повышение точности прогнозирования вывода – при непрерывном обучении для вывода используются промежуточные модели, а онлайн-обучение продолжается с новыми наборами данных и параметрами;

– возможность переноса ИИ-процессов в разные системы – простота перехода на другую платформу, что идеально подходит в случае сбоя инфраструктуры;

– выполнение трансферного обучения – промежуточные состояния модели могут использоваться как начальные для обучения при достижении другой цели.

Масштабное NLP с DDN: Megatron-LM на NVIDIA SELENE

Обучение больших языковых моделей требует высокой производительности чтения и записи и большой емкости и имеет следующие особенности [10]:

– контрольные точки — важнейшая часть распределенного AI-обучения и требует: отказоустойчивости, возможности трансферного обучения и релокации;

– запись контрольных точек через регулярные промежутки времени во время обучения и в конце работы:

- большие модели = более высокоемкие контрольные точки;

- быстрая запись = быстрое выполнение контрольной точки = больше времени уходит на обучение;

– требуется высокая пропускная способность записи и большая разделяемая емкость хранилища:

- общий размер 172 ГБ на каждую контрольную точку (многие тысячи контрольных точек генерируются за одно обучение);

- скорость записи до 7 ГБ/с на хранилище DGX в DDN во время операции контрольной точки;

– запись в общее хранилище обеспечивает защиту в случае сбоя узла и легкий обмен контрольными точками между системами во время распределенного рабочего процесса.

Следующее поколение AI Data Cashing c DDN “горячими” узлами

Одна из больших проблем при обучении моделей – обучение в несколько эпох, когда приходиться многократно перечитывать один и тот же набор данных. DDN предлагает использовать в таких случаях кэширование данных с “горячими” узлами: использовать локальную флэш-память, чтобы максимизировать преимущества единого глобального общего пространства имен. За счет этого достигается (рис. 14):

– возможность обеспечить полную производительность Al-приложений с данными, кэшированными на локальных устройствах nvme в клиенте, без каких-либо ручных и рискованных затрат на управление данными;

– автоматизированное перемещение данных из общего пространства на локальный узел с интеллектуальным управлением кэшем на основе политик, что делает этот процесс полностью прозрачным для пользователей;

– возможность обеспечить значительную эффективность и улучшение AI-нагрузки за счет большого количества узлов, одновременно задействованных для обучения, особенно для крупномасштабного NLP.

Рис. 14. Кэширование данных с DDN Hot Nodes [10].

Это избавляет всю сеть и хранилище от повторных обращений, достаточно просто реализуется и дает огромный прирост эффективности.

Большие языковые модели

ChatGPT — чат-бот с искусственным интеллектом, разработанный компанией OpenAI и способный работать в диалоговом режиме, отвечая на запросы/вопросы на естественных языках. ChatGPT — большая языковая модель, для тренировки которой используются методы обучения с учителем и обучения с подкреплением.