RDMA over Converged Ethernet (RoCE) в сетевых Ethernet-адаптерах – часть 2

Marvell

В апреле 2020 г. компания Marvell объявила [1] о том, что ее решения для адаптеров QLogic® Fibre Channel и FastLinQ® Ethernet поддерживают технологию NVMe over Fabrics (NVMe-oF™™) в VMware vSphere 7.0. Интеграция адаптеров Marvell Fibre Channel и Ethernet в vSphere 7.0 позволяет эффективно совместно использовать высокопроизводительные флэш-накопители NVMe с низкой задержкой, объединять их в пулы и управлять ими в коммутационной сети, что приводит к созданию экономичных корпоративных и гибридных облачных архитектур центров обработки данных с горизонтальным масштабированием.

Адаптеры Marvell серий QLogic 269x 16GFC и 2700 32GFC HBA обеспечивают низкую задержку, высокодетерминированный и одновременный доступ к хранилищу FCP и FC NVMe. Адаптеры серии QLogic 2770 обеспечивают на 50% больше операций ввода-вывода в секунду, безопасность, поддерживаемую корневым корнем доверия и телеметрией виртуальных машин на основе технологии StorFusion™ VM ID. Этот богатый набор функций позволяет приложениям, ориентированным на производительность и чувствительным к задержкам, безопасно масштабироваться в сети хранения данных с поддержкой виртуализации.

Адаптеры Ethernet Marvell FastLinQ серий 41000 и 45000 поддерживают NVMe/RDMA по протоколам RoCEv2 и iWARP. Начиная с VMware vSphere 7.0, можно использовать возможности NVMe/RoCEv2 сетевых адаптеров FastLinQ в сценариях развертывания NVMe/iWARP и NVMe/TCP.

Это объявление также знаменует собой дальнейший импульс в ускорении видения Marvell в области сквозного хранения данных Ethernet, в частности, инновационной архитектуры Ethernet Bunch of Flash (EBOF) для оптимальной дезагрегированной высокопроизводительной флэш-памяти. Развернув vSphere 7.0, операторы центров обработки данных могут использовать адаптеры Marvell FastLinQ для архитектуры EBOF компании Marvell, состоящей из контроллеров преобразователя твердотельных накопителей NVMe-oF Ethernet, контроллеров твердотельных накопителей и коммутаторов Ethernet Prestera®. Благодаря этой масштабируемой архитектуре центры обработки данных от периферии до облака могут значительно повысить производительность и снизить совокупную стоимость владения (TCO).

Universal RDMA

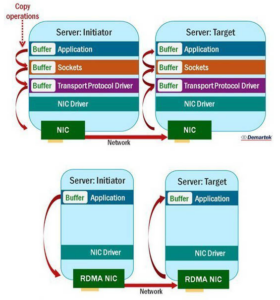

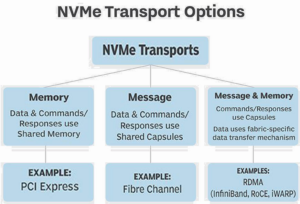

Удаленный прямой доступ к памяти (RDMA, Remote direct memory access) — это технология, которая используется уже более десяти лет. При подключении к серверу копирование данных является основным источником накладных расходов на обработку. В обычном сетевом стеке полученные пакеты сохраняются в памяти операционной системы, а затем копируются в память приложения. Это копирование потребляет циклы ЦП, а также приводит к задержке. Сетевые адаптеры, реализующие RDMA, позволяют записывать данные непосредственно в память приложения. Приложения, передающие большие блоки данных, такие как сетевое хранилище и миграция виртуальных машин, получают наибольший прирост эффективности от RDMA (https://www.marvell.com/products/ethernet-adapters-and-controllers/universal-rdma.html).

Поскольку сетевой адаптер (NIC) должен знать, где размещать данные в памяти, сетевой протокол должен явно поддерживать RDMA. Первым таким протоколом, получившим широкое распространение, был InfiniBand, который с самого начала разрабатывался на основе RDMA. Методы, разработанные для InfiniBand, позже были адаптированы для сетей Ethernet с использованием новых протоколов RDMA — сначала iWARP, а затем RoCE.

Marvell® является одним из лидеров, продвигающих экосистему RDMA с целью расширения охвата технологий RDMA за пределы сервера и по сети для доступа к удаленному хранилищу. Адаптеры Marvell FastLinQ Series 10/25/40/50/100GbE поддерживают Universal RDMA (RoCE, RoCEv2 и iWARP) и предоставляют клиентам лучший выбор.

Преимущества универсального RDMA

С сетевыми адаптерами FastLinQ® 41000/45000 компания Marvell применила уникальный подход к работе как с RoCE, так и с iWARP.

Благодаря конструкции, не зависящей от протокола, технология Marvell FastLinQ обеспечивает следующие преимущества:

– перспективные возможности подключения: сетевые адаптеры FastLinQ Universal RDMA с поддержкой RDMA предлагают перспективный путь внедрения RDMA. Если в долгосрочной перспективе лагерь RoCE или iWARP получит более широкое распространение на рынке, клиент будет защищен от устаревания сетевой карты. Кроме того, наша поддержка 100G Ethernet дает клиентам гарантированный путь к более высокой производительности по мере необходимости;

– отсутствие привязки к поставщику: выбирая сетевые адаптеры FastLinQ, клиенты также избегают привязки к поставщику, поскольку эти сетевые адаптеры взаимодействуют с сетевыми адаптерами всех других поставщиков, предлагающих RoCE или iWARP. Если клиент в конечном итоге решит перейти с iWARP на RoCE или наоборот, те системы, которые уже развернуты с использованием FastLinQ, не нуждаются в повторной квалификации;

– подключение внешнего и внутреннего хранилища: для систем хранения сетевые адаптеры FastLinQ можно комбинировать и сопоставлять между внешними и внутренними сетями, максимально увеличивая повторное использование и сводя к минимуму запасные части. Например, клиент может сначала использовать сетевую карту 25GbE для внутреннего подключения, а затем повторно использовать эту сетевую карту для внешнего канала, когда серверная часть будет обновлена до 50GbE или 100GbE.

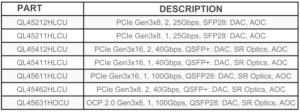

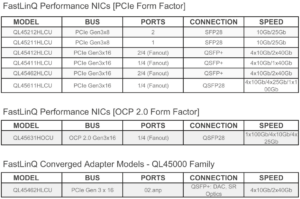

Поддержка Universal RDMA RoCE, RoCEv2 и iWARP реализована в линейках Marvell FastLinQ® 41000 (10/25/40/50GbE)/45000 (10/ 25/40/50/100GbE) NIC. Основные характеристики семейства адаптеров Marvell FastLinQ® 45000 представлены в табл. 1 (https://www.marvell.com/products/ethernet-adapters-and-controllers/45000-ethernet-adapters.html).

Табл. 1. Основные характеристики семейства адаптеров Marvell FastLinQ® 45000.

Адаптер Marvell® FastLinQ® QL45611HLCU – многопортовый Ethernet-адаптер 10/25/100 Гбит/с с Universal RDMA [2]

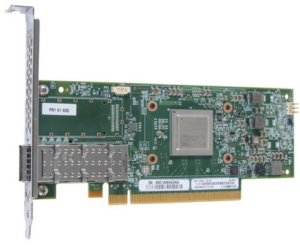

Интеллектуальный Ethernet-адаптер Marvell FastLinQ QL45611HLCU с универсальным удаленным прямым доступом к памяти (RDMA) поддерживает 10 гигабитный Ethernet (GbE), 25GbE и 100GbE QSFP28, а также трафик локальной сети (TCP/IP) на линейных скоростях. QL45611HLCU обеспечивает низкую загрузку ЦП хоста, обеспечивая полную разгрузку без сохранения состояния, чтобы удовлетворить требования к производительности самых ресурсоемких корпоративных приложений.

Для более эффективного использования полосы пропускания 10/25/100GbE интеллектуальный адаптер Ethernet QL45611HLCU предлагает независимое от коммутатора разделение сетевых карт (NPAR), которое позволяет сегментировать порт 10/25/100GbE на несколько сетевых разделов и динамически распределять полосу пропускания для каждого порта. Сегментация позволяет ИТ-организациям оптимизировать ресурсы, снижая при этом затраты на инфраструктуру и эксплуатацию (рис. 1).

Рис. 1. Marvell® FastLinQ® QL45611HLCU Adapter.

Marvell FastLinQ QL45611HLCU — лучший выбор для ресурсоемких вычислительных сред, предоставляющий надежные и высокопроизводительные решения для подключения 10/25/100GbE.

Функции FastLinQ QL45611HLCU:

- поддержка PCI Express® (PCIe®) Gen 3 x16 (8 ГТ/с);

- полная производительность на линейной скорости для одного и четырех портов;

- широкая поддержка операционных систем (ОС) и гипервизоров;

- поддержка сетевой загрузки:

- удаленная загрузка iSCSI (SW);

- Preboot Execution Environment (PXE) 2.0;

- поддержка Unified Extensible Firmware Interface (UEFI);

- упрощение развертывания и устранения неполадок с помощью QConvergeConsole® (QCC) GUI, QLogic® Control Suite (QCS) CLI, QCC PowerKit, UEFI human interface infrastructure (HII), inOS utilities, QCC Center GUI and ESXCLI Plugins и интеграции OpenStack®;

- независимый от коммутатора NPAR с назначением до 16 разделов на адаптер;

- механизм высокоскоростной обработки пакетов Marvell Data Plane Development Kit (DPDK) обеспечивает скорость передачи до 68 млн пакетов в секунду при размере кадра 64 байта;

- Marvell Flow Filtering поддерживается в Linux® с помощью команд ethtool u/U (доп. информацию см. в руководстве по развертыванию адаптеров серии FastLinQ 41000/45000 для фильтрации и управления потоками ntuple);

- поддержка технологий Universal RDMA — RDMA over Converged Ethernet (RoCE), RoCEv2 и протокол RDMA глобальной сети Интернет (iWARP, Internet wide area RDMA);

- поддержка MSI и MSI-X;

- разгрузка IPv4 и IPv6 без сохранения состояния;

- виртуализация ввода-вывода с одним корнем PCISIG® (SR IOV, single root input/output virtualization) с поддержкой до 240 виртуальных функций — поддержка QoS Linux SRIOV VF с помощью команды ip link set;

- комплексная разгрузка без сохранения состояния;

- автосогласование: 10G/25G/100G;

- FastLinQ SmartAN™ для упрощения подключения к коммутаторам с интерфейсом SFP и QSFP. Интерфейсы (SFP/QSFP) могут принимать кабель прямого подключения (DAC) или оптические соединения (дискретные отдельные оптические модули или активный оптический кабель (AOC, active optic cable));

- мультиочередь RX/TX:

- VMware® NetQueue;

- Windows® Hyper-V® Virtual Machine Queue;

- мультиочередность Linux;

- туннельные разгрузки:

- Windows Network Virtualization, используя Generic Routing Encapsulation (NVGRE);

- Linux Generic Routing Encapsulation (GRE);

- VMware, Windows и Linux Virtual Extensible LAN (VXLAN);

- Linux and VMware Generic Network Virtualization Encapsulation (GENEVE);

- Receive side scaling (RSS);

- Transmit side scaling (TSS);

- поддержка для virtual LAN (vLAN) tagging;

- поддержка больших (jumbo) кадров размером более 1500 байт (до 9600 байт);

- объединение сетей, аварийное переключение и балансировка нагрузки:

- Switch independent NIC teaming/bonding;

- Switch dependent NIC teaming/bonding such as link aggregation control protocol (LACP) and generic trunking;

- Data center bridging (DCB):

- Data center bridging capability exchange protocol (DCBX) link layer discovery protocol (LLDP);

- Priority-based flow control (PFC);

- Traffic Class over vLAN’s 3bit priority code point (PCP) field or Traffic Class over the IP header’s 3bit differentiated services code point (DSCP) field;

- Enhanced Transmission Selection (ETS);

- Explicit Congestion Notification (ECN or CN);

- Data Center Quantized Congestion Notification (DCQCN);

- Non-offloaded Storage over Ethernet (iSCSI using OS-based software initiators);

- разгрузка хранилища через Ethernet: увеличивает производительность сервера за счет полной разгрузки оборудования для трафика хранилища.

Упрощенный переход на 10/25/100GbE

Marvell FastLinQ QL45611HLCU имеет высокоскоростную гибкую архитектуру и независимую от коммутатора технологию NPAR. Этот независимый от коммутатора подход, разработанный как для физических, так и для виртуальных сред, позволяет администраторам разделить сетевой канал 10/25/100GbE для разделения и перераспределения пропускной способности и ресурсов по мере необходимости на уровне адаптера:

- заказчики, развертывающие стоечные и напольные серверы с несколькими адаптерами GbE, могут значительно выиграть от объединения нескольких сетевых адаптеров и освобождения слотов PCI для других обновлений дополнительных карт;

- с помощью NPAR адаптеры QL45611HLCU могут дополнительно разделять полосу пропускания своей сети на несколько виртуальных подключений, благодаря чему 1 адаптер отображается в операционной системе как 8 (в режиме 1x100G) или 16 (в четырехпортовом режиме) адаптеров для использования приложениями;

- NPAR значительно упрощает физическое подключение к серверу, сокращает время внедрения и снижает стоимость перехода на 10/ 25/100GbE;

- QL45611HLCU — идеальный выбор для миграции нескольких сетевых подключений 1GbE на консолидированные 10/25/100GbE. Он совместим с оптикой SR, LR, медью прямого подключения (DAC) на скоростях 10 и 100G; а также, оптика SR, оптика LR и ЦАП, для которых не требуется RS-FEC на скорости 25G;

- QL45611HLCU может объединять хранилище и сетевой ввод-вывод за счет развертывания программных инициаторов iSCSI на базе ОС через оптические соединения или соединения DAC.

Разработан для виртуализации серверов нового поколения

Marvell FastLinQ QL45611HLCU поддерживает привлекательный на сегодняшний день набор мощных функций сетевой виртуализации: SR-IOV, NPAR, туннелирование разгрузки (VXLAN, GRE, GENEVE и NVGRE) и лучшую в отрасли производительность, тем самым улучшая базовые функции виртуализации серверов:

- SR-IOV обеспечивает более высокую производительность и меньшее использование ресурсов ЦП за счет повышенной масштабируемости виртуальной машины (ВМ);

- Marvell NPAR позволяет использовать до 8 (режим 1x100G) или 16 (режим четырех портов) физических независимых от коммутаторов разделов NIC на адаптер. Динамическое и детальное выделение полосы пропускания позволяет контролировать сетевой трафик от виртуальных машин и служб гипервизора;

- параллельная поддержка SR-IOV и NPAR обеспечивает возможность выбора и гибкость виртуальных сред для создания гибкой платформы виртуальных серверов;

- наличие как RSS, так и TSS позволяет более эффективно распределять нагрузку между несколькими ядрами ЦП.

Поддержка высокопроизводительной многопользовательской среды

Поскольку требования к изоляции и безопасности крупномасштабного частного и общедоступного облака расширяют границы традиционных виртуальных локальных сетей, Marvell FastLinQ QL45611HLCU предоставляет функции сетевой виртуализации для высокопроизводительных оверлейных сетей:

- QL45611HLCU, предназначенный для удовлетворения потребностей крупных общедоступных облачных сред, обеспечивает разгрузку туннелирования для многопользовательской среды с поддержкой VXLAN, GRE, GENEVE и NVGRE;

- поддержка линейной производительности 10/25/100GbE на отдельных портах в мультиарендных развертываниях максимизирует производительность серверной обработки за счет пре доставления разгруженного адаптера Ethernet для корпоративных, телекоммуникационных и облачных развертываний на Microsoft® Windows Server®, VMware vSphere® и различных дистрибутивах Linux.

Упрощенное управление

QConvergeConsole (QCC) от Marvell предоставляет администраторам широкий набор мощных функций управления Ethernet-адаптерами, чтобы максимизировать производительность и доступность приложений. Также доступна интеграция vCenter GUI и подключаемых модулей ESXCLI.

Интерфейс командной строки QCS доступен для локального и удаленного управления серверами Linux и Windows. QCC PowerKit доступен для удаленного управления серверами Linux, VMware vCenter (PowerCLI) и Windows. Кроме того, на серверах, поддерживающих UEFI HII, доступна предзагрузочная конфигурация устройства BIOS системы UEFI HII.

Ускорение работы сети с разгрузкой Universal RDMA

Marvell FastLinQ QL45611HLCU поддерживает ускорение RoCE и iWARP (с возможностью, но не включено) для обеспечения низкой задержки, низкой загрузки ЦП и высокой производительности в операционных системах Windows, VMware и Linux. QL45611HLCU обладает уникальной возможностью предоставления Universal RDMA, поддерживающего RoCE, RoCEv2 и iWARP. Marvell Universal RDMA обеспечивает максимальную гибкость в ускорении сценариев использования, таких как Microsoft Storage Spaces Direct (S2D), Windows Live Migration, VMware PVRDMA и vSAN, NVMe™ поверх Fabrics (NVMe-oF), CEPHS и NFS over RDMA, Linux/Windows VF RDMA и др. Передовая технология разгрузки Marvell повышает эффективность и масштабируемость кластера до многих тысяч узлов для развертывания гиперконвергентной инфраструктуры. Клиенты, желающие масштабировать NVMe-oF, могут использовать возможности QL45611HLCU для поддержки RoCE, RoCEv2, iWARP или недавно добавленного TCP (называемого NVMe-oF через TCP или NVMe/TCP) в дополнение к транспортным фабрикам RDMA.

Ускорение рабочих нагрузок Telco Network Function Virtualization (NFV)

Marvell FastLinQ QL45611HLCU поддерживает NFV, что позволяет отделить сетевые функции и службы от выделенного оборудования (например, маршрутизаторов, брандмауэров и балансировщиков нагрузки) в размещенных виртуальных машинах. NFV позволяет сетевым администраторам гибко создавать сетевые функции и службы по мере необходимости, сокращая капитальные и эксплуатационные расходы, а также повышая гибкость бизнеса и сетевых служб. Технология Marvell интегрирована в DPDK и может передавать до 68 миллионов пакетов в секунду для размещения самых ресурсоемких рабочих нагрузок NFV.

QL45611HLCU также поддерживает драйвер режима опроса NSX T/NVDS Enhanced data path/Network Stack (ENS) (QeDeNTV_ens) для рабочих нагрузок NFV на VMware ESXi 6.7.

Адаптер QL45611HLCU — это адаптер на основе подключения к хостингу PCIe Gen 3, который имеет один из самых низких профилей энергопотребления в отрасли.

Надежный, безопасный, надежный и совместимый

Адаптер Marvell FastLinQ QL45611HLCU 10/25/100GbE соответствует стандартам, обеспечивающим совместимость с широким спектром сетевых решений. Адаптеры Marvell безопасны по своей конструкции. С помощью технологии шифрования с открытым и закрытым ключами адаптеры реализуют процесс безопасного обновления, встроенного ПО, который не позволяет хакерам изменять код, работающий на адаптерах.

LR-LINK

Компания Shenzhen Lianrui Electronics Co., Ltd (LR-LINK), основанная в 2006 году, имеет собственный бренд LR-LINK и является профессиональным поставщиком решений Ethernet. Она также представляет научно-техническое предприятие, которое объединяет исследования и разработки, производство, продажу и обслуживание адаптеров Ethernet с различными интерфейсами (https://www.lrlink.com/about.html).

Компания является членом Промышленной ассоциации PCI-SIG и Китайского союза индустрии машинного зрения, а также имеет сертификаты качества – ISO 9001:2008, ISO9001:2015, CE, FCC, Rohs и Reach.

Ethernet решения LR-LINK, широко используемые в профессиональных областях, таких как промышленная автоматизация, машинное зрение, IDC, облачные вычисления, огромный центр хранения данных, сетевая безопасность и т. д., включая передачу по медным и оптоволоконным сетям, от одного до восьми портов, от 100 м до 40G, в основном на базе контроллеров Intel, Tehuti, Marvell, Broadcom.

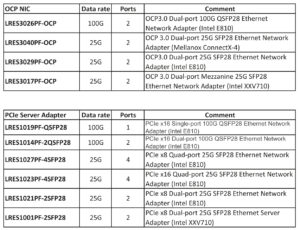

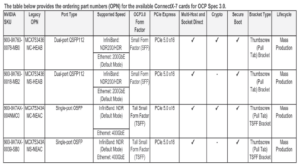

В портфеле LR-LINK целое семейство карт с поддержкой RDMA (RoCE) разной производительности (табл. 2).

Табл. 2. Высокопроизводительные Ethernet-карты LR-LINK с поддержкой RDMA.

LRES3026PF-OCP

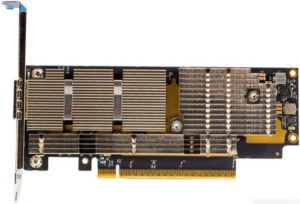

LRES3026PF-OCP (рис. 2) – это двухпортовый сетевой адаптер OCP3.0 100G QSFP28 Ethernet (Intel E810), имеющий характеристики (https://www.lrlink.com/products/lres3026pf-ocp.html):

- два порта 100G Ethernet OCP3.0 SFF;

- поддержка NVMe для Fabric TCP, а также дополнительная поддержка функций RDMA iWARP и RoCEv2;

- поддержка функция технологии очереди приложений, гарантирующая, что каждое приложение может запросить принадлежность к своей собственной очереди, со скоростью передачи до 100 Гбит/с;

- среди применений – центры обработки данных с высокой пропускной способностью, облачные вычисления, хранилища;

- используя технологию конфигурации многофункционального порта EPCT, адаптер можно настроить для нескольких скоростей.

Рис. 2. LRES3026PF-OCP – OCP3.0 Dual-port 100G QSFP28 Ethernet Network Adapter (Intel E810).

Адаптер LRES3026PF-OCP разработан Shenzhen Lianrui Electronics Co., LTD на базе чипа Intel. Функция технологии очереди приложений оптоволоконной сетевой карты гарантирует, что каждое приложение может запрашивать свою собственную очередь, то есть данные между собой больше не путаются со скоростью интерфейса до 100 Гбит/с. Его можно широко использовать в сетевых устройствах для сервисов центра обработки данных, облачных вычислений и хранилищах с высокой пропускной способностью.

Оптоволоконная сетевая карта обеспечивает масштабируемую технологию ADQ для улучшения масштабируемости производительности и предсказуемости критических рабочих нагрузок за счет выделения определенных ресурсов для критических рабочих нагрузок. ADQ реализует контроль данных, информацию и ограничение скорости для конкретных приложений, используя оптимизированные потоки приложений для путей данных устройств.

LRES3026PF-OCP управляется Intel, а технология конфигурации многофункциональных портов EPCT позволяет настраивать адаптер с различными скоростями, такими как 2*100G, 1*100G, 2*50G, 4*25G, 2*2*. 25G и 8*10G, чтобы удовлетворить требования раз личных случаев.

Среди других характеристик LRES3026PF-OCP:

- контроллер: Intel E810;

- форм-фактор: SFF;

- потребляемая мощность: DAC, 19.2W; Fiber, 27.1W;

- поддерживаемые ОС: Windows Server 2016 R2/2019 R2/2022 R2, Linux SLES 12.x or later, CentOS / RHEL 7.x or later, Ubuntu 16.x or later, FreeBSD 11.x/12.x or later, Linux Stable Kernel version

- 10.x/4.x or later;

- тип шины: OCP3.0 SFF;

- скорость передачи данных: 10/25/50/100GbE;

- коннектор: 2*25G SFP28;

- поддержка PXE/UEFI – Yes;

- DPDK — Yes;

- Jumbo Frames – Yes;

- iSCSI – No;

- Jumbo Frames – Yes;

- FCoE – No;

- RDMA(iWARP?RoCE v2) – Yes;

- Network virtualization – SRIOV, VxLAN, GENEVE, GRE.

LRES1014PF-2QSFP28 – двухпортовый сетевой адаптер PCIe x16 100G QSFP28 Ethernet (Intel E810)

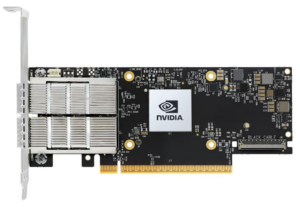

LRES1014PF-2QSFP28 — это двухпортовый оптоволоконный сетевой адаптер 100G Ethernet PCI Express v4.0 x16, разработанный Shenzhen Lianrui Electronics Co., Ltd. на основе решения Intel Master Control. Он дополнен функцией расширения обработки пакетов данных с аппаратным ускорением, а также внедрена технология очереди приложений. Эта технология может реализовать поддержку NVMe для Fabric TCP. Он также имеет выборочную поддержку функций RDMA iWARP и RoCEv2. Адаптер обратно совместим с PCIe v3.0 и v2.0. Плата адаптера обеспечивает двухпортовую двунаправленную передачу данных с теоретической пропускной способностью 400 ГБ на шине PCI Express v4.0 x16 (рис. 3).

Рис. 3. LRES1014PF-2QSFP28- PCIe x16 Dual-port 100G QSFP28 Ethernet Network Adapter (Intel E810).

Карта использует технологию очереди приложений, чтобы гарантировать, что каждое приложение может обращаться к своей собственной очереди. То есть данные между собой больше не путаются со скоростью интерфейса до 100 Гбит/с.

Оптоволоконная сетевая карта обеспечивает масштабируемую технологию ADQ для улучшения масштабируемости производительности и предсказуемости критических рабочих нагрузок за счет выделения определенных ресурсов для критических рабочих нагрузок. ADQ использует оптимизированный поток данных приложения к пути данных устройства для реализации функций управления данными, информации и ограничения скорости для конкретного приложения.

Ключевые особенности (https://www.lrlink.com/products/lres1014pf-2qsfp28.html):

- сетевой адаптер PCI Express v4.0 x16 с двумя портами 100G Ethernet;

- удаленный прямой доступ к памяти iWARP и RoCEv2 (RDMA);

- адаптивная виртуальная функция Intel Ethernet (Intel® Ethernet Adaptive Virtual Function – Intel Ethernet AVF);

- усовершенствованная виртуализация серверов: 256 VF, 768 VSI;

- протокол точного времени IEEE 1588 (v1 и v2) с отметкой времени для каждого пакета;

- Controller – Intel Chip;

- Форм-фактор – Half height & full height baffle;

- потребляемая мощность – Cu cable, 19.2W; Fiber model, 27.1WSystem;

- поддержка ОС: Windows Server 2016 R2/2019 R2/2022 R2; Linux Stable Kernel version 4.x/5.x or later; CentOS/RHEL 7.x or later; Ubuntu 16.x or later; VMware ESX/ESXi 5.x/6.x or later;

- тип шины – PCI Express v4.0 x16, Compatible with PCI Expressv3.0;

- пропускная способность – 10/25/50/100GbE;

- коннектор – 2*QSFP28;

- iSCSI – Yes;

- WoL – No;

- Jumbo Frames – Yes;

- DPDK – Yes;

- PXE – Yes;

- FCoE – No;

- Network virtualization – SRIOV, VxLAN, GENEVE, GRE.

NVIDIA

В марте 2022 г. NVIDIA представила высокопроизводительную платформу сетевой инфраструктуры центра обработки данных NVIDIA Spectrum™-4. Сквозная гипермасштабируемая сетевая платформа 400G обеспечивает 4-кратное ускорение благодаря революционному коммутатору Spectrum-4, DPU BlueField-3 и ConnectX-7 SmartNIC [3].

Первая в мире сквозная сетевая платформа 400 Гбит/с, NVIDIA Spectrum-4 обеспечивает в 4 раза более высокую пропускную способность коммутации, чем предыдущие поколения, со скоростью 51,2 терабит в секунду. Она состоит из семейства коммутаторов NVIDIA Spectrum-4, NVIDIA ConnectX®-7 SmartNIC, NVIDIA BlueField®-3 DPU и ПО для инфраструктуры центра обработки данных DOCA™, позволяющего увеличить масштабируемость облачных приложений.

Созданная для искусственного интеллекта, платформа NVIDIA Spectrum-4 появляется по мере того, как центры обработки данных растут в геометрической прогрессии и требуют экстремальной производительности, расширенной безопасности и мощных функций для обеспечения высокопроизводительной расширенной виртуализации, и масштабного моделирования.

Коммутаторы Spectrum-4 обеспечивают наносекундную точность синхронизации, что является улучшением на пять-шесть порядков по сравнению с типичными центрами обработки данных, основанными на миллисекундах. Они также ускоряют, упрощают и защищают сетевую фабрику благодаря удвоенной пропускной способности для каждого порта, в 4 раза меньшему количеству коммутаторов и на 40% меньшему энергопотреблению по сравнению с предыдущим поколением.

NVIDIA Spectrum-4 ASIC и семейство коммутаторов SN5000 основано на техпроцессе 4N и содержит более 100 млрд транзисторов, а также упрощенную конструкцию трансивера, что обеспечивает лучшую в своем классе энергоэффективность и общую стоимость владение. Благодаря совокупной пропускной способности ASIC 51,2 Тбит/с, поддерживающей 128 портов 400GbE, в сочетании с адаптивной маршрутизацией и усовершенствованными механизмами управления перегрузкой, Spectrum-4 оптимизирует RDMA по фабрикам Converged Ethernet и значительно ускоряет работу центров обработки данных.

ASIC Spectrum-4 обладает самыми современными функциями безопасности, такими как поддержка MACsec и VXLANsec, а также безопасная загрузка по умолчанию через аппаратный корень доверия, чтобы помочь обеспечить безопасность и целостность потоков данных и управления сетью.

Благодаря зашифрованной пропускной способности 12,8 Тбит/с и функциям безопасности, которые также присутствуют в DPU BlueField-3 и ConnectX-7 SmartNIC, Spectrum-4 является самой быстрой и безопасной сквозной сетевой платформой Ethernet на рынке.

Платформа Spectrum, включая коммутаторы Spectrum, BlueField и ConnectX, повышает производительность и масштабируемость приложений ИИ, цифровых двойников и облачной инфраструктуры, обеспечивая максимальную эффективность и доступность для современных центров обработки данных.

Теперь DPU BlueField разгружают и ускоряют Red Hat OpenShift, включая сквозную облачную архитектуру, которая интегрирует клиентские и инфраструктурные кластеры с инструментами автоматизации и развертывания, способными выполнять сложные контейнерные рабочие нагрузки. BlueField также занимает центральное место в проекте VMware Project Monterey, который включает сотрудничество между VMware и NVIDIA, направленное на повышение производительности, управляемости и безопасности центров обработки данных.

Интеграция DPU BlueField-2 с виртуальными брандмауэрами следующего поколения Palo Alto Networks серии VM и службой Intel-ligent Traffic Offload обеспечивает лучшие в своем классе инновации в области безопасности, которые приводят к пятикратному повышению производительности виртуальных брандмауэров для сетей предприятий и поставщиков услуг.

Платформа Spectrum ускоряет современную сетевую инфраструктуру центра обработки данных для ведущих в отрасли клиентов и поставщиков программного обеспечения, включая Akamai, Baidu, Canonical, Criteo, DDN, F5, Kuaishou, NetApp, Nutanix, OVHcloud, Pure Storage, Pluribus Networks, Red Hat, StackPath, VAST Data, VMware, WEKA и др.

Ведущие в отрасли производители серверов, интегрирующие коммутаторы Spectrum в свои системы, включают Hewlett Packard Enterprise, IBM, Lenovo и Supermicro.

DPU NVIDIA BlueField предлагаются в решениях таких новаторов, как ASUS, Atos, Dell Technologies, GIGABYTE, H3C, IBM, Inspur, Lenovo, Nettrix, Pluribus Networks, Quanta/QCT и Supermicro.

NVIDIA® ConnectX®-7

Сетевые адаптеры NVIDIA с поддержкой RDMA представлены тремя линейками: ConnectX-7 25/50/100/200/400G SmartNIC, ConnectX6 Dx Dual 100GbE / Single 200GbE и ConnectX-6 Lx 25-50G SmartNIC. Данные адаптеры построены на базе ASIC и не имеют программируемых CPU типа ARM или FPGA, поэтому не являются программируемыми с помощью языков Р4 или С/С++. В NVIDIA к этому классу (программируемых) устройств относятся DPU BlueField 2/3.

Адаптеры ConnectX обеспечивают производительность сетей Ethernet со скоростью 10, 25, 40, 50, 100 и до 200 Гбит/с для низкой задержки и высокой пропускной способности приложений. Среди ключевых их особенностей (https://www.nvidia.com/ruru/networking/ethernet-adapters/):

- за счет использования NVIDIA ASAP — технологии ускоренной коммутации и обработки пакетов (Accelerated Switch and Packet Processing®) — ConnectX SmartNIC ускоряют сеть, снижают нагрузку на процессор при передаче пакетов и позволяют увеличить количество циклов для работы с приложением;

- благодаря высокопроизводительному удаленному прямому доступу к памяти через конвергентный ethernet (RoCE) ConnectX SmartNIC обеспечивают эффективную передачу данных RDMA для приложений, чувствительных к пропускной способности и задержкам;

- обеспечение разгрузки и ускорение пропускной способности до 400 Гбит/с кодированием/декодированием;

- благодаря DPDK (Data Plane Development Kit) предлагают улучшенную пропускную способность и меньше циклов CPU;

- аппаратный корень доверия гарантирует безопасную загрузку;

- ConnectX SmartNIC сертифицированы для всех основных операционных систем, а также ведущих платформ для виртуализации и контейнеризации.

Новая линейка ConnectX-7 SmartNIC предлагает широкий спектр интеллектуальных, масштабируемых и многофункциональных сетевых решений, которые подходят для самых требовательных в мире задач искусственного интеллекта, научных вычислений и гипермасштабируемых рабочих нагрузок облачных центров обработки данных со скоростью до 400 Гбит/с.

Предшествующая линейка сетевых адаптеров ConnectX-6 Lx SmartNIC обеспечивают расширенные возможности ускорения сети и обеспечения безопасности при наилучшей совокупной стоимости владения для сред 25GbE в облачных и корпоративных центрах обработки данных.

Контроллеры ConnectX-6 Dx SmartNIC предоставляют высокопроизводительные решения для подключения со скоростью 100 Гбит/ с, которые ускоряют работу критически важных облачных, телекоммуникационных и корпоративных приложений центров обработки данных, включая безопасность, виртуализацию, SDN/ NFV, большие данные, машинное обучение и хранение.

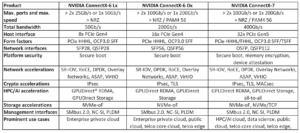

Сравнительные характеристики трех линеек NVIDIA ConnectX представлены в табл. 3 (https://nvdam.widen.net/s/fncbnrvjzw/networking-overall-product-line-card-connectx-2312900-r4).

Табл. 3. Сравнительные характеристики трех линеек NVIDIA ConnectX.

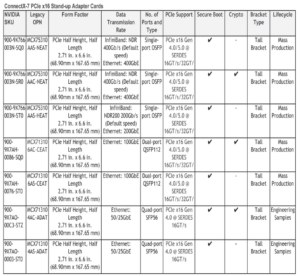

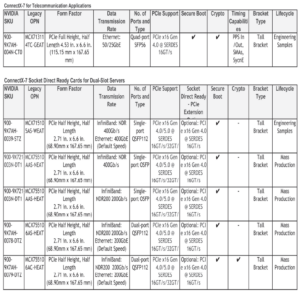

Табл. 4. Модели семейства NVIDIA® ConnectX®-7.

В семействе NVIDIA® ConnectX®-7 – 17 моделей (табл. 3,4 https://docs.nvidia.com/networking/display/ConnectX7VPI, https://docs.nvidia.com/networking/display/ConnectX7VPIOCP3, рис. 4, 5).

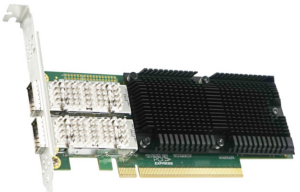

Рис. 4. NVIDIA ConnectX 7 400G OSFP Card.

Рис. 5. NVIDIA ConnectX-7 NDR200/HDR QSFP112 2Port PCIe Gen5 x16 InfiniBand Adapter (https://lenovopress.lenovo.com/lp1693-thinksystem-nvidia-connectx-7-ndr-200-infiniband-qsfp-112adapters).

Ускорение научных вычислений на основе данных с помощью вычислений в сети являясь ключевым компонентом платформы NVIDIA® Quantum-2 InfiniBand, адаптер интеллектуального хост-канала NVIDIA ConnectX®-7 (HCA, host channel adapter) обеспечивает высочайшую сетевую производительность, доступную для решения самых сложные проблемы. Адаптер ConnectX-7 InfiniBand обеспечивает сверхнизкую задержку, пропускную способность 400 Гбит/с и инновационные механизмы внутрисетевых вычислений NVIDIA, обеспечивая ускорение, масштабируемость и многофункциональные технологии, необходимые для высокопроизводительных вычислений (HPC), искусственного интеллекта (AI) и гипермасштабируемых облачных центров обработки данных [4].

Высокопроизводительные вычисления и искусственный интеллект привели к тому, что суперкомпьютеры стали широко использоваться в коммерческих целях в качестве основных механизмов обработки данных, позволяющих проводить исследования, научные открытия и разработку продуктов. Эти системы могут выполнять сложные симуляции и открывать новую эру ИИ, когда программное обеспечение пишет программное обеспечение. Сетевые технологии NVIDIA InfiniBand — двигатель этих платформ, обеспечивающий непревзойденную производительность.

Интеллектуальные механизмы ускорения внутрисетевых вычислений ConnectX-7 включают механизмы коллективного ускорения, сопоставления тегов MPI (MPI Tag Matching) и механизмы MPI_Alltoall. Эти преимущества в производительности и стандартная гарантия обратной и прямой совместимости обеспечивают высочайшую производительность и масштабируемость для приложений, интенсивно использующих вычисления и данные, и позволяют пользователям защитить свои инвестиции.

Модели семейства ConnectX-7 имеют следующие опции и особенности:

- однопортовые или двухпортовые на 400 Гбит/с или 200 Гбит/с модели с восьмеричными подключаемыми разъемами малого форм-фактора (OSFP);

- двухпортовые 200 Гбит/с модели с четырьмя съемными разъемами малого форм-фактора (QSFP);

- модели PCIe-форм-фактором половинной высоты и половинной длины (HHHL) с опциями для NVIDIA Socket Direct™;

- модели форм-фактор Open Compute Project 3.0 (OCP3.0) TSFF (tall small form factor) и с малым форм-фактором (SFF, small form factor);

- интегрированная ConnectX-7 ASIC (application-specific integrated circuit), поддерживающая возможности коммутатора PCIe;

- производительность RDMA message rate – 330370 million messages per second.

Информация по моделям NVIDIA CONNECTX-6 Dx для PCIe HHHL form factor: https://docs.nvidia.com/networking/display/ConnectX6DxEN.

Информация по моделям NVIDIA CONNECTX-6 Dx для OCP: https://docs.nvidia.com/networking/display/ConnectX6DxENOCP3.

Информация по NVIDIA ConnectX-6 Lx PCIe HHHL Ethernet Adapter Cards: https://docs.nvidia.com/networking/display/ConnectX6LxEN.

Информация по NVIDIA ConnectX-6 Lx Ethernet Adapter Cards for OCP Spec 3.0: https://docs.nvidia.com/networking/display/ConnectX6LxOCP3.

Intel

Intel® Ethernet 800 Series Network Adapters

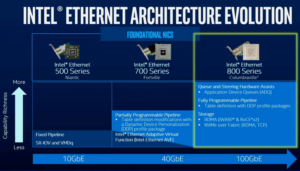

Линейка Intel® Ethernet 800 Series Network Adapters была представлена в октябре 2019 г. на Intel Networking Field Day 21 (https://TechFieldDay.com/event/nfd21/, https://www.youtube.com/watch?v=T38CWUWaeto).

Новая серия пришла на смену хорошо зарекомендовавшей себя серии 700, выпускавшейся с 2014 года (рис. 5а). Ее главная особенность — поддержка 100G Ethernet. Таким образом, теперь сетевыми картами Intel поддерживаются все применяющиеся на практике скорости Ethernet: 1/10/25/50/100G.

Рис. 5а. Поколения Ethernet-адаптеров Intel.

Сетевые карты используют интерфейс PCIe 4.0 x8/x16 и выполняются в двух форм-факторах: собственно, PCI-Express и OCP NIC 3.0. Open Compute Project (OCP) — проект с давней историей, созданный еще в 2011 году под эгидой Facebook и ставящий своей целью создание открытых стандартов и архитектур оборудования для построения энергоэффективных и экономичных ЦОД.

Спецификации OCP охватывают все компоненты и характеристики серверов: размеры, энергопотребление, питание и др. (https://habr.com/ru/company/hostkey/blog/266835/). Применительно к серверным сетевым картам стандарт OCP NIC 3.0 устанавливает следующие особенности (https://habr.com/ru/companies/intel/articles/527288/):

- открытость и универсальность — карта стандарта OCP NIC любого производителя может работать в любом сервере;

- легкая установка карт без открытия корпуса;

- возможность горячей замены;

- монтажная скоба с защитой от случайных отключений;

- стандартизированный терморежим;

- унифицированный интерфейс мониторинга и управления.

Ключевые технологии, внедренные в картах 800 серии:

- Intel Ethernet Port Configuration Tool (EPCT) — утилита, с помощью которой сетевой адаптер Intel можно настроить как необходимое количество сетевых портов суммарной пропускной способностью до 100G;

- Application Device Queues (ADQ) — технология, позволяющая создать отдельные очереди для приоритетного трафика, тем самым уменьшая и выравнивая его задержки;

- Dynamic Device Personalization (DDP) — гибко настраиваемая система фильтрации с продвинутой системой маршрутизации пакетов для их высокоэффективной обработки;

- Remote Direct Memory Access (RDMA) — хорошо известная технология оркестркамстрации, позволяющая организовать взаимодействие без сетевых оверхедов, копирования страниц памяти и лишних переключений контекстов.

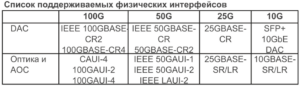

Список поддерживаемых физических интерфейсов и общие технические характеристики адаптеров Intel® Ethernet серии 800 даны в табл. 5.

Табл. 5. Характеристики адаптеров Intel® Ethernet серии 800.

Сетевые адаптеры Intel® Ethernet серии 800 поддерживают скорость до 100 Гбит/с и включают в себя инновационные и универсальные возможности для оптимизации производительности рабочих нагрузок:

- поддержка производительности для облачных приложений – обеспечение пропускную способность и повышенной пропускной способности приложений, необходимые для ресурсоемких облачных рабочих нагрузок, включая пограничные службы, веб-серверы, приложения баз данных, серверы кэширования и целевые хранилища;

- оптимизированы для коммуникационных рабочих нагрузок – обеспечивают оптимизацию классификации и сортировки пакетов для сетей с высокой пропускной способностью и коммуникационных рабочих нагрузок, включая ядро мобильной связи, 5G RAN и сетевые устройства;

- поддержка гиперконвергентных решений – широкий ассортимент адаптеров серии 800 с различным количеством портов и форм-факторами обеспечивает производительность при эффективном использовании серверных процессоров.

Среди других особенностей адаптеров Intel® Ethernet серии 800:

- всестороннее тестирование на соответствие стандартам IEEE и Ethernet Technology Consortium;

- широкие испытания на сетевую совместимость различных типов сред и Ethernet-коммутаторов для лучшей в своем классе совместимости;

- комплексная поддержка операционных систем и гипервизоров.

- оптимизированы для архитектуры Intel®;

- комплект Data Plane Development Kit (DPDK) поддерживает более быструю виртуализацию сетевых функций (NFV), расширенную переадресацию пакетов и высокоэффективную обработку пакетов.

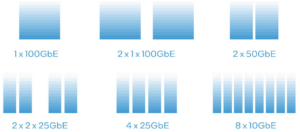

Универсальность и гибкость для центра обработки данных

Инструмент настройки порта Ethernet (EPCT, Ethernet Port Configuration Tool) доступен для сетевых адаптеров Intel Ethernet серии 800 100GbE с соединением QSFP28 и предлагает универсальное решение для сетевых сред с высокой плотностью портов и ограниченным количеством портов. Один порт становится восемью портами 10GbE, четырьмя портами 25GbE и т.д. — до шести конфигураций на выбор (рис. 5б).

Рис. 5б. С помощью инструмента EPCT один порт становится восемью портами 10GbE, четырьмя портами 25GbE и т.д. — до шести конфигураций на выбор.

Модельный ряд сетевых адаптеров Intel® Ethernet серии 800 представлен в табл. 6 [7, 8].

Табл. 6. Модельный ряд адаптеров Intel Ethernet серии 800.

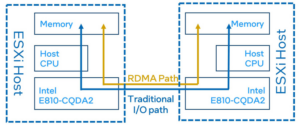

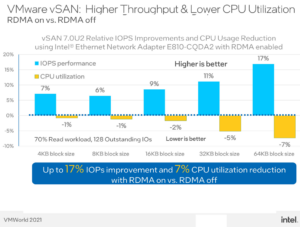

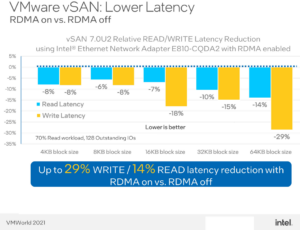

На VMWorld 2021 были представлены результаты тестирования показателей производительности с включенной аппаратной поддержкой RDMA и без нее [9]. Тестовая конфигурация – рис. 5в. Результаты тестирования – рис. 5г.

Рис. 5в. Тестовая конфигурация при измерении влияния аппаратной поддержки RDMA на показатели производительности.

Для сравнения производительности vSAN с включенным ROMA и отключенным RDMA были выбраны три показателя производительности.

- IOPS, операция ввода-вывода в секунду, измеряет, сколько операций ввода-вывода может выполняться всеми клиентскими системами в секунду. Чем больше IOP, тем лучше.

- Средняя задержка была измерена как для операций READ, так и для WRITE, чтобы показать, насколько быстро могут выполняться операции ввода-вывода. Чем меньше задержка, тем лучше.

- Также была измерена загрузка ЦП, чтобы показать, сколько циклов ЦП необходимо для выполнения этих операций ввода-вывода. Вы хотите иметь более низкую загрузку ЦП, чтобы циклы ЦП могли быть потрачены на реальные бизнеc-приложения.

Рис. 5г. Результаты тестирования влияния аппаратной поддержки RDMA на показатели производительности.

При включенном RDMA тестирование показало:

- более высокую пропускную способность (улучшение IOPS до 17%);

- более низкую загрузку ЦП (снижение до 7%), освобождая ЦП для других приложений/задач;

- низкую задержку (для больших размеров блоков: до 29% WRITE / 14% READ меньшую задержку).

Преимущества использования RDMA в приложениях [5]

Что такое удаленный прямой доступ к памяти (RDMA)?

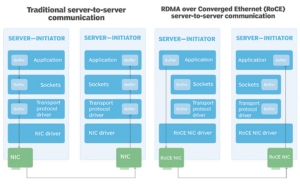

Удаленный прямой доступ к памяти — это технология, которая позволяет двум сетевым компьютерам обмениваться данными в оперативной памяти, не полагаясь на процессор, кэш или операционную систему любого компьютера. Как и локальный прямой доступ к памяти (DMA), RDMA повышает пропускную способность и производительность, поскольку высвобождает ресурсы, что приводит к более высокой скорости передачи данных и меньшей задержке между системами с поддержкой RDMA. RDMA может принести пользу как сетевым приложениям, так и приложениям для хранения данных. RDMA способствует более прямому и эффективному перемещению данных на сервер и из него за счет реализации транспортного протокола в карте сетевого интерфейса (NIC), расположенной на каждом взаимодействующем устройстве. Например, каждый из двух сетевых компьютеров может быть настроен с сетевой картой, поддерживающей протокол RDMA по конвергентному Ethernet (RoCE), что позволяет компьютерам осуществлять связь на основе RoCE.

Неотъемлемой частью RDMA является концепция сети с нулевым копированием, которая позволяет считывать данные непосредственно из основной памяти одного компьютера и записывать эти данные непосредственно в основную память другого компьютера. Передача данных RDMA обходит сетевой стек ядра на обоих компьютерах, повышая производительность сети. В результате обмен данными между двумя системами будет выполняться намного быстрее, чем в сопоставимых сетевых системах без RDMA (рис. 6).

Рис. 6. Сравнение стандартного сетевого подключения (а) и соединения RDMA (б). Инициатор и цель должны использовать один и тот же тип технологии RDMA — например, RDMA over Converged Ethernet или InfiniBand.

RDMA доказал свою полезность в приложениях, которым требуются:

- быстрые и массивные кластеры параллельных высокопроизводительных вычислений (HPC) и сети центров обработки данных;

- анализ больших данных, в суперкомпьютерных средах, обрабатывающих приложения, и для машинного обучения, требующего малых задержек и высокой скорости передачи;

- обработка баз данных – RDMA используется между узлами в вычислительных кластерах для снижения задержек.

Сетевые протоколы, поддерживающие RDMA

Сетевая карта с поддержкой RDMA должна быть установлена на каждом устройстве, участвующем в обмене данными RDMA (рис. 7).

Рис. 7. Сравнение традиционной связи сервер-сервер (слева) с связью сервер-сервер RoCE (справа).

Современные сетевые карты с поддержкой RDMA обычно поддерживают один или несколько из следующих трех сетевых протоколов:

- RDMA по конвергентному Ethernet. RoCE — это сетевой протокол, обеспечивающий связь RDMA через Ethernet. Последняя версия протокола — RoCEv2 — работает поверх протокола пользовательских дейтаграмм (UDP, User Datagram Protocol) и интернет-протокола (IP) версий 4 и 6. В отличие от RoCEv1, RoCEv2 маршрутизируемый, что делает его более масштабируемым. RoCEv2 в настоящее время является самым популярным протоколом для реализации RDMA с широким распространением и поддержкой;

- Internet Wide Area RDMA Protocol (iWARP). iWARP использует для передачи данных протокол управления передачей (TCP, Transmission Control Protocol) или протокол передачи управления потоком (SCTP, Stream Control Transmission Protocol). Инженерная рабочая группа Интернета (Internet Engineering Task Force) разработала iWARP, чтобы приложения на сервере могли читать или записывать напрямую в приложения, работающие на другом сервере, без необходимости поддержки ОС на любом из серверов;

- InfiniBand обеспечивает встроенную поддержку RDMA, стандартного протокола для высокоскоростных сетевых подключений InfiniBand. InfiniBand RDMA часто используется для межсистемной связи и впервые был популярен в средах высокопроизводительных вычислений. Благодаря своей способности быстро соединять большие компьютерные кластеры, InfiniBand нашел свое применение в дополнительных сценариях использования, таких как среды больших данных, большие транзакционные базы данных, настройки с высокой степенью виртуализации и ресурсоемкие веб-приложения.

Продукты и поставщики ПО, поддерживающие RDMA

Ряд продуктов и поставщиков поддерживают RDMA, среди них:

- анализ больших данных Apache Hadoop и Apache Spark;

- платформа хранения объектов Ceph;

- ChainerMN – основанный на Python фреймворк глубокого обучения с открытым исходным кодом;

- операционная система FreeBSD;

- GlusterFS – распределенная файловая система;

- Microsoft Windows Server (2012 и выше);

- системы глубокого обучения Nvidia DGX;

- Oracle Solaris и NFS over RDMA;

- Red Hat Enterprise Linux;

- SUSE Linux Enterprise Server;

- библиотека ПО TensorFlow с открытым исходным кодом для машинного интеллекта;

- фреймворк для научных вычислений Torch;

- VMware ESXi.

RDMA с SSD на основе флэш-памяти и модулями NVDIMM

Системы хранения All-flash работают намного быстрее, чем дисковые или гибридные массивы, что обеспечивает значительно более высокую пропускную способность и меньшую задержку. Однако традиционный программный стек часто не справляется с объемом флэш-памяти и становится узким местом, увеличивая общую задержку. RDMA может помочь решить эту проблему, повысив производительность сетевых коммуникаций.

RDMA также можно использовать с энергонезависимыми модулями памяти с двойным расположением выводов (NVDIMM, Non-Volatile Dual In-line Memory Module). Устройство NVDIMM — это тип памяти, который действует как хранилище, но обеспечивает скорость, подобную памяти. Например, NVDIMM может повысить производительность базы данных в 100 раз. Это также может принести пользу виртуальным кластерам и ускорить виртуальные сети хранения данных (VSAN).

NVDIMM – энергонезависимая память DIMM – это тип постоянной памяти с произвольным доступом, использующих широко распространенные форм-факторы DIMM. Энергонезависимая память — это память, которая сохраняет свое содержимое даже при отключении электропитания, например, из-за неожиданного отключения питания, сбоя системы или нормального завершения работы. При правильном использовании модули NVDIMM могут повысить производительность приложений и время восстановления системы после сбоя. Они повышают долговечность и надежность твердотельных накопителей (SSD).

Многие «энергонезависимые» продукты используют энергозависимую память во время нормальной работы и сбрасывают содержимое в энергонезависимую память в случае сбоя питания, используя встроенный резервный источник питания. Энергонезависимая память быстрее энергонезависимой; это байтовая адресация; и его можно записывать произвольно, не беспокоясь об износе и сроке службы устройства. Однако включение второй памяти для обеспечения энергонезависимости (и встроенного резервного источника питания) увеличивает стоимость продукта по сравнению с энергозависимой памятью.

На рынке находится много новых энергонезависимых запоминающих устройств, включая магниторезистивное ОЗУ (MRAM) и Intel 3D XPoint, а также MRAM, Nano RAM на основе углеродных нанотрубок представляет собой технологию, призванную приблизиться к DRAM по критериям производительности, байтовой адресации и продолжительности жизни устройства.

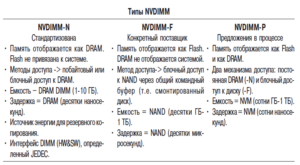

JEDEC Standards org предлагает три типа реализации NVDIMM:

- NVDIMM-N: DIMM с флэш-памятью и традиционной DRAM на одном модуле. Компьютер обращается к традиционной памяти DRAM непосредственно во время работы системы. В случае сбоя питания модуль копирует данные из энергозависимой традиционной DRAM в постоянную флэш-память и копирует их обратно при восстановлении питания. Он использует небольшой резервный источник питания для модуля, пока данные из DRAM копируются во флэш-память;

- NVDIMM-F: DIMM с флэш-накопителем. Пользователям системы потребуется соединить модули памяти DIMM вместе с традиционными модулями DRAM DIMM. Хотя официального стандарта нет, модули типа NVDIMMF доступны с 2014 года;

- NVDIMM-P: спецификация, полностью выпущенная JEDEC в феврале 2021 года. Он позволяет основной памяти компьютера быть постоянной, используя технологию постоянной памяти, и может совместно использовать межсоединение DIMM DDR4 или DDR5 с модулями DIMM DRAM (https://en.wikipedia.org/wiki/NVDIMM).

Чтобы получить максимальную отдачу от NVDIMM, следует использовать максимально быструю сеть при передаче данных между серверами или в виртуальном кластере. Это важно с точки зрения как целостности данных, так и производительности. RDMA по конвергентному Ethernet может хорошо подойти для этого сценария, поскольку он перемещает данные непосредственно между модулями NVDIMM с небольшими системными издержками и малой задержкой (рис. 8).

Рис. 8. Типы NVDIMM.

NVM Express over Fabrics с использованием RDMA

Организации все чаще хранят свои данные на SSD на основе флэш-памяти. Когда эти данные передаются по сети, RDMA может помочь повысить производительность доступа к данным, особенно при использовании в сочетании с NVM Express over Fabrics (NVMe-oF).

Организация NVM Express опубликовала первую спецификацию NVMe-oF 5 июня 2016 года и с тех пор несколько раз пересматривала ее. Спецификация определяет общую архитектуру для расширения протокола NVMe на сетевую фабрику. До NVMe-oF протокол был ограничен устройствами, которые подключались непосредственно к слотам PCI Express (PCIe) компьютера (рис. 9).

Рис. 9. RDMA — это транспорт — через InfiniBand, RoCE и iWARP и одновременно это вариант транспорта для фабрик NVMe.

Спецификация NVMe-oF поддерживает несколько сетевых транспортов, включая RDMA. NVMe-oF с RDMA позволяет организациям в полной мере использовать преимущества своих устройств хранения данных NVMe при подключении через сети Ethernet или InfiniBand, что приводит к повышению производительности и снижению задержек.

Источники, доп. ресурсы

[1] Marvell Enables NVMe over Fabrics Storage Disaggregation for VMware Virtualized Data Centers. April 16, 2020 – https://www.marvell.com/company/newsroom/marvell-enables-nvme-over-fabrics-storage-disaggregation-for-vmware-virtualized-data-centers.html.

[2] Marvell® FastLinQ® QL45611HLCU Adapter. 02/2021 https://www.marvell.com/content/dam/marvell/en/public-collateral/ethernet-adapter-sandcontrollers/marvell-ethernet-adapters-fastlinq-45000-series-product-brief.pdf https://www.marvell.com/products/еthernet-adapters-and-controllers/45000-ethernet-adapters.html.

[3] NVIDIA Announces Spectrum High-Performance Data Center Networking Infrastructure Platform. March 22, 2022 – https://www.globenewswire.com/en/news-release/2022/03/22/2407917/0/en/NVIDIA-Announces-Spectrum-High-Performance-Data-Center-Networking-Infrastructure-Platform.html.

[4] NVIDIA CONNECTX-7. InfiniBand In-Network Computing Adapter – https://www.pny.com/file%20library/company/support/product%20brochures/nvidia%20networking%20solutions/networking-datasheet-infiniband-connectx-7-ds.pdf.

[5] Remote Direct Memory Access (RDMA). By Robert SheldonJames Alan Miller, Senior Executive Editor – https://www.techtarget.com/searchstorage/definition/Remote-Direct-Memory-Access.

[6] A Comprehensive Study on Off-path SmartNIC, Xingda Wei, Rongxin Chen, Yuhan Yang, Rong Chen and Haibo Chen. Institute of Parallel and Distributed Systems, Shanghai Jiao Tong University, 15 Dec 2022 – https://www.researchgate.net/publication/366321108_A_Comprehensive_Study_on_Offpath_SmartNIC.

[7] Intel® Ethernet Network Adapters product guide. Introducing the Intel® Ethernet 800 Series – https://cdrdv2.intel.com/v1/dl/getContent/252454.

[8] Intel® Ethernet Network Adapters product guide for OCP. Introducing the Intel® Ethernet 800 Series – https://cdrdv2.intel.com/v1/dl/getContent/639129.

[9] VMware vSAN with RDMA Acceleration Using Intel® Ethernet 800 Series Network Adapters Presentation – https://cdrdv2.intel.com/v1/dl/getContent/726746?explicitVersion=true.

Авторы: Гантимуров А.П., Калашник А.Г.

Добавить комментарий

Комментариев пока нет