Введение

По мере того как AI/ML/DL-технологии проникают во все сферы деятельности человека, усиливается потребность интеграции поддерживающих аппаратных (GPU, нейропроцессоры, FPGA и др.) компонент AI/ML/DL в существующие ИТ-инфраструктуры, а также их адаптации (включая СХД) к новым нагрузкам.

Можно выделить три направления, в рамках которых развивается эта тема: со стороны решений, связанных с аналитикой больших данных, “классических” HPC-решений и в рамках построения CDI-решений (Composable Disaggregated Infrastructure) на базе CXL/PCIe-фабрик.

HPC–AI-решения могут создаваться под заданную нагрузку или быть максимально адаптируемыми при изменении ее характера/объема. В первом случае ключевым элементом таких решений является отсутствие узких мест при поддержке нагрузок, на которые ориентированы эти решения, т.е. их сбалансированность. А это, в свою очередь, позволяет минимизировать стоимость единицы условной операции при обработке данных и максимизации утилизации ресурсов. Примерами таких решений являются разработки на основе “жестких” конфигураций при заданных показателях масштабируемости.

Во втором случае решение может “на лету” адаптироваться/реконфигурироваться под меняющуюся нагрузку. Т.е. каждой задаче/подзадаче “на лету” из общего пула выделяется ровно столько конкретных (ядер CPU, специализированных вычислителей, памяти с определенной скоростью/задержкой доступа, объемов для постоянного хранения данных и др.) ресурсов, сколько ей требуется на данном этапе выполнения. Т.е. общий средний характер нагрузки может оставаться постоянным, но утилизация ресурсов достигается большая за счет того, что они на каком-то этапе не блокируются задачей, если они ей не нужны (необходимо заметить, что, например, HPC-задачи могут выполняться в течение дней/недель и более дней). В этом случае и масштабирование проходит с меньшими сложностями, позволяя наращивать ресурсы более мелкими “порциями” и одновременно работать с компонентами разных поколений и от разных вендоров. Пример таких решений – CDI-решения на базе CXL/PCIe-фабрик.

Во втором случае решение может “на лету” адаптироваться/реконфигурироваться под меняющуюся нагрузку. Т.е. каждой задаче/подзадаче “на лету” из общего пула выделяется ровно столько конкретных (ядер CPU, специализированных вычислителей, памяти с определенной скоростью/задержкой доступа, объемов для постоянного хранения данных и др.) ресурсов, сколько ей требуется на данном этапе выполнения. Т.е. общий средний характер нагрузки может оставаться постоянным, но утилизация ресурсов достигается большая за счет того, что они на каком-то этапе не блокируются задачей, если они ей не нужны (необходимо заметить, что, например, HPC-задачи могут выполняться в течение дней/недель и более дней). В этом случае и масштабирование проходит с меньшими сложностями, позволяя наращивать ресурсы более мелкими “порциями” и одновременно работать с компонентами разных поколений и от разных вендоров. Пример таких решений – CDI-решения на базе CXL/PCIe-фабрик.

В публикации дан обзор двух бандлов от двух разработчиков – Vast Data и PEAK:AIO, которые условно можно отнести к классу “жестких” конфигураций. Ценность данного обзора состоит в технологических новых аспектах ПО доступа к данным и соотношении характеристик производительности аппаратных компонент решений (при заданной нагрузке), позволяя на их основе прогнозировать требования к конфигурациям бандлов уже с другими компонентами (например, более новых поколений).

Универсальное хранилище Vast Data с NVIDIA DGX A100 системами

Система DGX A100 — это универсальная система для всех рабочих нагрузок ИИ, предлагающая высокую плотность вычислений, производительность и гибкость первой в мире системы ИИ с производительностью 5 петафлопс. Система DGX A100, построенная на базе графического процессора NVIDIA A100 с тензорными ядрами, позволяет объединять рабочие нагрузки обучения, логических выводов и аналитики в единую унифицированную инфраструктуру искусственного интеллекта центра обработки данных. Система DGX A100 — это больше, чем просто сервер. Она является фундаментальным строительным блоком инфраструктуры искусственного интеллекта и частью комплексного решения NVIDIA для центров обработки данных.

VAST Data, пионер концепции Universal Storage, поставляет системы хранения данных на флэш-дисках для широкого спектра рабочих нагрузок и сценариев использования. Созданный для обеспечения высокой производительности, VAST также устранил компромисс между емкостью хранилища и производительностью, обеспечив большую емкость и высокую производительность по цене, более низкой, чем традиционные системы хранения на основе флэш-памяти [1].

В 2020 году VAST Data представила LightSpeed как продукт и философию хранения для рабочих нагрузок на основе ИИ, оптимизированную для простоты и скорости. Новые кластеры VAST Data Universal Storage, созданные с использованием корпусов LightSpeed, обеспечивают вдвое большую пропускную способность ввода-вывода по сравнению с предыдущими корпусами. Кроме того, в VAST добавлена поддержка ряда улучшений на стороне клиента NFS для достижения лучшей в своем классе пропускной способности для приложений ИИ и серверов графических процессоров без использования сложных параллельных файловых систем.

Рис. 1. NFS Multipath объединяет несколько сетевых интерфейсов DGX A100 для повышения пропускной способности удаленного хранилища со встроенной функцией высокой доступности.

NFS–over–RDMA

Сетевая файловая система (NFS) — это популярный протокол, используемый для удаленного доступа к файлам по сети, и благодаря своей простоте он широко используется в корпоративных средах для многочисленных приложений. Однако в специализированных средах NFS исторически считалась слишком медленной для требований высокой производительности.

Но благодаря поддержке удаленного прямого доступа к памяти (RDMA, Remote Direct Memory Access) NFS теперь может повысить эффективность передачи данных за счет обхода CPU и памяти на стороне клиента при использовании сетей InfiniBand или RDMA-over-Converged Ethernet (RoCE). Это приводит к более высокой пропускной способности и меньшей задержке при сохранении простоты эксплуатации и знакомства с этим отраслевым стандартным протоколом хранения.

NFS Multipath

Хотя NFS-over-RDMA оптимизирует пропускную способность через один сетевой интерфейс на стороне клиента, некоторым приложениям, например, работающим на графических процессорах, требуется более высокая пропускная способность, чем может обеспечить одно сетевое соединение. По умолчанию NFS использует один IP-адрес и TCP-соединение для ввода-вывода, ограничивая общую пропускную способность большинства систем NAS до 2 ГБ/с. NFS Multipath облегчает использование нескольких IP-адресов и сетевых подключений для ввода-вывода, фактически объединяя различные сетевые каналы для предоставления доступа к одной файловой системе при одновременно увеличивая общую пропускную способность (рис. 1).

Компания VAST Data разработала новое многопутевое решение на основе nconnect (присутствует в NFS 4.1) и снова интегрировала эту функцию. Эти улучшения с открытым исходным кодом были представлены для включения как в предыдущие, так и в будущие дистрибутивы Linux.

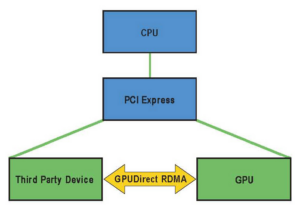

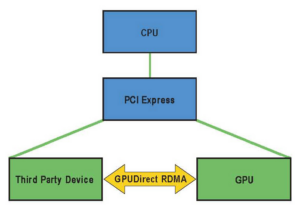

NVIDIA GPUDirect Storage

Устранение потенциальных узких мест в системе повышает производительность и эффективность рабочих нагрузок ИИ. NVIDIA GPUDirect™ Storage (GDS), одна из семейства технологий, являющихся частью NVIDIA Magnum IO™, обеспечивает прямой путь для прямого доступа к памяти (DMA) между хранилищем и памятью графического процессора без нагрузки на ЦП. Это приводит к значительному снижению загрузки ЦП на сервере графического процессора, а также к увеличению пропускной способности хранилища и уменьшению задержки.

Как один из первых партнеров NVIDIA GDS, VAST Data теперь поддерживает GDS через LightSpeed v3.4+. Используя NFS-over-RDMA в качестве протокола хранения, приложения с поддержкой GDS теперь могут извлечь выгоду из повышенной производительности между системами NVIDIA DGX и хранилищем VAST Data all-flash.

Требования к хранилищу для приложений ИИ

При проектировании инфраструктуры для ИИ-приложений архитекторы систем хранения обычно должны идти на компромиссы (например, между постоянной памятью и DRAM, SSD и HDD), чтобы сбалансировать потребности в производительности, емкости и стоимости.

Неправильный баланс часто может привести к низкой производительности обучения, ограниченной скоростью, с которой данные могут считываться и повторно считываться из хранилища.

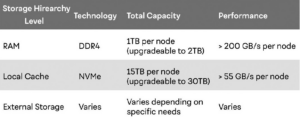

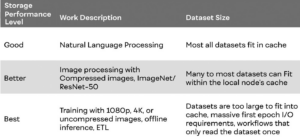

Табл. 1: Иерархия памяти/хранения для поддержки DGX A100.

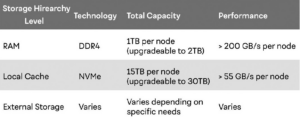

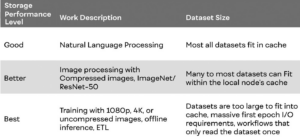

Табл. 2. Три различных уровня производительности, необходимых для обычных рабочих нагрузок ИИ и размеров наборов данных.

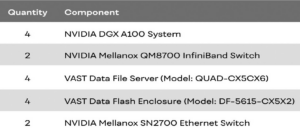

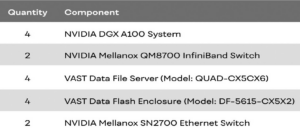

Табл. 3. Аппаратные компоненты.

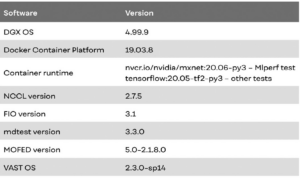

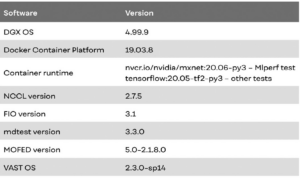

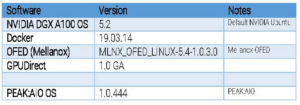

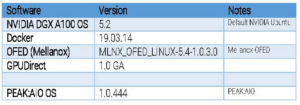

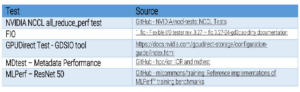

Табл. 4. Версии ПО и бенчмарков.

Традиционно иерархия хранения и кэширования используется для противодействия компромиссам между производительностью, емкостью и стоимостью. В табл. 1 показана типичная иерархия, иллюстрирующая компромиссы между емкостью и производительностью, характерные для системы DGX A100.

Кэширование данных в локальной оперативной памяти обеспечивает наилучшую производительность при чтении. Это кэширование становится прозрачным, когда данные считываются из файловой системы хранилища. Однако размер оперативной памяти ограничен и менее рентабелен, чем другие технологии хранения и памяти. Локальное хранилище NVMe — это более экономичный способ обеспечить кэширование рядом с графическими процессорами. Однако ручная репликация наборов данных на локальный диск может быть утомительной и трудоемкой и не является подходящим местом для долгосрочного хранения наборов данных.

Несмотря на то, что решения для внешнего хранения сильно различаются по производительности, выбор внешней системы хранения, способной обеспечить производительность, которая соответствует или превосходит локальный кэш, устраняет необходимость в сложных стратегиях кэширования.

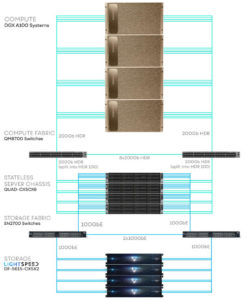

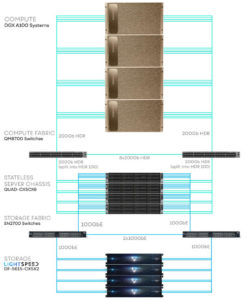

Рис. 2. Валидированная архитектура VAST Data с DGX A100 системами.

Рабочие нагрузки и рекомендации по размеру набора данных

Идеальная архитектура DGX POD также должна обеспечивать хороший баланс между стоимостью и производительностью для ряда распространенных типов моделей глубокого обучения, включая обработку изображений, рекомендации и обработку естественного языка. В табл. 2 представлены три различных уровня производительности, необходимых для обычных рабочих нагрузок ИИ и размеров наборов данных.

Понимание конкретных требований к рабочей нагрузке может в значительной степени помочь понять, как следует проектировать инфраструктуру для приложений ИИ. Однако, если внешняя система хранения способна масштабировать как производительность, так и емкость с первого дня, приспосабливаться к изменяющимся требованиям к рабочей нагрузке будет намного проще.

Обзор решения

Хотя архитектура VAST Data DASE линейно масштабируется как для большей емкости, так и для конфигураций с более высокой производительностью, эта эталонная архитектура служит руководством для идеального развертывания хранилища для группы из четырех систем DGX A100. Эта комбинация универсального хранилища VAST Data, аппаратного и программного обеспечения для вычислений ИИ от NVIDIA, а также сетей Infiniband и Ethernet от NVIDIA дает представление об ожидаемой производительности для репрезентативного набора рабочих нагрузок ИИ (рис. 2). В табл. 3 представлены аппаратные компоненты решения, а в табл. 4 – версии ПО и бенчмарков.

Сетевая конфигурация

Уникальная дезагрегированная архитектура VAST Data обеспечивает поддержку сетей Ethernet и InfiniBand как для клиентских сетей, так и для серверных фабрик хранения. В этой конкретной эталонной архитектуре вычислительная фабрика InfiniBand системы DGX A100 используется для систем хранения VAST Data, что обеспечивает высокую пропускную способность и малую задержку при вводе-выводе с использованием простого клиентского протокола NFS:

- каждая система DGX A100 подключается через восемь (8) портов 200 Gb HDR InfiniBand;

- каждый файловый сервер данных VAST имеет двойное подключение и подключается через один (1) порт HDR InfiniBand 100 Гбит/с (с помощью двустороннего разветвителя от порта коммутатора 200 Гбит/с) для обслуживания запросов на хранение от систем DGX A100, а также для подключения к Внутреннее хранилище (Ethernet) через два (2) порта 100 GbE;

- каждая система DGX A100 подключается через восемь (8) портов 200 Gb HDR InfiniBand;

- каждый файловый сервер данных VAST имеет двойное подключение и подключается через один (1) порт HDR InfiniBand 100 Гбит/с (с помощью двустороннего разветвителя от порта коммутатора 200 Гбит/с) для обслуживания запросов на хранение от систем DGX A100, а также для подключения к Внутреннее хранилище (Ethernet) через два (2) порта 100 GbE;

Рис. 3. Результаты теста пропускной способности NCCL.

- каждый корпус VAST Data Flash Enclosure через четыре (4) порта 100 GbE подключается к фабрике внутреннего хранилища (Ethernet);

- коммутаторы InfiniBand и Ethernet развертываются в паре для обеспечения высокой доступности.

- каждый корпус VAST Data Flash Enclosure через четыре (4) порта 100 GbE подключается к фабрике внутреннего хранилища (Ethernet);

- коммутаторы InfiniBand и Ethernet развертываются в паре для обеспечения высокой доступности.

Методология тестирования и результаты

Конфигурация этого решения была протестирована путем измерения каждого эталонного показателя при масштабировании систем DGX A100 от одной до четырех при работе с устройствами хранения VAST Data [1].

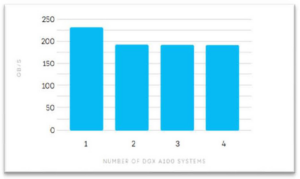

Тесты NCCL: all_reduce_perf

Библиотека NVIDIA Collective Communications Library (NCCL) реализует примитивы коллективной связи с несколькими GPU и несколькими узлами, производительность которых оптимизирована для графических процессоров NVIDIA. Этот тест NCCL предназначен для проверки масштабируемости нескольких систем DGX A100, чтобы убедиться в отсутствии узких мест при обмене данными между графическими процессорами (GPU-to-GPU) в последующих тестах.

Для одной системы DGX A100 максимальная пропускная способность должна быть ограничена внутренней пропускной способностью межсоединения NVIDIA NVLink®. Для нескольких систем DGX A100 максимальная пропускная способность должна приближаться к общей совокупной пропускной способности всех сетевых адаптеров, используемых для связи между графическими процессорами в одной системе.

Результаты теста NCCL показывают (рис. 3), что пропускная способность между графическими процессорами одной системы DGX A100 достигает максимальной пропускной способности внутренних возможностей коммутации NVLink. При масштабировании до двух, трех и четырех систем DGX A100 пропускная способность между графическими процессорами в нескольких системах приближается к совокупной пропускной способности восьми сетевых адаптеров InfiniBand, выделенных для вычислений для каждого DGX A100.

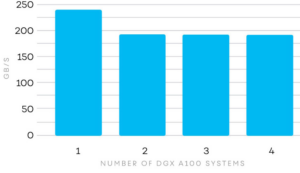

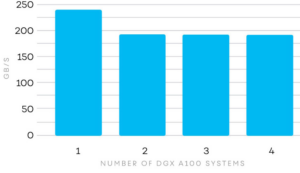

Пропускная способность FIO и IOPS

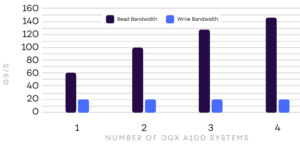

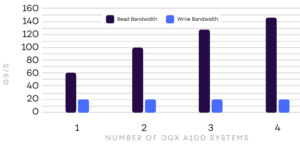

Рис. 4. Результаты пропускной способности FIO по чтению и записи.

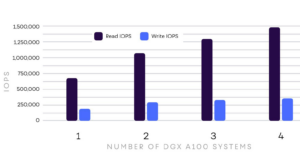

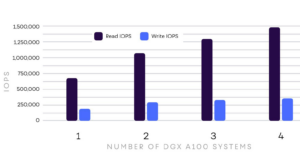

Рис. 5. Результаты IOPS FIO по чтению и записи.

Рис. 6. Результаты теста MLPerf ResNet-50.

Гибкий тестер ввода-вывода (FIO, Flexible IO tester) – это синтетический эталонный инструмент с открытым исходным кодом, полезный для измерения операций ввода-вывода локальных или внешних/удаленных целей хранения. FIO может генерировать различные рабочие нагрузки ввода-вывода и поддерживает возможность масштабирования тестирования с использованием нескольких клиентов одновременно.

Были проведены отдельные тесты для измерения пропускной способности хранилища данных VAST, чтобы смоделировать сценарии рабочей нагрузки со 100% чтением и 100% записью.

Ниже приведены конкретные параметры конфигурации FIO, используемые для этих тестов:

- ioengine = posixaio;

- direct = 1;

- blocksize = 1024k для теста пропускной способности, 4k для теста IOPS;

- numjobs = 144 для теста пропускной способности, 288 для теста IOPS;

- iodepth = 16;

- ioengine = posixaio;

- direct = 1;

- blocksize = 1024k для теста пропускной способности, 4k для теста IOPS;

- numjobs = 144 для теста пропускной способности, 288 для теста IOPS;

- iodepth = 16;

- size = 4194304k.

Результаты теста FIO демонстрируют пропускную способность более 140 ГБ/с при чтении (рис. 4) и почти 1,5 млн IOPS при чтении (рис. 5) из четырех систем DGX A100. Эта совместная эталонная архитектура NVIDIA и VAST Data разумно разработана для использования дополнительных сетевых адаптеров 200 Гбит/с в каждом DGX A100 для трафика хранилища, когда это необходимо, и в то же время обеспечивает максимальную пропускную способность нескольких систем между графическими процессорами. Тесты также показывают производительность записи 20 ГБ/с (максимальная пропускная способность, рассчитанная для этой конкретной конфигурации хранилища), что достаточно для ориентированных на чтение рабочих AI-нагрузок.

MLPerf Training v0.7 – ResNet-50

MLPerf Training – это стандартный отраслевой набор эталонных тестов для измерения того, насколько быстро системы могут обучать модели целевой метрике качества. В этом конкретном тесте используется нейронная сеть ResNet-50, известная сеть классификации изображений, которую можно использовать с набором данных ImageNet. При целевом уровне качества 75,90% эта тестовая рабочая нагрузка требует значительных вычислительных ресурсов и операций ввода-вывода.

Результаты теста MLPerf показывают (рис. 6) высокую близкую к нулю разницу между производительностью в нулевой эпохе по сравнению со средней общей производительностью в последующие эпохи. Поскольку первая эпоха считывает данные непосредственно из файловой системы в локальный кеш (откуда они считываются во все последующие эпохи), файловая система испытывает наибольшую нагрузку в течение первой эпохи и оказывает меньшее влияние на более поздние проходы. Тот факт, что разница между первой эпохой и общим средним значением настолько мала, показывает, что файловая система VAST Data без проблем справляется со спросом на этот тест.

Масштабирование универсального хранилища VAST Data

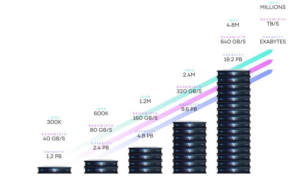

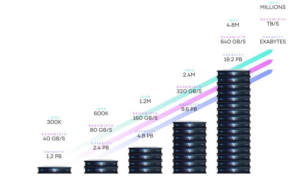

Эталонная архитектура, состоящая из четырех (4) корпусов VAST Data Flash, является проверенным строительным блоком для проектирования и развертывания современной инфраструктуры искусственного интеллекта с системами DGX A100. Демонстрируемая производительность должна служить ориентиром для минимальной производительности, ожидаемой от этой конкретной конфигурации. По мере расширения инициатив организации в области искусственного интеллекта и роста наборов данных архитектура DASE VAST Data дает возможность беспрепятственно масштабировать емкость хранилища (до эксабайтов) и производительность хранилища линейно (до ТБ/с+), чтобы удовлетворить меняющиеся потребности каждой рабочей нагрузки ИИ сегодня и в будущем (рис. 7).

Рис. 7. VAST Data линейно масштабирует производительность благодаря системам, использующим NVMe-флеш-память.

VAST Data: крупнейший выпуск ПО за всю историю

В конце февраля 2023 г. VAST Data выпустила релиз v4.6 – v4.7 своей VAST OS, являющийся самым крупным обновлением за всю историю VAST Data. Среди новшеств [2]:

- каталогизация в табличном виде неструктурированных данных, что дает возможность работы с ними как базами данных по SQLзапросам;

- расширенные возможности QOS для каждого пользователя;

- расширенные возможности управления ключами шифрования;

- теперь клиенты могут делать до 100 000 моментальных снимков с любой глубиной пространства имен с точностью до 15 сек;

- прогнозирование использования ресурсов на основе обучаемой модели;

- расширенная поддержка концепции Zero-Trust;

- CSI VAST теперь поддерживает различные классы хранения для постоянных и эфемерных томов контейнеров Kubernetes.

- каталогизация в табличном виде неструктурированных данных, что дает возможность работы с ними как базами данных по SQLзапросам;

- расширенные возможности QOS для каждого пользователя;

- расширенные возможности управления ключами шифрования;

- теперь клиенты могут делать до 100 000 моментальных снимков с любой глубиной пространства имен с точностью до 15 сек;

- прогнозирование использования ресурсов на основе обучаемой модели;

- расширенная поддержка концепции Zero-Trust;

- CSI VAST теперь поддерживает различные классы хранения для постоянных и эфемерных томов контейнеров Kubernetes.

Среди ключевых отличий VAST Data от других предложений на рынке следующие [3]:

- производительность All–Flash: VAST — это унифицированная платформа данных, которая демократизирует быстрый доступ ко всем данным с помощью all-flash. Платформа представляет себя приложениям и пользователям как хранилище объектов и масштабируемая система NAS. Структурированные и неструктурированные данные могут быть загружены из самых разных приложений и источников в единый унифицированный репозиторий для анализа и обработки;

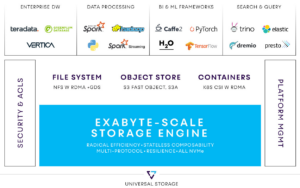

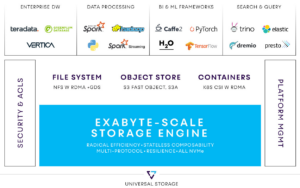

- многопротокольный доступ к данным (рис. 8): объектный интерфейс VAST (S3) обеспечивает интеграцию с наборами инструментов для анализа больших данных, такими как MapReduce, HIVE и Spark. Кроме того, он поддерживает механизмы распределенных запросов (например, Dremio, Trino, Presto) и хранилища данных с ускорением на GPU (например, SQream). Поскольку VAST может представлять пространство имен с использованием стандартных NFSv3 и NFSv4, система также поддерживает традиционные аналитические приложения и базы данных, такие как SAS Grid, Postgres и KDB. Teradata, Splunk, ElasticSearch и Vertica могут интегрироваться с использованием S3 или NFS.

Рис. 8. Мультипротокольная поддержка доступа к данным VAST Data.

Поскольку VAST также поддерживает Windows SMB-протокол обмена файлами, аналитики и другие пользователи могут легко получать доступ к отчетам и выводить данные со своих рабочих станций без необходимости копирования в отдельную систему хранения или приобретения специальных инструментов или навыков, как это требуется при взаимодействии с системами на основе HDFS. Это означает, что VAST подходит для различных целей, в том числе:

- поддержки устаревших аналитических приложений в стиле хранилища данных (data warehouse);

- поддержки промежуточного уровня обработки данных в озере данных;

- ETL & ELT;

- специальной аналитики (Ad hoc) с использованием таких инструментов, как Presto, Trino, Impala и Dremio;

- новых инструментов AI/ML;

- поддержки устаревших аналитических приложений в стиле хранилища данных (data warehouse);

- поддержки промежуточного уровня обработки данных в озере данных;

- ETL & ELT;

- специальной аналитики (Ad hoc) с использованием таких инструментов, как Presto, Trino, Impala и Dremio;

- новых инструментов AI/ML;

- поддержка GPU Direct Storage: VAST предлагает инновационный подход к AI/ML/DL за счет повышения активности и эффективности GPU. Использование GPU Direct Storage позволяет передавать данные, поступающие из VAST, напрямую с сетевой карты на сервере GPU в память GPU. Это приводит к более высокой пропускной способности, а также к устранению накладных расходов графического процессора на обработку ввода-вывода;

- ведущее в мире сокращение данных: VAST обеспечивает лучшее в своем классе сокращение данных с помощью алгоритмов данных, основанных на сходстве. Для структурированных или полуструктурированных данных в формате значений, разделенных запятыми или табуляцией, VAST обеспечивает сокращение данных от 3:1 до 4:1 без какого-либо ущерба для производительности. Даже если данные были предварительно сжаты, как в случае с такими форматами, как Parquet, обеспечивается дополнительная экономия 1,45:1;

- современная архитектура для современных рабочих нагрузок: VAST использует DASE-подход (Disaggregated Shared Everything) к архитектуре хранения. Этот уникальный и хорошо масштабируемый подход позволяет клиентам масштабировать емкость хранилища независимо от его производительности. Им не нужно поддерживать фиксированное соотношение емкости и производительности, и они могут настраивать систему по мере изменения своих потребностей с течением времени.

- поддержка GPU Direct Storage: VAST предлагает инновационный подход к AI/ML/DL за счет повышения активности и эффективности GPU. Использование GPU Direct Storage позволяет передавать данные, поступающие из VAST, напрямую с сетевой карты на сервере GPU в память GPU. Это приводит к более высокой пропускной способности, а также к устранению накладных расходов графического процессора на обработку ввода-вывода;

- ведущее в мире сокращение данных: VAST обеспечивает лучшее в своем классе сокращение данных с помощью алгоритмов данных, основанных на сходстве. Для структурированных или полуструктурированных данных в формате значений, разделенных запятыми или табуляцией, VAST обеспечивает сокращение данных от 3:1 до 4:1 без какого-либо ущерба для производительности. Даже если данные были предварительно сжаты, как в случае с такими форматами, как Parquet, обеспечивается дополнительная экономия 1,45:1;

- современная архитектура для современных рабочих нагрузок: VAST использует DASE-подход (Disaggregated Shared Everything) к архитектуре хранения. Этот уникальный и хорошо масштабируемый подход позволяет клиентам масштабировать емкость хранилища независимо от его производительности. Им не нужно поддерживать фиксированное соотношение емкости и производительности, и они могут настраивать систему по мере изменения своих потребностей с течением времени.

PEAK:AIO

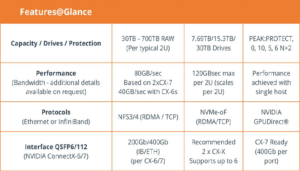

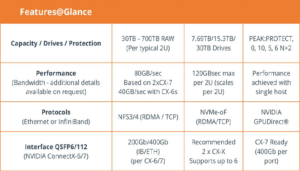

В начале марта 2023 г. PEAK:AIO (https://www.peakaio.com/) совместно с партнерами представила свою новую версию SDSплатформы для AIнагрузок, которая удваивает производительность одного

узла хранения (1U) до 80 Гбайт/с по сравнению с предыдущей версией. ПО PEAK:AIO развертывается на готовой серверной платформе: Dell, PNY и др. PEAK:AIO – молодая компания, но ее основатели имеют более чем 20летний опыт SDSразработок. Основные характеистики SDS PEAK:AIO представлены в табл. 5.

Табл. 5. Основные характеристики последней версии SDS PEAK:AIO.

Рис. 9. Позиционирование SDS PEAK:AIO.

Современные серверы ИИ потребляют и анализируют данные с гораздо большей скоростью, чем многие устаревшие решения для хранения данных, что приводит к низкой загрузке графического процессора и значительному увеличению времени обучения, что снижает производительность. Во многих отношениях этот быстрый рост застал мир систем хранения врасплох.

Стандартный подход традиционного поставщика к удовлетворению потребностей в производительности заключался в том, чтобы втиснуть хранилище корпоративного класса вместе с их ненужными функциями в решение ИИ. Это просто приводит к значительным расходам, которые резко влияют на бюджет ресурсов графического процессора.

Второй подход заключается в использовании сложных и дорогих параллельных файловых систем, разработанных для сред высокопроизводительных вычислений, которые часто управляются сотнями серверов, а не небольшими, часто изолированными кластерами серверов DGX. Такие решения не только были разработаны для больших масштабов, но также требуют расширенных навыков и навыков администрирования систем хранения или дорогих решений, поддерживаемых поставщиками.

90% проектов ИИ не имеют дело с многопетабайтными данными, вместо этого они обычно управляются отдельными или небольшими кластерами серверов, работающими с очищенными хорошими данными меньшего масштаба. Соответственно, им нужны простые и доступные серверы данных уровня ИИ, которые обеспечивают производительность, необходимую для графических и центральных процессоров, но без дорогостоящего и сложного устаревшего хранилища с функциями, которые были разработаны в десятилетие больших данных или для него.

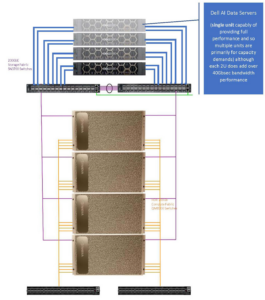

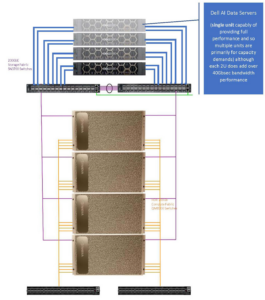

В отличие от перепрофилирования традиционного хранилища для принудительного соответствия ИИ, PEAK:AIO в сотрудничестве с DellEMC разработала AI Data Server на базе Dell с нуля для рабочих нагрузок ИИ и оптимизированный для линейки устройств ИИ NVIDIA DGX. Он обеспечивает сверхнизкую задержку и огромную пропускную способность по цене, которая позволяет больше инвестировать в ресурсы графического процессора и меньше вкладываться в дорогое и медленное хранилище.

Решение Dell Powered AI Data Solution создает центральный пул NVMe со сверхнизкой задержкой, который можно использовать между одним или несколькими серверами DGX. Предоставление каждому DGX идеального уровня ресурсов без необходимости предварительных инвестиций. Простое подключение через совместимый с NVIDIA InfiniBand/Ethernet уникальный протокол RDMA гарантирует, что ресурс NVMe виден так, как если бы он был внутренним для DGX.

Широкий диапазон масштабируемости

Учитывая, что для многих новых проектов искусственного интеллекта и решений для логического вывода требуется лишь ограниченный объем хранилища, сервер данных ИИ на базе Dell PEAK:AIO начинается с 30 ТБ, обеспечивая при этом полную производительность, с возможностью масштабирования до 360 ТБ в одном 2U корпусе.

Гибкая отказоустойчивость

PEAK:AIO на базе AI Data Server от Dell имеет переменную защиту RAID, которая обеспечивает различные уровни отказоустойчивости с усовершенствованной многопоточной структурой, соответствующей требованиям ИИ. Рекомендуемая конфигурация — RAID6e, поддерживаются RAID 1, 10, 5e и 6e.

Протоколы и файловые системы

PEAK:AIO AI Data Server на базе Dell поддерживает как блочное хранилище, так и сетевую файловую систему с несколькими вариантами протокола RDMA.

NFS over RDMA (NFS-over-RDMA)

Сетевая файловая система (NFS) традиционно была популярным протоколом для удаленного доступа к файлам по сети в корпоративной среде из-за ее простоты. Однако для ИИ традиционная или стандартная NFS корпоративного уровня исторически была слишком медленной для таких высоких требований к производительности.

DellEMC и PEAK:AIO сосредоточились на усовершенствованном поколении NFS, в котором используются преимущества поддержки RDMA от NVIDIA и Mellanox.

С добавлением поддержки RDMA сервер PEAK:AIO на базе AI Data Server от Dell теперь может обеспечивать гораздо более высокую производительность, способную поддерживать требования нескольких хостов DGX. Поддерживается RDMA NFS over InfiniBand и Ethernet (RoCE V2). Последний является популярным выбором для новых начинающих проектов из-за более широкого использования Ethernet.

NFS over TCP (NFS-over-TCP)

Там, где RDMA может быть недоступен, будь то из-за ограничений сети или отсутствия хостов, поддерживающих RDMA, PEAK:AIO на базе AI Data Server от Dell предоставляет расширенный вариант NFS на основе TCP, который по-прежнему может обеспечивать полную пропускную способность и максимальную совместимость.

NFS RDMA Multipath

Существенным ограничением производительности устаревшего хранилища и большинства современных решений NFS является отсутствие эффективного метода многопутевого доступа. В результате ограничение производительности связано со скоростью одного сетевого подключения. В случае DGX A100 устаревший NFS будет ограничен интерфейсом 200 Gbe, примерно 23 ГБ/с. Или, скорее всего, интерфейсом 100 Gbe на сервере хранения, что дает 11 ГБ/сек.

Различные конфигурации используются, чтобы попытаться распределить данные по нескольким каналам, но в рамках ИИ это в лучшем случае проблематично и, как правило, нецелесообразно без квалифицированной команды по хранению данных, эффективно размещающей и организующей данные.

Поскольку NFS постоянно развивается, ядро Linux представило структуру в последней ветке ядра vanilla, которая определяет приемлемую многопутевую архитектуру для NFS4. Это несовместимо с многопутевыми методами, представленными другими поставщиками, и PEAK:AIO разработала и представила первый многопутевой дизайн NFS4, совместимый с дорожной картой ядра.

Помимо NFS4, PEAK:AIO также разработала multipath для NF3, которая известна своей задержкой и преимуществами в производительности при работе с файлами меньшего размера.

Результат гарантирует, что с помощью инструментов PEAK:AIO сервер PEAK:AIO на базе AI Data Server от Dell может использовать все доступные каналы передачи данных для обеспечения максимальной производительности и без расширенного администрирования или организации данных.

Тесты показывают, что даже базовый 2U PEAK:AIO AI Data Server от Dell может поддерживать производительность четырех каналов с многопутевым инструментом для агрегирования каналов на стороне клиента без каких-либо дополнительных инструментов или администрирования. Многопутевое подключение PEAK:AIO работает как для RDMA, так и для TCP NFS.

NVMe–over–Fabric

NVMe-over-Fabric (NVMe-oF) обеспечивает сверхнизкую задержку для централизованной флэш-памяти NVMe. Блочное хранилище, как правило, используется с локальными файловыми системами, такими как XFS, и поэтому обычно не поддерживает совместное использование данных и в основном используется в конфигурациях DGX с одним или без совместного использования данных. Благодаря характеру и дизайну NVMe-oF он обеспечивает наименьшую задержку и высочайшую производительность, однако ему не хватает масштабируемости кластера с точки зрения хоста.

NVMe-oF часто используется для новых проектов, которые в основном состоят из одного сервера DGX, и является лучшим новым начальным протоколом. Также полезно предоставить, например, небольшой резервный пул или сверхвысокую производительность, например, для приложения базы данных или автономного проекта, не требующего совместного использования данных.

PEAK:AIO на базе AI Data Server от Dell включает в себя уникальное преобразование блочной файловой системы в сетевую, что позволяет пользователям использовать преимущества NVMe-oF на ранних этапах и конвертировать, например, в RDMA NFS по мере необходимости.

NVIDIA GPUDirect Storage

GPU потребляют данные намного быстрее, чем ЦП, и по мере увеличения вычислительной мощности графического процессора растет потребность в пропускной способности ввода-вывода. Это означает, что в суперкомпьютерах, таких как линейка NVIDIA DGX, центральные процессоры являются узким местом для графических процессоров, если данные должны проходить или обрабатываться ими.

NVIDIA GPUDirect® — это семейство технологий, входящих в состав Magnum IO, которые улучшают перемещение данных и доступ к ним для графических процессоров NVIDIA в центрах обработки данных. С GPUDirect с поддержкой PEAK:AIO, в отличие от традиционных решений для хранения данных, данные можно напрямую считывать и записывать в/из памяти графического процессора, полностью минуя ЦП, устраняя ненужные копии памяти, снижая нагрузку на ЦП и уменьшая задержку, что приводит к значительному повышению производительности. DellEMC и PEAK:AIO поддерживают GPUDirect как для RDMA NFS, так и для NVMe-oF (рис. 10).

Тестирование

Тесты предназначены для демонстрации масштаба четырех серверов DGX и до четырех серверов PEAK:AIO на базе AI Data Server от Dell. Это не означает, что для каждого DGX требуется сервер данных ИИ на базе PEAK:AIO Dell, на самом деле, одного сервера данных ИИ на базе PEAK:AIO Dell в тестах оказалось достаточно для управления четырьмя DGX.

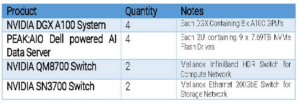

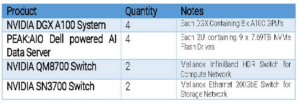

В табл. 6, 7 описаны аппаратные компоненты, которые использовались для проверки этого решения.

Рис. 10. PEAK:AIO поддерживают GPUDirect как для RDMA NFS, так и для NVMe-oF.

Табл. 6. Характеристики оборудования.

Табл. 7. Характеристики ПО.

Обзор решения

Основной задачей разработки DellEMC и PEAK:AIO было обеспечение производительности, характерной для крупномасштабных систем хранения данных корпоративного и HPC-класса, с гораздо более простой реализацией и более низкой ценой. Устранение сложности и необходимости чрезмерных инвестиций в хранилище или администрирование и поддержку хранилища.

PEAK:AIO AI Data Server на базе Dell специально разработан для масштабирования от ранней стадии проекта до более крупного POD или периферийного решения. Учитывая, что большинство проектов начинаются с одного DGX, было важно, чтобы решение обеспечивало производительность даже при небольшой точке входа, всего лишь 30 ТБ.

Для тестирования RDMA NFS от однго до четырех DGX использовалась конфигурация показанная на рис. 11. Четыре сервера PEAK:AIO на базе AI Data Server от Dell были подключены через порты NVIDIA Mellanox CX-6. Четыре DGX использовали HDR InfiniBand для вычислительной сети.

PEAK:AIO AI Data Server на базе Dell не требует узла контроллера, а каждый узел хранения NVMe действует как целостное устройство, что снижает стоимость и сложность.

Рис. 11. Конфигурация тестируемого решения.

Табл. 8. Тесты.

Тесты показывают характеристики производительности, необходимые для обеспечения продуктивного и эффективного решения, необходимого для репрезентативного набора рабочих нагрузок ИИ.

Методология тестирования и результаты

Тесты NCCL: all_reduce_perf (табл. 8)

Библиотека NVIDIA Collective Communications Library (NCCL) проверяет максимальную масштабируемость нескольких систем DGX A100. В одной системе узким местом является пропускная способность межсоединения графического процессора NVIDIA NVLink.

В нескольких системах узким местом должна быть соединительная фабрика, и ее пропускная способность должна быть близка к максимальной. На рис. 12 показано, что пропускная способность одной системы между графическими процессорами достигает возможностей межсоединений NVLink. Многосистемная пропускная способность между графическими процессорами достигает совокупной пропускной способности всех портов InfiniBand, назначенных для теста.

Результаты теста NCCL показывают, что пропускная способность между графическими процессорами одной системы DGX A100 достигает максимальной пропускной способности внутреннего NVLink. При масштабировании до четырех пропускная способность между графическими процессорами в нескольких системах приближается к совокупной пропускной способности восьми сетевых адаптеров InfiniBand, выделенных для вычислений для каждого DGX A100.

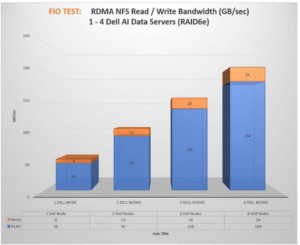

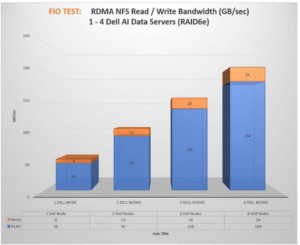

Пропускная способность FIO

Гибкий тестер ввода-вывода (FIO, Flexible IO) — это синтетический тестовый инструмент с открытым исходным кодом, который постоянно используется в отрасли хранения данных для профилирования производительности хранилища. FIO будет генерировать широкий спектр рабочих нагрузок, а полный профиль производительности обычно будет состоять из тестов с размером блока, данных или файла от 4 КБ до 1 МБ. Последний обычно используется для демонстрации пропускной способности и указания максимальной производительности.

Приведенный на рис. 13 тест FIO был запущен с переменными: ioengine: libaio, iodepth: 64, numjobs: 18, direct=1, blocksize=1024K, r/w 100% Seq.

Рис. 12. Результаты тестов NCCL.

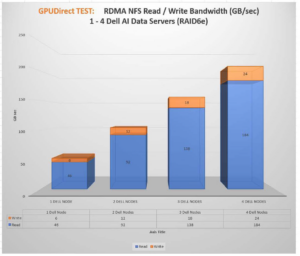

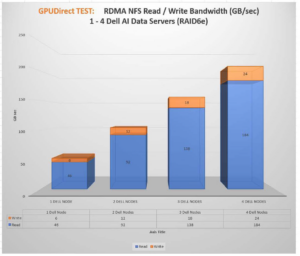

Пропускная способность GPUDirect

NVIDIA® GPUDirect® Storage (GDS) — новейшее дополнение к семейству GPUDirect. GDS обеспечивает прямой путь передачи данных для прямого доступа к памяти (DMA) между памятью графического процессора и хранилищем, что позволяет избежать буфера отказов через ЦП. Этот прямой путь увеличивает пропускную способность системы и снижает задержку и нагрузку на ЦП.

Существует несколько инструментов и утилит для сравнительного анализа хранилища для систем Linux, поскольку GDS является относительно новой технологией, с зависимостями поддержки и определенным набором библиотек и API, которые выходят за рамки стандартных API-интерфейсов ввода-вывода POSIX. Ни одна из существующих утилит генерации нагрузки ввода-вывода хранилища, таких как FIO включить эффективную поддержку GDS.

В результате установка GDS включает в себя генератор нагрузки gdsio, который предоставляет несколько параметров командной строки, которые позволяют генерировать различные характеристики нагрузки ввода-вывода хранилища как через традиционный ЦП, так и через путь данных GDS.

На рис. 14 представлен результат теста пропускной способности чтения/записи со скоростью 1 МБ/с, который, как видно, для операций чтения максимизирует скорость соединения (это соответствует 128 КБ). Кроме того, данные считываются непосредственно в буфер графического процессора, поэтому, хотя производительность на графике выглядит похожей, влияние эффективности графического процессора может быть значительным.

MLPerf Training v0.7 – ResNet-50

MLPerf Training — это стандартный набор эталонных тестов для тестирования производительности систем при обучении моделей до целевого показателя качества. Результаты на рис. 15 основаны на стандартной нейронной сети ResNet-50, известной сети классификации изображений, которую можно использовать с набо ром данных ImageNet. С целевым качеством классификации 75,90

% эта тестовая рабочая нагрузка является достаточно интенсивной как с точки зрения вычислений, так и с интенсивным вводом-выводом.

Результаты теста MLPerf показывают близкую к нулю разницу между производительностью в нулевой эпохе по сравнению со средней общей производительностью в последующие эпохи. Поскольку первая эпоха считывает данные непосредственно из файловой системы, используется локальный кеш, а последующие эпохи считывают данные непосредственно из кеша, поэтому файловая система подвергается наибольшей нагрузке в течение первой эпохи и оказывает меньшее влияние на более поздние проходы.

Рис. 13. Результаты тестов FIO.

Рис. 14. Результаты тестов GDS.

Рис. 15. Результаты тестов MLPerf.

Для получения дополнительной информации о MLPerf см., например, https://ieeexplore.ieee.org/document/9001257.

Масштабирование и PEAK:AIO AI Data Server на базе Dell

PEAK:AIO AI Data Server на базе Dell был специально разработан, чтобы соответствовать проектам DGX на ранней стадии и масштабироваться по мере необходимости. Для достижения этого с нуля был разработан оптимизированный программно-определяемый стек СХД, обеспечивающий начинающим проектам с малой емкостью производительность решения для хранения данных класса HPC/Enterprise.

Помимо производительности, решение обеспечивает простоту, гарантируя, что пользователи и команды могут сосредоточиться на проекте и функциях графического процессора, а не на администрировании хранилища.

Несмотря на то, что 75% решений DGX находятся в POD, содержащих 1-3 сервера DGX, один PEAK:AIO на базе AI Data Server может работать с четырьмя DGX A100, а несколько PEAK:AIO на базе AI Data Server могут масштабироваться до более крупных POD, которые требуют более высокой производительности. производительность и емкость.

Заключение

Заключение

Следует иметь ввиду, что требования к конфигурации значительно зависят от нагрузок. Например, при использовании только потоковых нагрузок требования к сети могут быть значительно ниже при том же объеме передаваемых данных. С увеличением доли случайных операций возрастает значение задержек.

Следует иметь ввиду, что требования к конфигурации значительно зависят от нагрузок. Например, при использовании только потоковых нагрузок требования к сети могут быть значительно ниже при том же объеме передаваемых данных. С увеличением доли случайных операций возрастает значение задержек.

Также не стоит забывать о конструктивной реализации, связанной с охлаждением GPU (выделяющих 100-200 Вт и более). В настоящее время для этого все активнее используется жидкостное охлаждение (которое намного эффективнее воздушного) даже для десктопных вариантов решений.

Также не стоит забывать о конструктивной реализации, связанной с охлаждением

GPU

(выделяющих 100-200 Вт и более). В настоящее время для этого все активнее используется жидкостное охлаждение (которое намного эффективнее воздушного) даже для десктопных вариантов решений.

Источники, доп. ресурсы

[1] ACCELERATING A.I. WORKLOADS AT LIGHTSPEED, JANUARY 2021.

https://vastdata.com/resources/whitepapers/gpu-reference-architecture.

[2] Our Biggest Software Release, By Jeff Denworth February 22, 2023.

[3] VAST Data Ranked #1 for Analytics Use Case in the 2022 Gartner®? Critical Capabilities for Distributed File Systems and Object Storage Report. By Andy Pernsteiner, Field CTO, VAST Data January 11, 2023.

https://vastdata.com/blog/ranked-1-foranalytics-use-case/.

https://peakaio.com/downloads/PEAKAIO_Data_Server_2023.pdf

https://www.peakaio.com/downloads/Dell_AI_Data_Server_Ref_Architecture_for_DGX.pdf

Авторы: Гантимуров А.П., Калашник А.Г.

Отслеживать

Отслеживать